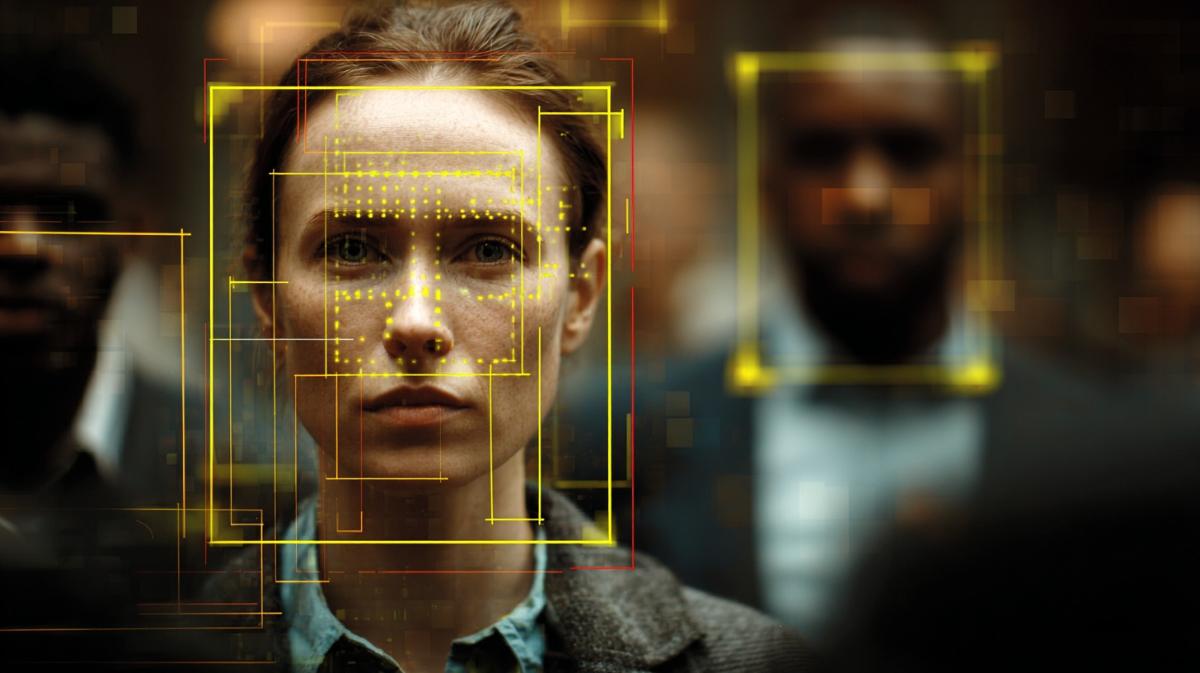

Обычная камера у подъезда — у вас лотерея на ошибочный арест. Угадайте, где вас задержат

Аудит показал как полиция путает людей с преступниками.

Истории о том, как технологии распознавания лиц приводят к ошибочным задержаниям, перестали быть редкостью. В 2020 году житель Детройта Роберт Уильямс оказался под арестом из-за ошибочной идентификации, вызванной низким качеством кадра с камеры наблюдения. 4 года спустя аналогичный случай произошёл в Лондоне: активиста Шона Томпсона система Live Facial Recognition определила как преступника, что закончилось жёсткой полицейской проверкой.

Независимый аудит испытаний лондонской полиции показал, что из 42 совпадений только 8 оказались достоверными. Несмотря на такие провалы, технология активно внедряется в аэропортах, торговых центрах и на улицах городов, а её эффективность оправдывается лабораторными показателями, демонстрирующими до 99,95% точности. Однако такие цифры не отражают реальную картину: в реальных условиях точность значительно ниже.

Чтобы понять, почему лабораторные результаты и практика так различаются, необходимо учитывать специфику эталонных тестов, которые проводит Национальный институт стандартов и технологий США (NIST). Программа Facial Recognition Technology Evaluation (FRTE) стала ориентиром и опорой для внедрения технологии, в том числе в полиции Великобритании. Но такие проверки мало подходят для оценки работы алгоритмов в реальной среде. Они показывают, что система может работать в аэропорту, но это ничего не говорит о её надёжности на шумной улице или в условиях плохой освещённости. В итоге отчёты формируют иллюзию безошибочности, тогда как на практике системы сталкиваются с множеством помех.

Чтобы создать тестовый набор, исследователи собирают базы фотографий, среди которых алгоритмы должны находить совпадения. Но подобные базы имеют ряд ограничений. Во-первых, изображения слишком «идеальны»: они статичны, равномерно освещены и лишены искажений, в то время как на улицах лица часто скрыты масками, очками, подвергаются смазанности от движения или закрыты другими людьми. Даже попытка NIST добавить снимки с веб-камер не приблизила тесты к реальности — они всё равно остаются гораздо чище и проще, чем кадры уличного наблюдения.

Понравилась новость? У нас есть еще!

Подписывайся на канал — здесь всё самое интересное.

Вступить

Во-вторых, объём тестовых наборов, хоть и достигает миллионов снимков, не отражает сложностей, возникающих при масштабировании до уровня национальных баз данных или социальных сетей. Чем больше база поиска, тем чаще происходят ложные совпадения. В полицейских системах, работающих с сотнями миллионов профилей, вероятность ошибки увеличивается многократно, однако действующие стандарты этого не учитывают.

В-третьих, данные в наборах далеко не всегда представляют реальную демографию. Если система обучена на снимках людей со светлой кожей, она хуже справляется с распознаванием тёмнокожих, что и приводит к перекосам, наиболее ощутимым для меньшинств. В отчётах британской Национальной физической лаборатории, которые служат основанием для применения технологии в Лондоне, слабо представлены подростки, а дети младше 12 лет вовсе отсутствуют, хотя именно они нередко попадают под уличные проверки. Это делает официальные выводы неполными и ставит под сомнение легитимность использования системы против молодёжи.

Сегодня существует настоятельная необходимость перейти от лабораторных испытаний к независимым и масштабным проверкам в реальных условиях. Для этого нужны новые методики оценки, учитывающие качество работы в толпе, на больших выборках и в разных социальных группах. Также важно закрепить юридически обязательные критерии минимальной точности при использовании технологии в критических областях вроде полицейских расследований. Без доступа к реальным данным и прозрачного контроля решения о внедрении остаются основанными на цифрах, не имеющих отношения к действительности, и чреваты повторением случаев, подобных истории Уильямса и Томпсона.

Исследование, опубликованное в мае 2025 года криминологами и специалистами по компьютерным наукам из Пенсильванского университета, добавило новые аргументы к сомнениям в надёжности технологий распознавания лиц. Авторы работы показали, что при ухудшении качества изображений точность алгоритмов резко снижается. Особенно это проявляется при размытости кадров, изменённом ракурсе или низком разрешении. Более того, падение качества распознавания распределяется неравномерно: вероятность ложных совпадений и ошибок распознавания значительно выше у представителей расовых и гендерных меньшинств.

Учёные при этом отмечают, что в целом уровень точности систем распознавания лиц всё же выше, чем у некоторых традиционных криминалистических методов, включая дактилоскопию и баллистическую экспертизу. Но акцент в их выводах делается не столько на сравнении методов, сколько на том, что в условиях реального применения качество изображения становится критически важным фактором, способным превратить высокотехнологичный инструмент в источник дискриминации.

Проблемы выходят за рамки сугубо технических. В отчёте Счётной палаты США 2023 года говорилось, что многие американские правоохранительные структуры применяют распознавание лиц без должной подготовки сотрудников и без политик, учитывающих гражданские права. Последствия такого подхода наглядно отражены в исследовании Algorithmic Justice League «Comply To Fly?», где указывается, что Управление транспортной безопасности США использует системы распознавания лиц без полноценного информирования пассажиров. По данным отчёта, путешественники зачастую не знают, что могут отказаться от сканирования, а две трети тех, кто пытается это сделать, сталкиваются с враждебным отношением сотрудников TSA.

На фоне этих проблем Национальный институт стандартов и технологий США (NIST) опубликовал новые рекомендации по выявлению поддельных лиц, созданных методом морфинга — цифрового объединения черт нескольких людей в один портрет. Такой приём может использоваться для обхода систем аутентификации.

Отчёт, подготовленный в феврале 2024 года для организации Innocence Project исследовательницей Александрией Сэнфорд, напомнил, что уже есть подтверждённые случаи ошибочной идентификации. В 7 таких делах 6 касались темнокожих граждан. В 2025 году EFF дополнил список двумя лицами, ошибочно арестованных в США. Правозащитники заявляют, что независимо от уровня точности сама по себе практика полицейского применения распознавания лиц слишком опасна и должна быть запрещена.