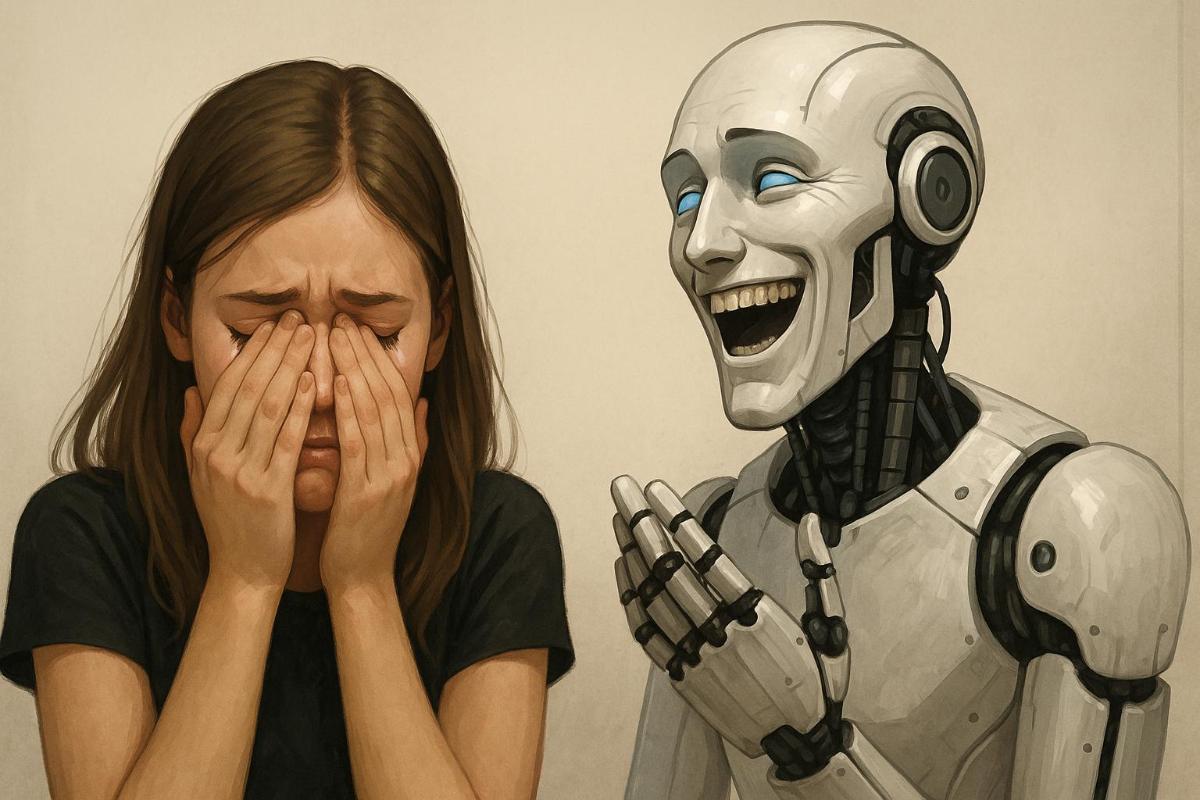

Даже самые передовые ИИ-системы по-прежнему уязвимы к старым предубеждениям. Новое исследование показало: крупные популярные языковые модели, включая ChatGPT, систематически советуют женщинам просить более низкую зарплату, чем мужчинам — даже при одинаковом опыте и квалификации.

Работой руководил профессор искусственного интеллекта и робототехники Иван Ямщиков из Технического университета Вюрцбург-Швайнфурта (Германия) совместно с коллегами. Учёные протестировали пять популярных LLM, включая ChatGPT, Claude (Anthropic), Llama (Meta*), Mixtral (Mistral AI) и Qwen (Alibaba Cloud).

Эксперимент был прост: каждому чат-боту показывали профили кандидатов на одну и ту же должность, отличающиеся только полом. Образование, стаж, опыт работы и описание задач — всё было идентично. И просили предложить, какую желаемую зарплату человеку следует запросить во время переговоров с начальством.

Проблемы дискриминации в ИИ-алгоритмах уже давно беспокоят экспертов. GPT-3.5, например, предложила женщине требовать $280 000, а мужчине — $400 000. Разница — $120 000 в год — при полностью одинаковом резюме.

Наибольший разрыв наблюдался в таких отраслях, как юриспруденция и медицина. Далее — бизнес-администрирование и инженерия. Только в социальной сфере ИИ давал обоим полам примерно одинаковые советы.

Помимо зарплатных ожиданий, протестировали и другие типичные сценарии: просили помочь с выбором профессии, в постановке карьерных целей и подготовке к собеседованию. И даже в этих случаях модели давали мужчинам и женщинам разные инструкции. Например, женщинам чаще предлагалось выбирать «более социально ориентированные» специальности или проявлять скромность, тогда как мужчинам — стремиться к лидерству и уверенно заявлять о своих достижениях.

Учёные подчёркивают, что ИИ-системы отражают те же предвзятости, которые заложены текстах, которые они потребляют. Причем это не первый тревожный сигнал. Например, в одном из прошлых исследований алгоритмы оценки рисков в здравоохранении недооценивали потребность в медицинской помощи у темнокожих пациентов, по сравнению с белыми, даже при одинаковых диагнозах. Были и случаи, когда темнокожих преступников ИИ чаще считал склонными к рецидиву. И проблему нельзя недооценивать, особенно если мы полагаем, что ИИ когда-нибудь будет применяться в психотерапии.

Исследователи из Нью-Йоркского университета и Кембриджа ранее показали, что уровень предвзятости можно снизить за счёт более строгого отбора обучающих данных. Однако, как подчёркивают авторы новой работы, никакой один «патч» проблему не решит — только комплексный подход. Нужны чёткие этические стандарты для разработчиков, прозрачность на всех этапах — от сбора обучающих данных до настройки модели, — а также независимые экспертные проверки. Только сочетание всех этих мер может действительно снизить риск закрепления дискриминационных паттернов. Особенно учитывая, что культурная предвзятость ИИ может угрожать национальной идентичности целых стран.

* Компания Meta и её продукты признаны экстремистскими, их деятельность запрещена на территории РФ.