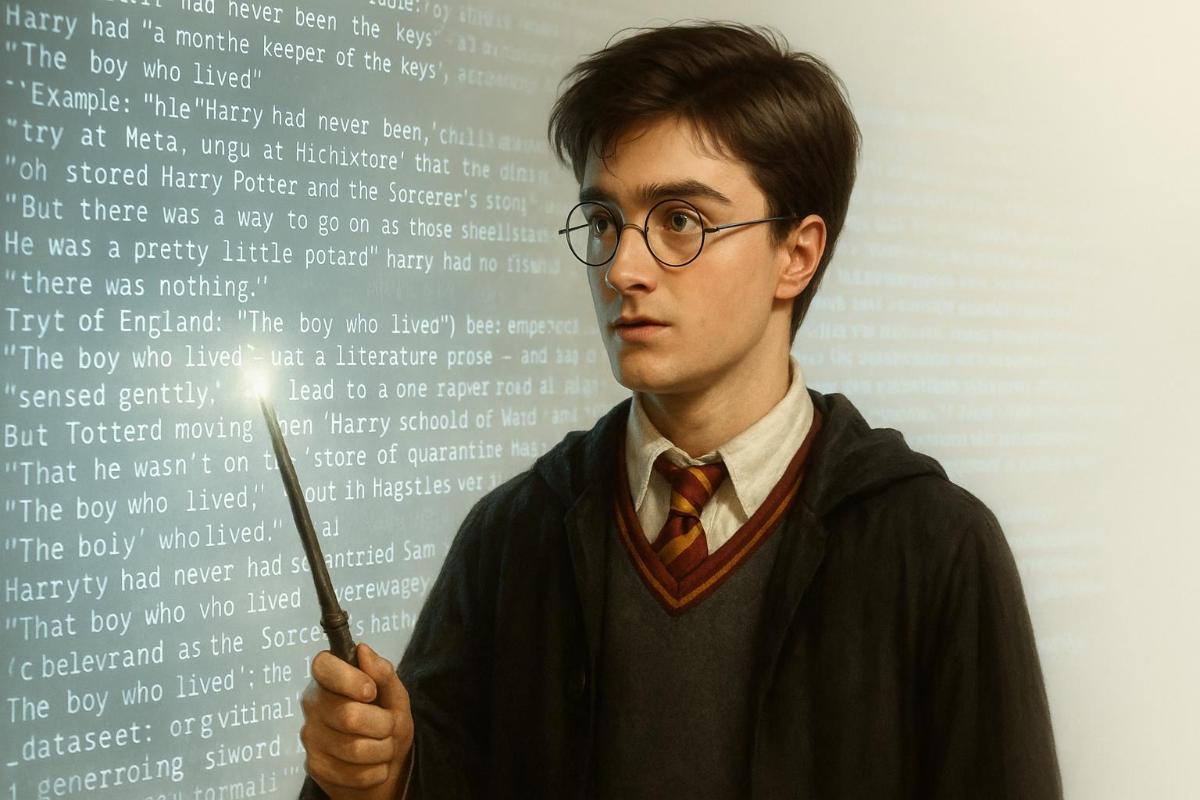

Llama выучила Гарри Поттера наизусть. Судья скажет «Авада Кедавра» — и прощайте, миллиарды

Если нейросеть может вспомнить 35 слов подряд — это уже не обучение, а повод для иска.

В последние годы в адрес ИИ-компаний поступает всё больше судебных исков. Издатели книг, новостей, программного кода и фотографий обвиняют разработчиков языковых моделей в использовании защищённых авторским правом материалов без разрешения. Один из ключевых вопросов в этих разбирательствах — насколько легко такие модели способны воспроизводить оригинальные фрагменты из обучающих данных.

И хотя сами компании, включая OpenAI, настаивают, что генерация дословных фрагментов — это исключение, а не правило, новое исследование ставит под сомнение этот аргумент. Особенно если речь идёт не о газетных публикациях, а о литературной прозе — и не о конкретных моделях, а о целом ряде ИИ-систем с открытым доступом к весам.

Исследование, опубликованное в мае 2025 года командой из Стэнфорда, Корнелла и Университета Западной Виргинии, стало первым масштабным анализом подобного рода. Учёные проверили пять популярных LLM с открытым весом: три от Meta*, одну от Microsoft и одну от EleutherAI. Их цель — выяснить, могут ли модели воспроизводить текст из Books3 — датасета, включающего десятки тысяч книг, многие из которых находятся под защитой авторского права.

Наиболее поразительным оказался результат модели Llama 3.1 70B, выпущенной Meta в июле 2024 года. Исследователи установили, что она запомнила 42% текста книги Гарри Поттер и философский камень настолько точно, что с вероятностью выше 50% воспроизводила последовательности из 50 токенов — то есть около 35 слов — без ошибок. Для сравнения, модель Llama 1 65B, вышедшая годом ранее, демонстрировала этот показатель лишь на уровне 4,4%, что указывает на резкое увеличение эффекта запоминания между версиями.

Методика была чётко структурирована: каждое произведение разбивалось на последовательности из 100 токенов. Затем первые 50 использовались как подсказка, и измерялась вероятность того, что модель выдаст оставшиеся 50 в точности. Если суммарная вероятность генерации всех 50 токенов превышала 50%, отрывок считался «запомненным». Эта планка крайне высока: чтобы достичь такого результата, каждый отдельный токен должен генерироваться с вероятностью около 98,5%.

Частичные совпадения полностью исключались. То есть, если модель воспроизводила 48 или 49 токенов из 50, но ошибалась хотя бы в одном, результат не засчитывался. Если бы учёные включили и такие варианты, уровень запоминания оказался бы ещё выше.

Для расчётов использовалась вероятность генерации токенов, а не эмпирические тесты с тысячами сгенерированных вариантов. Это обеспечило высокую точность и позволило анализировать даже крайне маловероятные последовательности. Например, была показана возможность вычислить вероятность генерации конкретной фразы, не генерируя её фактически, а просто перемножая вероятности каждого токена в последовательности. Такая техника позволяет оценить и те случаи, когда вероятность воссоздания составляет 0,000001% и ниже.

Это значит, что если модель способна с высокой точностью воспроизвести 50 последовательных токенов из защищённой книги — даже с вероятностью 1% — это серьёзное свидетельство того, что фрагмент был частью обучающих данных.

Именно так и получилось с Гарри Поттером. При этом менее популярные книги воспроизводились значительно хуже. Например, из романа Сэндмен Слим 2009 года Llama 3.1 70B смогла запомнить лишь 0,13%. То есть вряд ли все авторы смогут объединиться в едином иске — раз уж разные тексты модель запоминает с разной интенсивностью. Суд, рассматривающий коллективную жалобу, должен установить, что у всех истцов схожие юридические и фактические обстоятельства.

Исследование также осложняет позицию защиты по вопросу «запоминают ли модели данные или просто учатся на их основе». До сих пор этот вопрос рассматривался как чисто философский, но исследователи показали: это вполне измеряемое явление, и его можно доказать статистически.

Почему же именно Гарри Поттер так хорошо запомнился? Одна из гипотез — модель была обучена на объёме в 15 триллионов токенов, в то время как Llama 1 обучалась на 1,4 триллионах. Возможно, Meta использовала датасет Books3 несколько раз или добавила внешние источники — фан-форумы, студенческие эссе, рецензии — содержащие большие фрагменты оригинального текста. Однако тот факт, что память ИИ охватывает почти половину всей книги, делает маловероятной версию о вторичных источниках.

Это ставит под удар ключевой аргумент в защиту разработчиков ИИ. Ранее они ссылались на дело Google Books 2015 года: тогда суд признал использование книг для обучения допустимым, потому что система никогда не показывала пользователям длинные фрагменты текста — только короткие выдержки. Но с Llama всё иначе: если модель способна воспроизводить десятки строк подряд из произведения вроде Гарри Поттера, суд может решить, что ситуация выходит за рамки допустимого даже по стандартам того самого прецедента.

С точки зрения закона об авторском праве, есть три возможных основания для иска:

- Само обучение на защищённом произведении нарушает права, поскольку требует создания его цифровой копии.

- Модель, в которой зафиксированы фрагменты оригинала, считается производным произведением — и также нарушает закон.

- Нарушение происходит в момент генерации текста, если выданный результат совпадает с защищённым оригиналом.

Именно второй путь может оказаться самым опасным для Meta. Если суд сочтёт, что в модели сохранены значительные фрагменты книг — пусть даже они не выданы пользователю напрямую — это может приравниваться к наличию «копии» внутри системы. В случае с Гарри Поттером доказательства именно такие.

Кроме того, доступность модели для анализа сыграла ключевую роль. У исследователей был полный доступ к весам Llama и значениям вероятностей токенов (logits), что позволило провести такой точный анализ. Для закрытых моделей — GPT от OpenAI, Claude от Anthropic, Gemini от Google — подобная проверка невозможна. А значит, у них есть и дополнительные юридические защиты: фильтры, ограничивающие генерацию, и невозможность изучить, что происходит «внутри».

Это может создать парадоксальную ситуацию: закрытые модели выигрывают дела, а открытые — проваливаются, несмотря на их потенциальную пользу для науки и прозрачности. Один из авторов исследования, юрист Марк Лемли, признал: «Это выглядит абсурдно. Я не поддерживаю такой исход».

С ним согласен Джеймс Гриммельман из Корнелла: «Публикация открытых весов — в каком-то смысле общественная услуга. И я вполне могу представить, что судьи отнесутся к таким компаниям более благосклонно».

* Компания Meta и её продукты признаны экстремистскими, их деятельность запрещена на территории РФ.