Google очень, ОЧЕНЬ хочет, чтобы вы поверили в ее «приватный» ИИ. Компания запустила Private AI Compute

Компания делает трафик пользователей максимально анонимным и неотслеживаемым.

Google представила новую систему защиты данных Private AI Compute, предназначенную для обработки запросов искусственного интеллекта в облаке без риска раскрытия персональной информации. По словам компании, технология создаёт защищённую среду, в которой можно использовать возможности облачных моделей Gemini, сохраняя при этом конфиденциальность всех пользовательских данных.

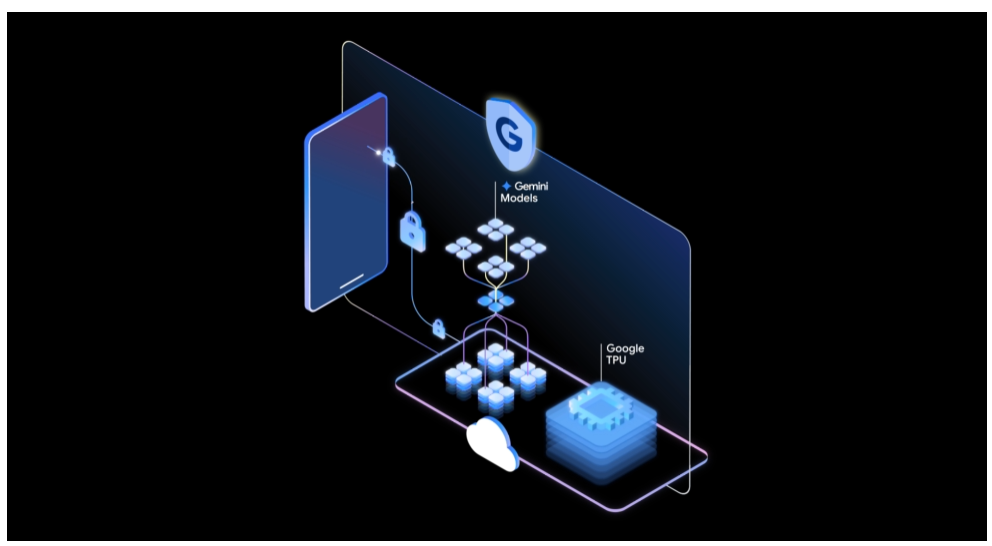

Private AI Compute описывается как изолированная, «укреплённая» вычислительная платформа, сочетающая преимущества облачной производительности с уровнем защиты, который обычно обеспечивается при локальной обработке на устройстве. В основе архитектуры лежат процессоры Trillium TPU и среды Titanium Intelligence Enclaves, объединяющие высокую вычислительную мощность с криптографическими гарантиями безопасности.

Для реализации этой концепции Google опирается на аппаратную инфраструктуру доверенных узлов, построенных на процессорах AMD и использующих аппаратный Trusted Execution Environment (TEE). Этот механизм обеспечивает шифрование оперативной памяти и её изоляцию от хостовой системы, исключая возможность доступа к выполняющимся задачам даже со стороны администраторов. Только проверенные и подтверждённые (attested) рабочие нагрузки допускаются к выполнению в доверенной среде, а попытки физического извлечения данных из оборудования блокируются на уровне архитектуры.

Важной особенностью Private AI Compute стала поддержка взаимной аттестации и сквозного шифрования между доверенными узлами. Это гарантирует, что информация пользователя расшифровывается и обрабатывается исключительно внутри доверенного контура, полностью изолированного от общей инфраструктуры Google. Каждый компонент проверяет подлинность другого с помощью криптографической валидации, а доступ к ключам выдаётся только после успешной проверки узла по внутренним эталонным значениям. В случае несовпадения параметров соединение не устанавливается, что предотвращает возможность передачи данных в недоверенные сегменты.

Процесс взаимодействия построен по многоуровневой схеме. Клиент инициирует защищённое соединение с фронтенд-сервером через протокол Noise и проводит взаимную аттестацию. Затем выполняется проверка подлинности сервера в рамках зашифрованной сессии Oak, что позволяет убедиться, что канал связи не был подменён.

После этого сервер создаёт зашифрованный канал ALTS для обмена данными с другими сервисами внутри масштабируемого конвейера инференса, а запросы к моделям обрабатываются на защищённых TPU-платформах. Вся система изначально спроектирована как временная — данные, запросы и вычисления уничтожаются сразу после завершения сессии. Даже если злоумышленник получит повышенные права доступа, он не сможет восстановить информацию прошлых сеансов.

Схема Private AI Compute (Google)

Чтобы предотвратить любые попытки несанкционированного вмешательства, Google встроила в инфраструктуру целый ряд защитных механизмов. Среди них — сокращение числа доверенных компонентов для обеспечения конфиденциальности; использование системы Confidential Federated Compute для сбора обезличенных статистических данных; полное шифрование клиент-серверных коммуникаций; бинарная авторизация, гарантирующая выполнение только подписанных и проверенных конфигураций; изоляция пользовательских данных в виртуальных машинах; защита памяти и каналов ввода-вывода средствами IOMMU от физического извлечения данных; полный запрет на доступ к оболочке (shell) в среде TPU; туннелирование всего входящего трафика через IP-ретрансляторы сторонних операторов для скрытия истинного источника запроса; а также раздельная система аутентификации и авторизации, использующая анонимные токены и не связанная с обработкой запросов ИИ.

Безопасность платформы была независимо проверена NCC Group, проводившей аудит Private AI Compute с апреля по сентябрь 2025 года. Специалисты обнаружили несколько потенциальных уязвимостей, включая тайминговый канал в модуле IP-ретрансляции, который при определённых условиях мог использоваться для деанонимизации пользователей. Однако Google оценила этот риск как низкий, отметив, что многопользовательская архитектура создаёт высокий уровень «шума», усложняющий корреляцию запросов с конкретными пользователями.

Также аудиторы выявили три проблемы в механизме аттестации, способные привести к отказу в обслуживании и протокольным ошибкам. В компании сообщили, что работают над мерами по устранению всех выявленных недочётов. Несмотря на использование проприетарных аппаратных компонентов и централизацию системы на Borg Prime, исследователи отметили высокий уровень защиты пользовательских данных от несанкционированной обработки и ограничение возможностей даже для потенциальных внутренних злоумышленников.

По своей сути Private AI Compute следует той же логике, что и аналогичные инициативы других крупных игроков. Apple ранее внедрила Private Cloud Compute, а Meta* — механизм Private Processing, которые также позволяют передавать запросы искусственного интеллекта в облако без компромиссов для конфиденциальности. В Google подчёркивают, что их решение объединяет вычислительные возможности облака с гарантиями аппаратного шифрования и прозрачной аттестации. Пользовательские устройства соединяются с защищённой средой с помощью удалённой криптографической проверки и зашифрованных каналов, а модели Gemini обрабатывают данные внутри изолированного сегмента, к которому не имеет доступа ни сама компания, ни сторонние участники.

Таким образом, новая архитектура создаёт технологическую основу для безопасных облачных вычислений следующего поколения, где мощность центров обработки данных совмещается с принципами локальной приватности, а контроль над данными остаётся исключительно у владельца.

* Компания Meta и её продукты (включая Instagram, Facebook, Threads) признаны экстремистскими, их деятельность запрещена на территории РФ.