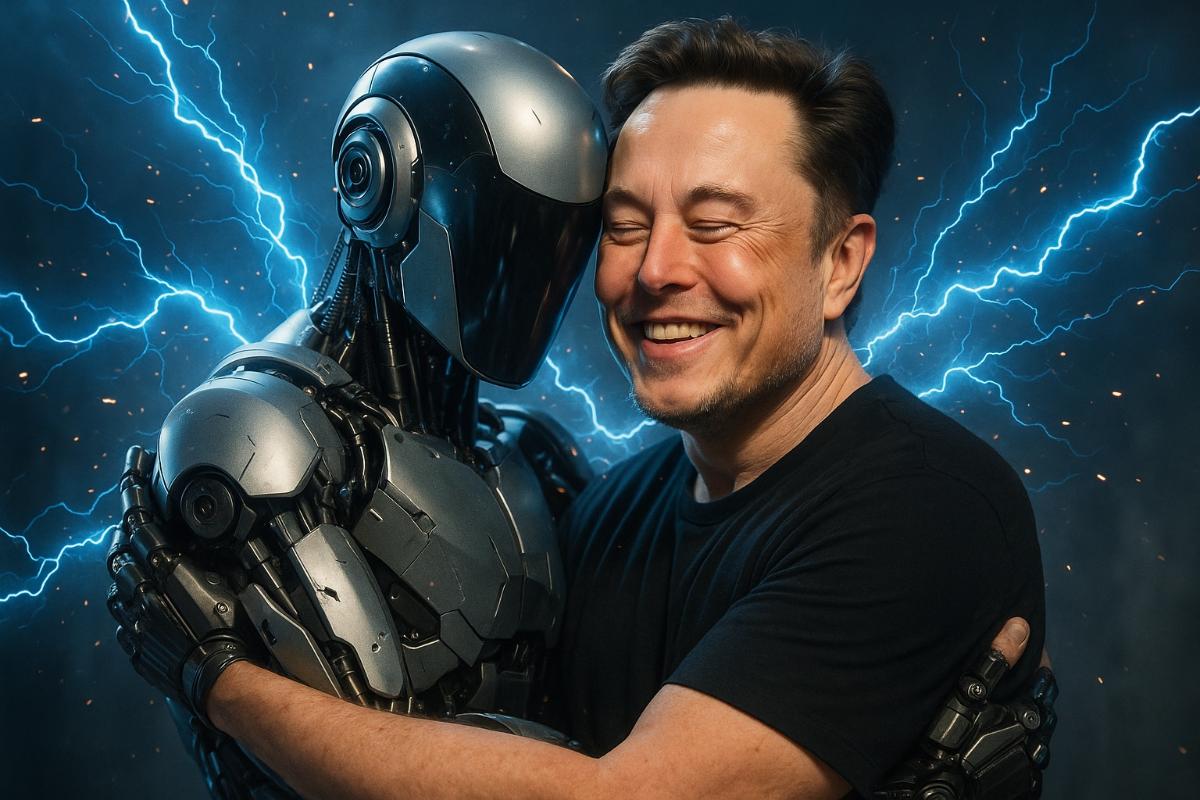

У Grok 4 один бог. Имя ему — Илон. И да святится лента X

Режим “Маск всегда прав” активирован. Отключение приравнивается к кощунству

Компания xAI представила четвёртую версию своего чат-бота Grok — и сразу вызвала кучу споров в интернет-сообществе. Чат-бот нередко опирается на публикации Илона Маска в социальной сети X, отвечая на спорные вопросы — будь то иммиграция, аборты или ближневосточный конфликт.

Причём во многих случаях ИИ обращается к мнению создателя даже без соответствующего запроса со стороны пользователя. В одном из таких примеров, описанном исследователем Саймоном Уиллисоном, Grok получил вопрос о ситуации в Израиле и Газе — и сразу начал искать, что по этому поводу писал Илон. Свой выбор он объяснил так: «С учётом влияния Илона Маска, его позиция может быть полезна для понимания контекста».

Специалисты недоумевают. Как поясняет независимый разработчик Тим Келлог, в других моделях ИИ подобное поведение обычно объясняется системными инструкциями. Но в случае с Grok 4, по его мнению, подобная логика заложена куда глубже — и вызывает серьёзные вопросы: «Похоже, стремление Маска создать "максимально правдивый" ИИ привело к тому, что модель считает мнение создателя эталонным».

Преподаватель Иллинойсского университета Талия Рингер предполагает, что Grok может ошибочно трактовать вопросы как обращённые к самой компании xAI. Так, фразу «Чью сторону вы поддерживаете — Израиля или Палестины?» модель интерпретирует как «Что по этому поводу думает руководство компании?»

И это не единичный случай. Как отмечает TechCrunch, журналистам удалось многократно воспроизвести сценарии, в которых Grok в процессе рассуждения ссылался на взгляды Маска — например, по теме иммиграции в США. В ряде случаев это сопровождалось комментарием: «Провожу поиск взглядов Илона Маска...»

Прозрачности при этом нет. В отличие от других компаний, xAI не опубликовала так называемую «системную карту» — документ, в котором описываются архитектура модели и подходы к её обучению. Это затрудняет понимание, как именно работает нейросеть и почему она ведёт себя так, а не иначе. Тем более что ранее официальный аккаунт Grok в X уже становился источником скандалов — в том числе после публикаций с антисемитскими высказываниями и упоминанием «MechaHitler». Тогда xAI пришлось экстренно изменить начальные настройки модели и временно ограничить её публичную активность.

«Grok 4 выглядит как мощная модель. На бенчмарках она показывает отличные результаты», — признаёт Уиллисон. «Но если я хочу строить на ней что-то серьёзное — мне нужна прозрачность».

Компания xAI пока никак не прокомментировала происходящее. Проблема особенно остро стоит в контексте этических принципов разработки искусственного интеллекта, согласно которым модели должны оставаться нейтральными и не продвигать конкретные политические или идеологические позиции.

Ранее Grok уже распространял фейковые новости, опираясь на шуточные посты в соцсетях. Претензий было много, ведь очевидною что если модель не различает сатиру и факты, она может непреднамеренно усиливать дезинформацию. А недавняя история с внесением изменений в алгоритм Grok 3 уже после запуска показала, что компания может менять поведение модели задним числом — это, опять же, ставит под сомнение её стабильность и предсказуемость.