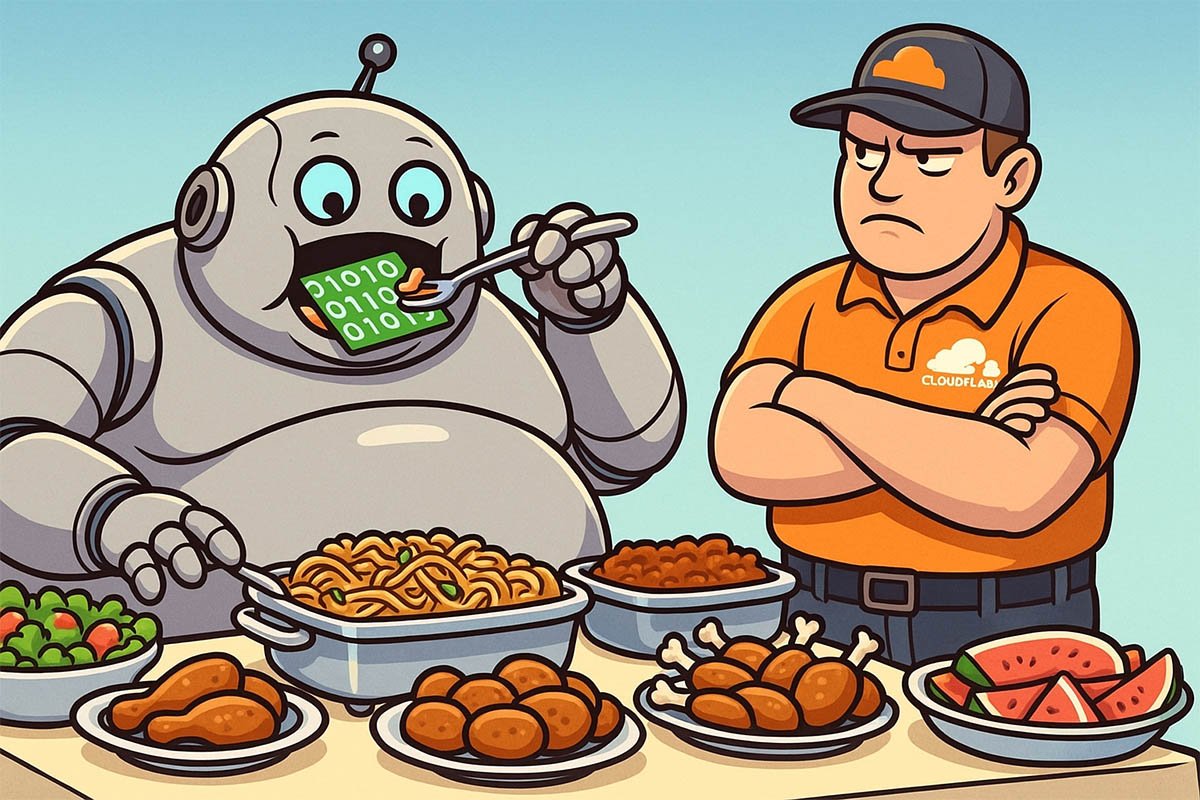

Контент — не шведский стол для ИИ: Cloudflare учит сайты брать деньги за знания

Обходить ограничения скоро станет дороже, чем подчиняться правилам.

Американская компания Cloudflare запустила новый инструмент, который помогает владельцам сайтов контролировать доступ к их контенту со стороны ботов, собирающих данные для обучения нейросетей. Такой шаг должен помочь авторам и издателям получать компенсацию за использование их материалов и защитить свои ресурсы от несанкционированного сбора данных.

Принцип работы нового решения позволяет администраторам сайтов самостоятельно решать, смогут ли боты, связанные с разработкой искусственного интеллекта, получать доступ к их материалам. Кроме того, предусмотрена возможность установить плату за такой доступ по модели «оплата за каждый запрос». По мнению представителей Cloudflare, это даст создателям контента больше контроля над использованием их работы и позволит получать дополнительный доход.

Актуальность этого вопроса возросла на фоне того, что всё больше ИИ-компаний используют чужие сайты как источник данных для обучения своих моделей, не направляя пользователей обратно к оригинальным источникам. Это приводит к снижению посещаемости сайтов и, как следствие, падению доходов от рекламы.

Инициативу Cloudflare уже поддержали крупные медиа-компании, включая Condé Nast и Associated Press, а также популярные социальные платформы Reddit и Pinterest. В компании отмечают, что новая мера станет частью более масштабного процесса создания справедливой цифровой среды, в которой учтены интересы как авторов контента, так и разработчиков ИИ.

По словам Стефани Коэн, занимающей должность директора по стратегии в Cloudflare, в последнее время изменения в структуре интернет-трафика происходят слишком быстро и резко, что требует срочного реагирования. Она отметила, что представленный инструмент — только первый шаг к новому подходу к использованию интернет-ресурсов.

Статистика Cloudflare показывает, насколько ситуация изменилась за последние месяцы. Так, соотношение числа обходов сайтов поисковыми ботами Google к количеству реальных переходов на сайты снизилось с шести к одному до восемнадцати к одному. Это говорит о том, что Google продолжает активно сканировать сайты, но всё реже приводит на них посетителей. При этом у других компаний, занимающихся разработкой ИИ, показатели ещё более разительные. Например, у OpenAI это соотношение составляет 1500 к одному.

Исторически поисковые системы индексировали сайты, направляя пользователей к оригинальным источникам информации, что стимулировало авторов создавать качественный контент. Однако появление чат-ботов, таких как ChatGPT, изменило эту схему. Теперь искусственный интеллект агрегирует информацию и отвечает на запросы пользователей, часто не предоставляя ссылок на первоисточники, из-за чего авторы теряют потенциальный доход и признание.

Ситуация усугубляется тем, что многие ИИ-компании намеренно обходят стандартные технические запреты, которые сайты устанавливают для защиты от несанкционированного сбора данных. При этом они утверждают, что не нарушают законы, получая доступ к информации.

Некоторые медиакомпании уже начали активно защищать свои интересы в суде. Например, The New York Times не так давно подала иск о нарушении авторских прав против разработчиков ИИ. Другие предпочитают заключать официальные соглашения о лицензировании контента. Так, Reddit подал судебный иск против Anthropic, обвиняя компанию в незаконном использовании пользовательских данных для обучения чат-бота, одновременно подписав лицензионное соглашение с Google.

Эти события отражают новый виток борьбы за справедливое использование контента в эпоху искусственного интеллекта и поднимают вопрос о необходимости законодательного регулирования этой сферы.