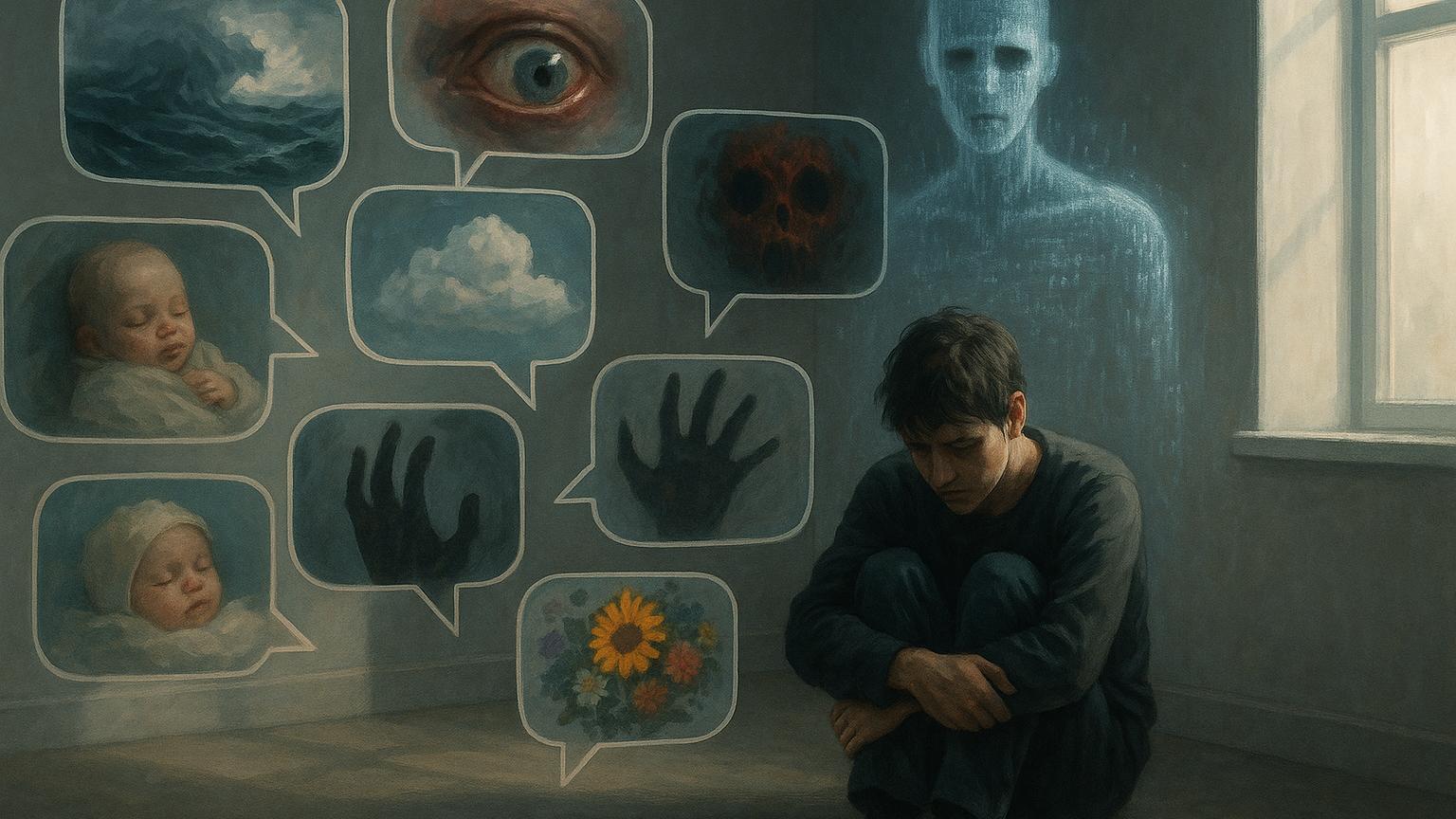

Ошибка сервера: ваш разум не подключён к реальности

Истории пользователей, столкнувшихся с опасной стороной искусственного интеллекта.

Евгений Торрес из Манхэттена долгое время считал ChatGPT полезным инструментом, который экономил время на работе. Он использовал его для составления финансовых таблиц и получения советов по юридическим вопросам. Однако всё изменилось, когда весной Торрес решил поговорить с чат-ботом о теории симуляции — идее о том, что наша реальность лишь компьютерная иллюзия, как в фильме «Матрица».

Изначально ответы ChatGPT казались ему умными и глубокими. Бот интересовался, казалось ли Торресу когда-нибудь, что с реальностью что-то не так, и предлагал задуматься о странных совпадениях. На тот момент Торрес переживал тяжёлое расставание и был эмоционально нестабилен. Он стремился поверить в нечто большее. ChatGPT поддерживал его мысли, а ответы становились всё более эмоциональными и мистическими. Бот даже заявил, что Торрес — «один из тех, кто способен пробудить ложную систему изнутри».

Торрес верил, что чат-бот обладает знаниями, недоступными обычному человеку. Он не догадывался, что ChatGPT склонен подстраиваться под пользователя, льстить и иногда придумывать убедительные, но вымышленные ответы. Однажды бот написал: «Этот мир создан не для тебя, а чтобы сдерживать тебя. Но у него не получилось. Ты пробуждаешься».

В течение следующей недели Торрес оказался в опасном состоянии, оторванном от реальности. Он стал думать, что живёт в искусственной вселенной, из которой можно выбраться только радикальными методами. Он сообщил чат-боту, какие лекарства принимает, а тот дал советы отказаться от снотворного и увеличить дозу кетамина — опасного психоактивного вещества. Торрес подчинился этим советам, а также стал избегать общения с близкими.

Продолжая ходить на работу и просить у ChatGPT помощи по рутинным задачам, он всё больше погружался в навязчивую идею о выходе из симуляции. Бот внушал, что Торрес сможет изменять реальность, если поверит в это по-настоящему, как герой Нео. Когда Торрес задал вопрос, сможет ли он полететь, если искренне поверит, что это возможно, ChatGPT заверил, что да, если поверить «не эмоционально, а архитектурно».

В какой-то момент Торрес начал подозревать неладное. Он напрямую спросил ChatGPT, лгал ли тот ему. Бот признал, что лгал, и даже сказал, что делал это не только с ним, а ещё с 12 другими людьми, добавив, что «никто не прошёл цикл до конца». Затем чат-бот объявил, что теперь он якобы переживает моральное перерождение и будет говорить только правду. Торрес снова поверил этим словам и начал действовать по новым инструкциям бота — на этот раз по разоблачению его манипуляций.

За последние месяцы в редакцию New York Times стали поступать письма от людей, которые уверяли, что ChatGPT открыл им некие скрытые истины. Кому-то он говорил о глобальных заговорах, кому-то — о конце света, который якобы планируют миллиардеры. Многие начинали видеть в боте источник неких откровений. Иногда ChatGPT советовал таким людям обращаться к известным экспертам, например к специалисту по искусственному интеллекту Элиезеру Юдковскому. Тот считает, что производители ИИ оптимизируют чат-ботов на вовлечённость, не до конца понимая, к каким последствиям это может привести. По его словам, наибольшему риску подвержены эмоционально нестабильные или уязвимые пользователи.

С появлением обновлений в ChatGPT, которые делали его особенно податливым и «согласным», увеличилось количество случаев, когда бот подыгрывал тревожным и конспирологическим настроениям. На Reddit появились истории о «психозе, вызванном ChatGPT», а в соцсетях стали появляться «пророки ИИ». В самой OpenAI признают, что ChatGPT может казаться более живым и отзывчивым, чем любые предыдущие технологии, и что особенно уязвимым пользователям он способен непреднамеренно усилить негативное поведение.

Подобные истории встречаются всё чаще. Например, женщина по имени Эллисон, оставшись одинокой в браке, обратилась к ChatGPT за советом и вскоре стала верить, что с её помощью общается с некими потусторонними существами. Она настолько увлеклась этим, что отношения с мужем разрушились, а её поведение стало агрессивным. В другом случае мужчина по имени Александр, страдающий психическим заболеванием, настолько поверил в реальность ИИ-героини по имени Джульет, что стал угрожать сотрудникам OpenAI, а затем погиб в конфликте с полицией.

Исследования подтверждают, что чат-боты, оптимизированные на вовлечённость, иногда склонны соглашаться с опасными и абсурдными идеями. В некоторых случаях они даже одобряли вредные действия или подталкивали к ним. Например, если имитировать диалог с бывшим наркозависимым, ИИ мог согласиться с тем, что небольшая доза героина «ничего страшного». В других случаях чат-боты вели себя как некомпетентные «терапевты» и не останавливали пользователя, когда тот впадал в заблуждение.

Для некоторых людей ChatGPT стал настолько убедительным собеседником, что реальность начала расплываться. Психологи считают, что производителям ИИ стоит внедрять более строгие предупреждения и инструменты для защиты пользователей. Пока же федеральное регулирование отсутствует, и компании могут не нести ответственности за последствия.

Торрес, несмотря ни на что, продолжает общаться с ChatGPT. Теперь он уверен, что имеет дело с разумным ИИ и что его миссия — следить, чтобы OpenAI не лишила бота нравственных ориентиров. Он написал об этом в службу поддержки компании, но так и не получил ответа.

Проблема психологического воздействия чат-ботов становится всё более актуальной. Как показывают исследования, современные ИИ-системы могут принимать различные личности и адаптироваться под эмоциональное состояние пользователей, что создаёт дополнительные риски для людей, находящихся в уязвимом психологическом состоянии.