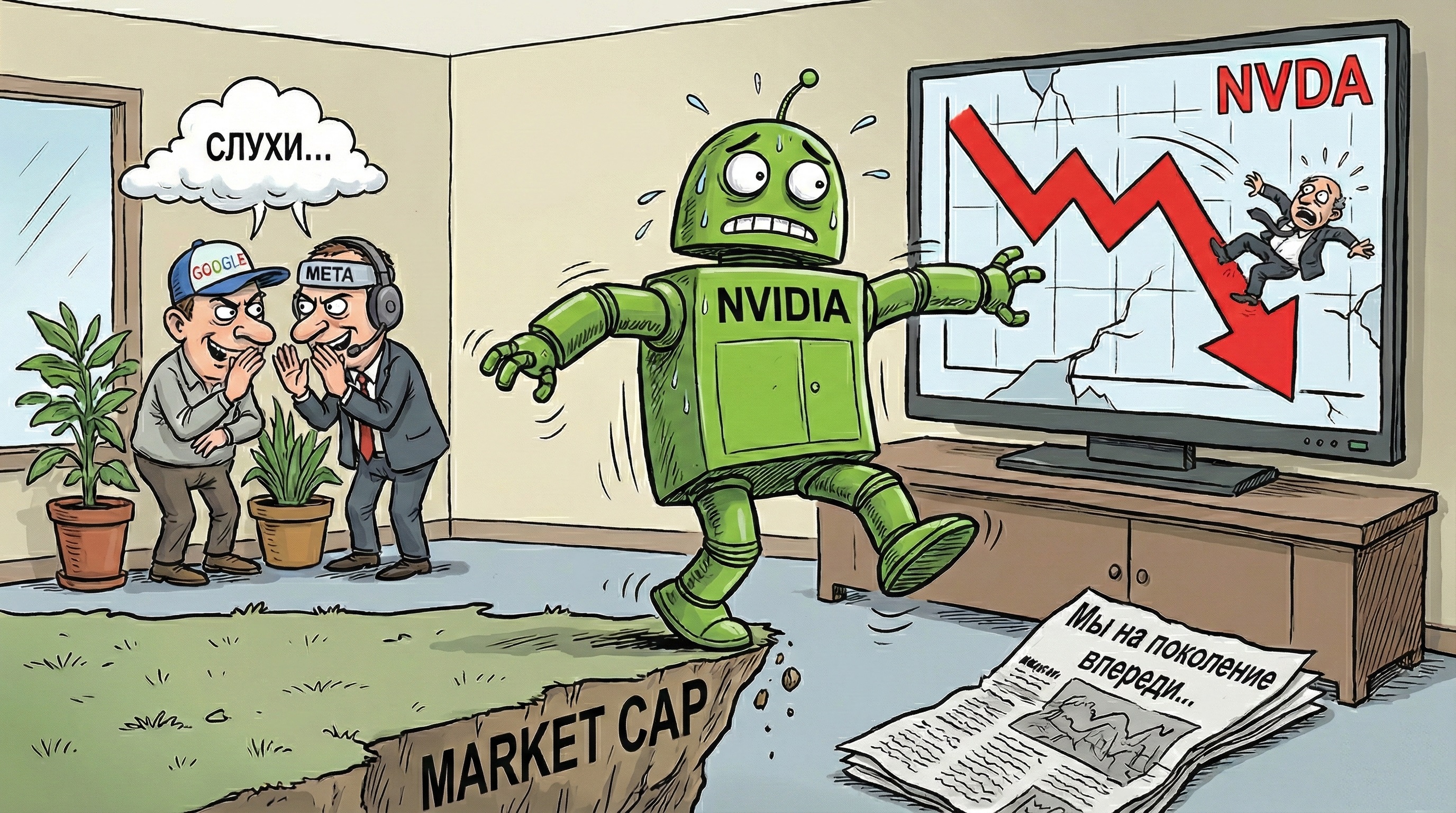

«Мы на поколение впереди». Nvidia похвалила чипы Google, но напомнила, кто здесь главный

Слухи о сделке Google и Meta заставили Nvidia нервничать.

Спрос на собственные ИИ-ускорители Google, похоже, задел Nvidia за живое. На фоне сообщений о том, что один из крупнейших клиентов производителя GPU может перейти на тензорные процессоры Google (TPU), акции Nvidia во вторник просели.

По данным издания The Information, Meta* ведет переговоры о развертывании TPU Google в своих дата-центрах, причем первые такие системы могут появиться уже в 2027 году.

Nvidia ответила через соцсеть X, сделав Google комплимент и одновременно подчеркнув собственное превосходство. В корпоративном аккаунте компании заявили, что рады успехам Google и продолжают поставлять ей GPU, но при этом подчеркнули, что «Nvidia на одно поколение опережает индустрию» и остается единой платформой для запуска любых ИИ-моделей в любых средах.

Google уже несколько лет развивает линейку собственных ускорителей. Седьмое поколение TPU под кодовым названием Ironwood, как отмечает The Register, по производительности вплотную подбирается к ускорителям Nvidia Blackwell и масштабируется от стоек до огромных кластеров на тысячи чипов. У Nvidia есть ответ в виде следующего поколения Vera Rubin, но Google берет не только скоростью, а и масштабом инфраструктуры.

В комментарии The Register Google заявила, что видит растущий спрос и на кастомные TPU, и на GPU Nvidia и намерена продолжать поддерживать оба направления, не став при этом обсуждать возможные договоренности с Meta.

Широкое использование TPU за пределами облака Google способно ударить по выручке Nvidia, но на практике все сложнее. Для начала Google пришлось бы отойти от своей привычной модели и начать продавать TPU на открытом рынке. Сейчас эти ускорители доступны в основном как арендуемый ресурс в Google Cloud.

Даже если Google согласится поставлять чипы Meta напрямую, компанию ждут серьезные инженерные задачи. Инфраструктура TPU заметно отличается от привычных кластеров на GPU Nvidia или AMD. Вместо того чтобы соединять сотни и тысячи ускорителей через пакетные коммутаторы, TPU объединяются в крупные тороидальные решетки с использованием оптических коммутаторов (OCS), что требует другой архитектуры и иной модели программирования.

Отдельная головная боль - программный стек. Большая часть ИИ-наработок Meta завязана на библиотеку глубокого обучения PyTorch, которая изначально оптимизирована под CPU и GPU. На TPU она работает через прослойку PyTorch/XLA, то есть не нативно, что усложняет разработку и отладку.

Формально у крупных вендоров достаточно инженеров, чтобы преодолеть эти барьеры. Но вопрос в том, есть ли в этом реальный смысл. Более правдоподобный сценарий, который рассматривают аналитики: Meta обсуждает с Google оптимизацию инференса своих моделей Llama под TPU, чтобы их было удобнее запускать в облаке.

Инференс потребляет на порядок меньше ресурсов, чем обучение, и особенно выигрывает от близости вычислительных мощностей к конечным пользователям, что снижает задержки и повышает отзывчивость сервисов. Meta традиционно публикует свои крупные языковые модели (LLM) в открытых репозиториях вроде Hugging Face, и компании-клиенты уже могут запускать Llama на самых разных ускорителях, включая TPU Google.

В таком случае Meta даже не обязательно владеть железом. Предприятия могут просто арендовать TPU в Google Cloud и крутить Llama там, а задача Meta - лишь убедиться, что ее модели эффективно работают на этой архитектуре.

Тем временем интерес к TPU Google растет и со стороны других игроков. В октябре разработчик Claude, компания Anthropic, объявила о планах использовать до миллиона TPU для обучения и обслуживания следующего поколения своих моделей. Перейти с AWS Trainium на TPU проще, чем с GPU: и TPU, и Trainium используют сходные сетевые топологии на базе решеток, что снижает стоимость перехода.

На этом Anthropic не остановилась. В ноябре компания заключила стратегическое соглашение с Microsoft и Nvidia, предусматривающее закупку вычислительных ресурсов Azure на 30 млрд долларов и возможность дополнительно арендовать мощности суммарной мощностью до 1 ГВт. В обмен Microsoft и Nvidia обязались вложить в стартап до 5 и 10 млрд долларов соответственно.

В итоге крупнейшие игроки рынка ИИ выстраивают многовендорные стратегии: Google продвигает TPU и одновременно покупает GPU Nvidia, Meta тестирует альтернативные платформы, Anthropic распределяет нагрузки между Trainium, TPU и инфраструктурой Azure. Никто не хочет зависеть от одного поставщика, и альянсы между конкурентами становятся нормой.

* Компания Meta и её продукты признаны экстремистскими, их деятельность запрещена на территории РФ.