Злость и плохой Wi-Fi. Почему инженеры без помощи нейросети проиграли соревнование по настройке робота

Эксперимент показал, что Claude видит короткие пути там, где инженеры блуждают вслепую.

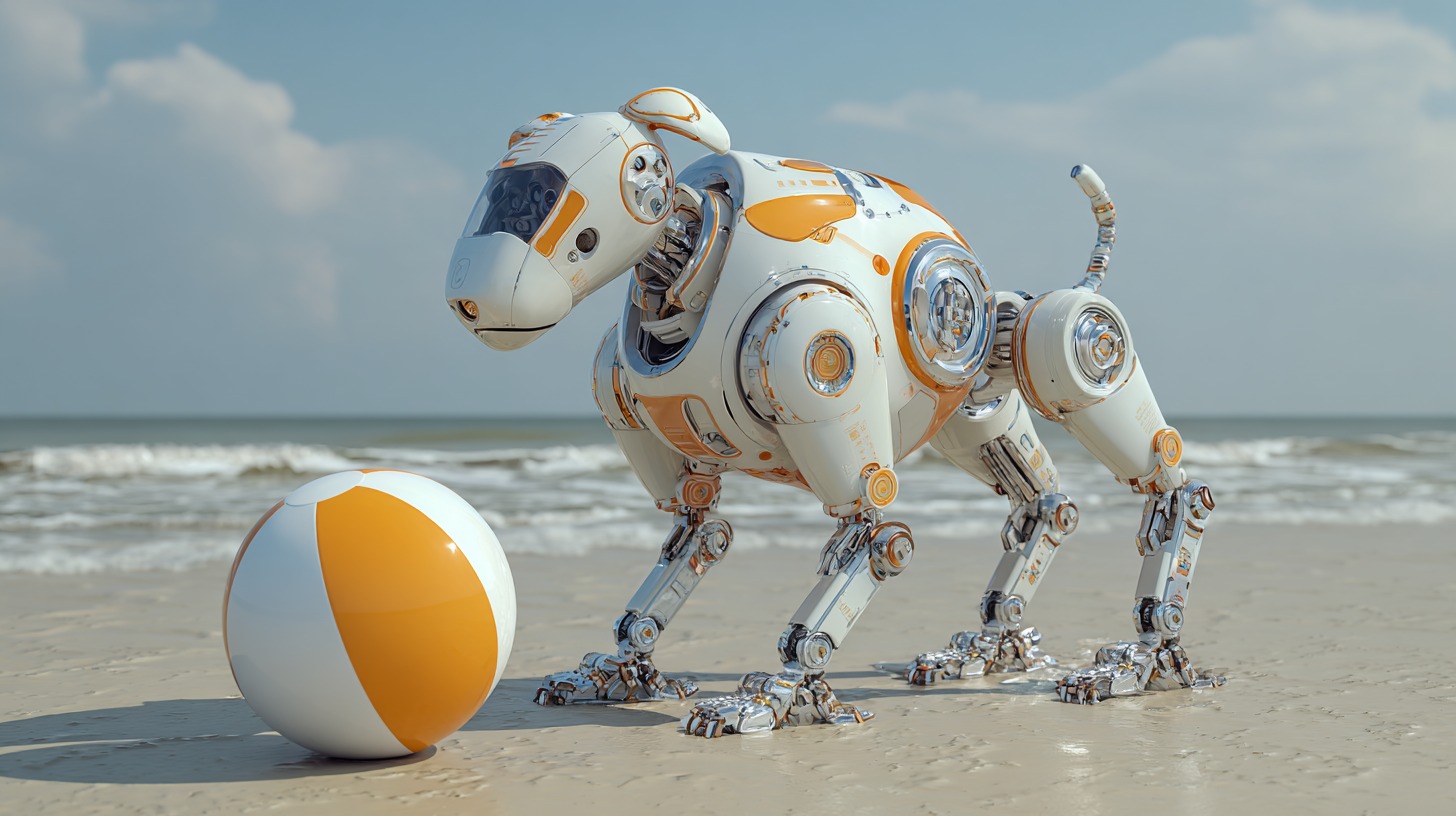

Anthropic провела внутреннее испытание, пытаясь понять, как её модель Claude влияет на работу людей, которые сталкиваются с реальными задачами в робототехнике. Для однодневного эксперимента компания собрала двух одинаковых по компетенциям команд из инженеров-программистов и предложила им справиться с одной и той же задачей: заставить четырёхногого робопса принести пляжный мяч. Участники проходили через серию шагов, которые становились сложнее — от подключения устройства до обработки данных датчиков и настройки ручного управления. Разница заключалась в том, что одна группа могла пользоваться Claude, а другая нет. Так родился эксперимент с символичным названием Project Fetch.

Результат показал ощутимый разрыв в темпе работы. Команда, которая имела доступ к ИИ, завершила семь из восьми заданий, тогда как второй группе удалось выполнить шесть. Наибольшие трудности возникли там, где приходилось разбираться с аппаратным уровнем. Подключение робота и получение данных сенсоров требовали сравнения противоречивых инструкций, пробных подключений и постоянных уточнений. Claude позволял быстро понять, какие действия дадут результат, предлагал варианты обхода проблем и помогал сохранять поступательную динамику. Команда без ИИ рано отказалась от самого простого пути из-за неверной интерпретации инструкции и оставалась в тупике до вмешательства организаторов.

Схожий сценарий повторился при попытке получить данные лидара. Группа с Claude продвигалась стабильнее, а участники без ИИ большую часть дня пытались разобраться в процессе и вышли на рабочий вариант только к завершению испытания.

Отдельное внимание привлёк объём написанного кода. Команда с ИИ создала его примерно в девять раз больше. Участники активно проверяли идеи, перепробовали несколько тактик и опирались на подсказки модели, что позволяло им расширять круг возможных решений. Такой подход создавал и дополнительную нагрузку: из-за избытка направлений иногда приходилось отказываться от неудачных веток разработки. Показательно, что в некоторых местах команда без ИИ двигалась быстрее. После того как они стабилизировали видеопоток, им удалось оперативно собрать рабочий контроллер и систему локализации. Однако итоговая версия управления, созданная при поддержке Claude, оказалась удобнее — она обеспечивала непрерывный видеопоток, а не набор задерживающихся кадров.

Anthropic также изучила эмоциональную динамику команд с помощью анализа их диалогов. Те, кто работал без ИИ, заметно чаще высказывали раздражение и неуверенность. Они ушли на обед, так и не обеспечив устойчивого соединения с роботом, что сказалось на настроении. Дополнительное напряжение создал эпизод, когда робот соперников случайно поехал в сторону их стола.

Несмотря на небольшие масштабы, испытание стало для Anthropic точкой отсчёта в понимании того, как ИИ может менять взаимодействие людей с физическими системами. Компания рассматривает Project Fetch как ранний сигнал о возможностях, которые будут появляться по мере роста автономности таких моделей. Этот эксперимент вписан в политику Responsible Scaling Policy, где фиксируются моменты, когда ИИ начинает вносить прямой вклад в реальную работу или исследования.