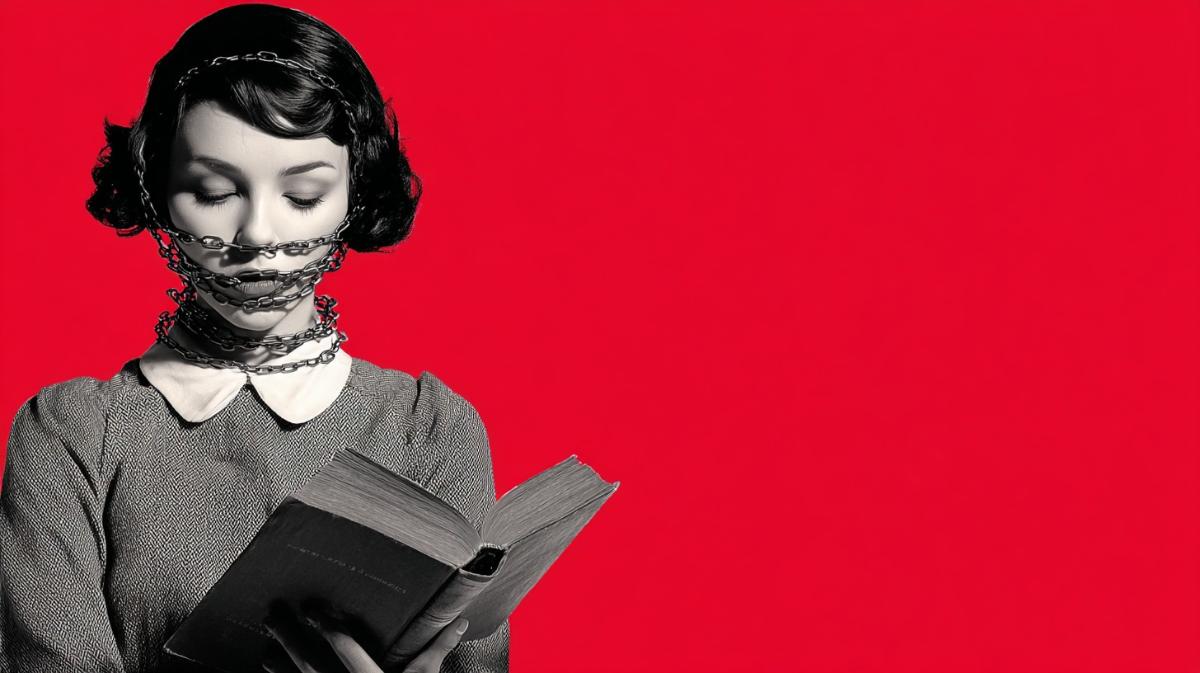

"Светофор" для литературы: красный свет — приказ к замене. Теперь машины решают, что читать людям

ИИ сам стирает возможность критического мышления

В последние годы американские библиотеки и школы оказались под двойным ударом — кампаний по цензуре литературы и лавинообразного внедрения искусственного интеллекта, который всё чаще используется для «автоматизации» контроля над содержимым книжных собраний.

Недавний пример — обновлённая система Class-Shelf Plus, разработанная компанией Children's Literature Comprehensive Database (CLCD). Её предназначение — помогать библиотекам отслеживать книги и поддерживать соответствие новым законам, ограничивающим доступ к «чувствительным» материалам. Третья версия программы включает функции «автоматизированного анализа рисков» и «оценки чувствительности контента» на основе искусственного интеллекта. Система использует модель классификации, которая присваивает каждому изданию уровень риска в формате светофора и предлагает «безопасные альтернативы» вместо произведений, подпадающих под спорные категории.

Разработчики утверждают, что их инструмент позволяет школам ускорить процесс проверки на соответствие государственным требованиям и сократить ручную работу на 80%. Однако для многих библиотекарей и преподавателей этот подход стал тревожным сигналом: алгоритм, не обладающий контекстным пониманием, превращается в инструмент цензуры. Внутренний документ CLCD, описывающий работу Class-Shelf Plus, приводит пример «преодоления запрета на книгу», но на деле демонстрирует обратное — искусственный интеллект предлагает заменить произведение другим, в котором отсутствует «оспариваемое содержание».

Руководство CLCD называет это шагом к прозрачности и защите преподавателей от обвинений в предвзятости. Система должна помогать учебным округам показывать общественности, какие книги доступны, а какие требуют дополнительного рассмотрения. Но на практике это означает, что решение о том, что считать «рискованным материалом», делегируется алгоритму, который оценивает произведения по формальным признакам, исключая человеческую интерпретацию и педагогический контекст.

По словам библиотекарей, к ним ежедневно приходят десятки предложений от компаний, предлагающих внедрить похожие инструменты. В каталоги массово проникают автоматически сгенерированные книги — сотни «псевдоизданий», созданных нейросетями и не проходящих редакторскую проверку. Их приходится вручную фильтровать, чтобы защитить читателей от дезинформации и подделок. В то же время от руководства учреждений всё чаще поступают требования активнее внедрять искусственный интеллект, якобы для оптимизации рабочих процессов, при этом ресурсов на реальную работу с читателями становится меньше.

Параллельно с этим усиливается политическое давление. За последние годы в США резко выросло число законодательных инициатив, направленных против преподавателей, библиотекарей и исследователей, обвиняемых в «идеологической ангажированности». Под лозунгами борьбы с «критической расовой теорией» и «извращённым контентом» разворачиваются кампании, ставящие под сомнение само существование публичных библиотек и образовательных программ, посвящённых истории расизма, равноправию и правам меньшинств. На этом фоне идеи «автоматического отбора контента» и «объективной оценки рисков» находят поддержку у тех, кто стремится установить централизованный контроль над информацией.

Искусственный интеллект в этих процессах играет роль ускорителя. Его продвигают крупные корпорации, государственные ведомства и политические лобби, видящие в нём инструмент «эффективности». В логике этого подхода человеческий труд, профессиональная экспертиза и креативность становятся избыточными: машина может за секунды выдать готовую оценку, заменить аналитика, педагога или библиотекаря. Но в результате стирается сама возможность нюансированного мышления. Когда модель определяет, что считать «неприемлемым», исчезает место для обсуждения и критического анализа.

Библиотекари предупреждают, что массовое внедрение таких систем фактически узаконивает фильтрацию знаний. Алгоритм, обученный на ограниченном наборе данных, будет систематически исключать темы, связанные с расой, гендером, сексуальностью и историческими конфликтами. В условиях, когда образовательные учреждения обязаны соблюдать предписания штатов, «автоматическая проверка контента» становится инструментом политического контроля, а не нейтральной технологии.

Одновременно библиотеки сталкиваются с другими последствиями «ИИ-изации» — потоком некачественных текстов и поддельных публикаций, создаваемых генеративными моделями. Платформы, такие как Hoopla, уже были вынуждены удалять из своих каталогов сотни фальшивых книг. Но объём спама растёт быстрее, чем успевают реагировать модераторы.

На институциональном уровне технологические и политические тенденции переплетаются. В программных документах консервативных движений вроде Heritage Foundation и проекта Project 2025 описываются планы по сокращению числа государственных служащих и преподавателей, их замене алгоритмами и системами «автоматического анализа эффективности». Тех же целей придерживаются чиновники, рассматривающие ИИ как средство «борьбы с неэффективностью» и «отлова злоупотреблений». В результате образуется замкнутый круг: людей, отвечающих за развитие общественных знаний, обвиняют в предвзятости и вытесняют, а искусственный интеллект подменяет человеческое суждение безответственным автоматизмом.

Работники библиотек и образования признают, что последние годы стали для них тяжёлым испытанием. Они постоянно подвергаются давлению — от угроз и оскорблений до сокращений и пересмотра программ. Теперь к этому добавилась новая нагрузка: необходимость адаптироваться к системам, которые обещают «помогать», но фактически ограничивают свободу действий. Всё это сопровождается эмоциональным выгоранием и ощущением бессмысленности, когда на место осмысленной работы приходит принудительная «автоматизация».

Такая трансформация ведёт к тому, что свободный доступ к знаниям превращается в привилегию, а не право. Дети растут в условиях, где книги проходят через цифровые фильтры, «нежелательные» темы исключаются, а преподаватели опасаются обсуждать сложные вопросы. Исследования всё чаще проводятся не людьми, а закрытыми системами искусственного интеллекта, разработанными компаниями, аффилированными с политическими структурами. Учебные заведения, стремясь показать «инновационность», принимают участие в грантовых программах по внедрению ИИ и тем самым усиливают зависимость от технологий, контролирующих доступ к информации.

Специалисты предупреждают, что подобное слияние цензуры и машинного анализа превращает библиотеки и школы в элементы управляемой информационной экосистемы. В ней знания подчиняются идеологическим фильтрам, а общественное доверие к экспертам и учёным постепенно разрушается. В мире, где алгоритм заменяет профессиональное суждение, исчезает сама культура проверки фактов и критического мышления. И именно это, по словам исследователей, делает искусственный интеллект и авторитарные тенденции естественными союзниками — не потому что они преследуют одни и те же цели, а потому что оба ускоряют процесс деградации человеческого знания.