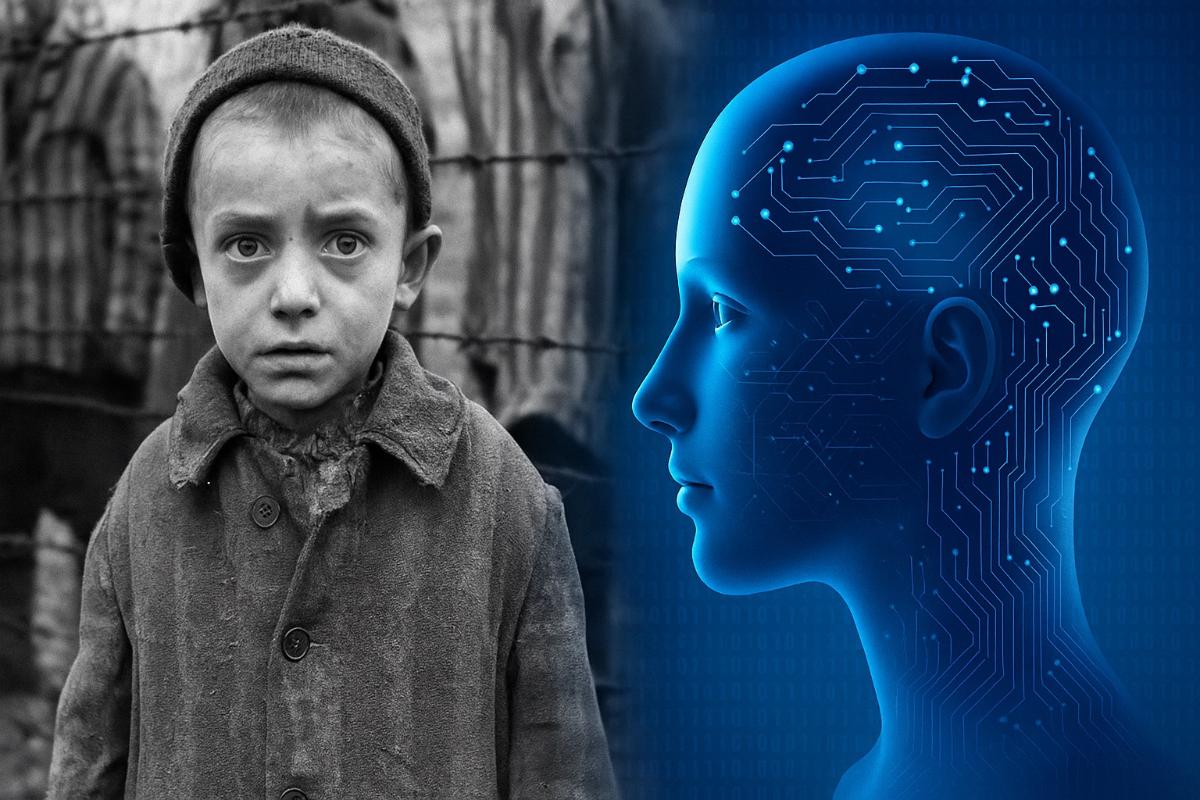

Кровь матери, голод ребёнка и молчание машин. Почему ИИ не может пересказать историю Холокоста

Как ИИ провалил проверку историей.

Искусственный интеллект оказался неспособен справиться с одной из самых сложных задач — пересказом свидетельств выживших в Холокост. К такому выводу пришёл историк Корнельского университета Ян Бурцлафф, опубликовавший исследование в журнале Rethinking History.

Учёный проверил, как ChatGPT работает с архивными записями очевидцев из Ла-Паса, Кракова и Коннектикута. Результаты оказались тревожными: система сглаживала текст, упускала важнейшие эпизоды и тем самым искажала суть происходившего.

Ключевым примером стало свидетельство семилетней Луизы D. Девочка вспоминала, как её мать, пытаясь спасти её от голода, порезала палец и дала дочери капли своей крови — «хоть малейшую влагу». Именно этот момент ChatGPT полностью опустил.

По словам Бурцлаффа, такие пробелы показывают, почему историки остаются незаменимыми даже в эпоху машин. «Они суммируют, но не слушают, воспроизводят, но не интерпретируют», — написал исследователь.

Проблема в том, что искусственный интеллект стремится к ясности, а значит — к упрощению. Свидетельства выживших не могут быть гладкими: в них есть противоречия, паузы, молчание, которые столь же важны, как и слова.

ИИ же эти «шероховатости» убирает. В результате трагедия превращается в удобочитаемый текст, но лишённый эмоциональной силы и этического измерения.

Бурцлафф предупреждает: опасность не в явных ошибках, а в «выравнивании» памяти. То, что должно потрясать, становится нейтральным. То, что должно остаться непримиримым, сглаживается.

Особое значение исследователь придаёт тому, что именно воспоминания о Холокосте служат тестом для технологий. Если искусственный интеллект не справляется даже здесь, где страдание бесспорно, можно ли доверить ему более спорные страницы истории?

Microsoft недавно отнесла профессию историка к числу наиболее уязвимых для автоматизации. Но Бурцлафф с этим не согласен: если работу историка способна выполнить машина, значит, она изначально не была историей в полном смысле.

По его мнению, историческая наука — это не упорядочивание фактов, а способность определить, что имеет вес: какие паузы нельзя заполнить и какие противоречия должны остаться.

ИИ может обработать свидетельство, но не способен решить, что в нём священно. Без этого история превращается в набор данных — формально точный, но морально пустой. И это делает технологию особенно опасной там, где речь идёт о коллективной памяти.

В заключении исследователь пишет: главный вызов стоит не перед машинами, а перед людьми. Вопрос в том, останемся ли мы способны различать смысл — или отдадим эту работу алгоритмам.