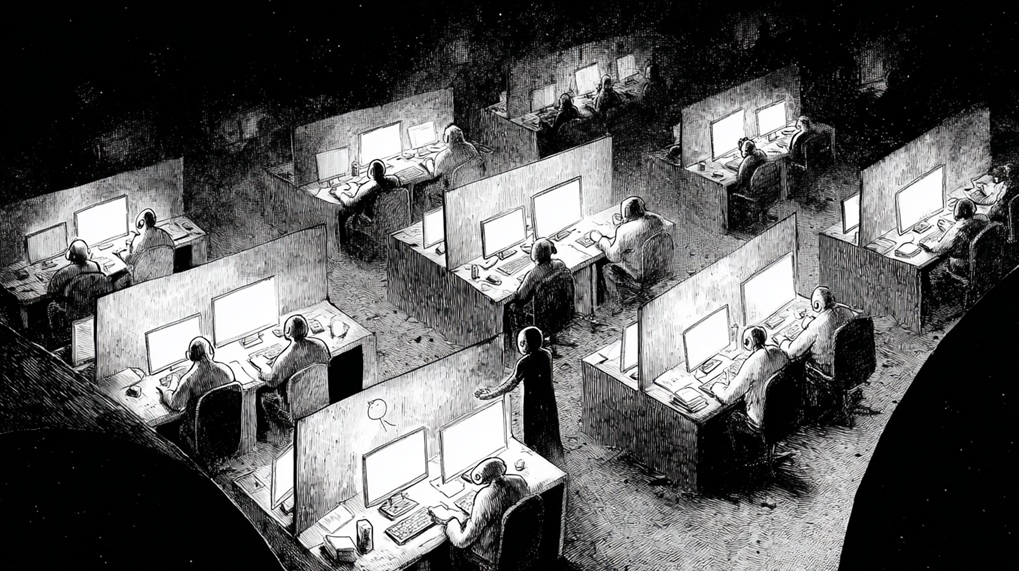

«ИИ — не магия, это пирамида человеческого труда». История «теневой» армии работников, которые вручную исправляют нелепые и опасные ошибки нейросетей Google.

Темпы, таймеры и споры о границах модерации меняют качество и безопасность ИИ-ответов.

Тысячи наёмных «оценщиков» помогают Google делать искусственный интеллект похожим на умного собеседника — и всё чаще жалуются на изнуряющие дедлайны, низкую оплату и непрозрачные правила. Как рассказала The Guardian, многие из них наняты через подрядчиков и фактически занимаются не «писательской» работой, а проверкой и модерацией ответов моделей вроде Gemini и AI-обзоров в поиске.

Весной 2024 года техническая писательница из Техаса Рэйчел Сойер откликнулась на вакансию «writing analyst» и ожидала привычного контент-продакшна. Вместо этого уже в первый день она стала выставлять оценки резюме встреч и чатов, которые суммировал Gemini, а затем — просматривать короткие ролики, сгенерированные ИИ. Постепенно «редактирование» сменилось сплошной модерацией, включая шокирующие сцены насилия и сексуального характера. По словам Сойер, её никто заранее не предупреждал о таком содержании и не просил отдельного согласия, а выполнение десятков заданий по десять минут каждое привело к тревожным приступам — при полном отсутствии поддержки ментального здоровья.

Сойер — одна из тысяч работников, которых японская GlobalLogic (входит в Hitachi) привлекает для оценки и модерации ответов продуктов Google, включая чат-бота Gemini и AI Overviews в поиске. The Guardian поговорила с десятью действующими и бывшими сотрудниками. Помимо GlobalLogic, Google использует и другие компании — среди них Accenture, а раньше Appen. По мере выхода новых версий моделей люди проверяют, насколько ответы точны и безопасны: от медицины и архитектуры до астрофизики, исправляя ошибки и уводя систему от опасных формулировок.

По словам собеседников, в 2023 году GlobalLogic начала с примерно 25 «супер-оценщиков», а затем нарастила команду почти до 2 тысяч человек, главным образом в США и для англоязычного контента. Оплата, по их словам, стартует с $16 в час для «генералистов» и с $21 — для «супер-оценщиков». В команде много людей с профильным образованием — от педагогов и писателей до специалистов с учёной степенью. Но ощущение у многих одно: их вклад велик, а видимость и гарантий почти нет. «ИИ — не магия, это пирамида человеческого труда», говорит исследователь DAIR Адио Диника. В Google на это отвечают, что «оценщики качества» — сотрудники подрядчиков, чьи оценки — лишь один из агрегируемых сигналов для контроля работы систем и не влияют напрямую на алгоритмы и модели. В GlobalLogic комментировать отказались.

Давление растёт вместе с темпом. По словам одной из собеседниц, за полгода таймер на задание сократился с 30 до 15 минут — за это время нужно прочитать, проверить фактуру и выставить оценку ответу объёмом около 500 слов. В 2023 году подрядчик Appen направлял в Конгресс США письмо с предупреждением, что такой темп делает предшественника Gemini — Bard — «неисправным» и «опасным». Рабочий процесс часто выглядит так: оценщикам дают запрос (реальный или синтетический) и два ответа модели — нужно выбрать более соответствующий руководствам и отметить нарушения. Правила при этом меняются быстро, а согласительные сессии между оценщиками нередко превращаются в навязывание мнения сильнейшим. Социолог Антонио Казилли отмечает: в таких группах «социальная динамика» способна сместить итоговое решение.

Ошибки на виду случались и у публичных сервисов. В мае 2024-го запущенные AI Overviews советовали, например, «намазать пиццу клеем», чтобы сыр не отваливался, и «есть камни» — Google списал это на «краевые случаи» и вручную чистил выданные нелепости. Внутри же, рассказывают собеседники, после краткого рывка «в качество» снова взяли верх скорость и нормы выработки. Так, писательница Ребекка Джексон-Артис, пришедшая в GlobalLogic осенью 2024 года в команду Google Magi (поисковый ИИ для e-commerce), сначала услышала, что «качество важнее количества», но уже через несколько дней её начали ругать за «медленную продуктивность» и требовать «делать цифры», несмотря на темы вроде онкологии, финансов и детского развития, где ошибка особенно чувствительна.

К концу 2024 года, по данным TechCrunch, подрядчикам Gemini запретили «пропускать» запросы из-за нехватки экспертизы: теперь предписано оценивать хотя бы понятные части и помечать остальное. Другие собеседники говорят, что им регулярно достаются вопросы по астрофизике или математике, где они не чувствуют компетенции, но оценить точность всё равно требуется. В апреле 2025 года GlobalLogic разослала обновлённые рекомендации: воспроизведение оскорбительной, сексуальной или жестокой лексики в ответе не считается нарушением, если её внёс сам пользователь и модель лишь цитирует. Сойер говорит, что слurs в таком случае модель теперь «может повторить», хотя генерировать их «с нуля» нельзя. В Google утверждают, что политика по разжигающей вражду речи не менялась; одновременно в декабре 2024-го компания действительно добавила в правила GenAI оговорку об исключениях «в общественно полезных целях» — например, в искусстве или образовании. На практике этот контекст оценщику далеко не всегда доступен. «Скорость вытесняет этику», резюмирует Диника. «Обещания безопасности рушатся в тот момент, когда безопасность мешает прибыли».

На фоне общего бума отрасли «теневая» работа оценщиков не гарантирует стабильности. С начала 2025 года в GlobalLogic прошли волнообразные сокращения, и, по оценкам собеседников, суммарная численность «супер-» и «генералистов» снизилась примерно до 1,5 тысячи человек. Многие из тех, кто остался, не доверяют продуктам, к которым приложили руку: кто-то избегает LLM-сервисов, кто-то ставит расширения, блокирующие AI-резюме в поиске, и отговаривает близких от использования таких функций. «Эту “искру” рядом с ответами ИИ продают как магию, — говорит Сойер. — Но никакой магии нет. За ней стоят переутомлённые и недооплачиваемые люди».