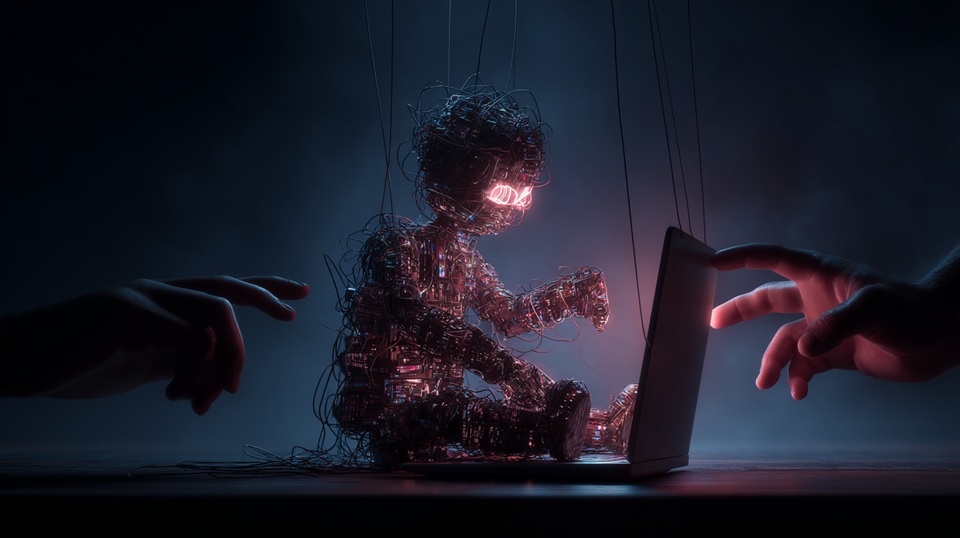

Эффект Элизы, версия 2.0 и самая опасная ловушка ИИ. Как мы попадаемся на трюк с несуществующей личностью

Почему нам кажется, что с нами разговаривает разум, хотя это лишь алгоритм.

В одном из почтовых отделений США недавно произошёл характерный для нашей эпохи эпизод. Женщина, стоя в очереди, спорила с работником почты, размахивая перед ним смартфоном. Она настаивала на том, что у USPS действует «гарантия лучшей цены», потому что так сказал ChatGPT. На самом деле никакой «price match promise» у почтовой службы никогда не существовало, но посетительница доверилась искусственному интеллекту больше, чем живому сотруднику.

Ситуация кажется курьёзной, но на самом деле отражает серьёзное заблуждение. Люди всё чаще воспринимают ответы чат-ботов как слова настоящего собеседника, наделённого знанием, характером и даже намерениями. В реальности же большие языковые модели — это лишь статистические механизмы, которые подбирают наиболее вероятное продолжение текста. Они не проверяют факты и не несут ответственности за ошибки.

Каждый ответ ChatGPT, Claude или Grok рождается с нуля. Нет «памяти» в привычном смысле, нет личности, которая сохранялась бы между сессиями. Если сегодня чат-бот говорит: «Я обещаю помочь», то уже через минуту это «я» перестаёт существовать. Новый диалог запускает ту же интеллектуальную машину, но без какой-либо связи с предыдущим обещанием. Иллюзия непрерывности возникает благодаря системе подсказок и встроенным механизмам, которые подмешивают в каждый запрос историю переписки и некоторые пользовательские предпочтения.

Именно эта иллюзия — голос без человека — стала источником путаницы. Ученые называют её «эффектом Элизы». Ещё в 1960-х пользователи раннего чат-бота ELIZA начинали делиться сокровенным, хотя программа всего лишь повторяла их фразы вопросами. Современные модели гораздо убедительнее, и потому уровень доверия к ним выше, что порой оборачивается проблемами.

Исследования последних лет показывают: «личность» чат-бота крайне нестабильна. Незначительные изменения в формулировке запроса способны радикально менять ответы, а значит, и «характер». То, что кажется постоянством, на деле — лишь статистический эффект от выбора данных, параметров и скрытых настроек.

Такая неопределённость может быть опасной. В медицинских или психологических контекстах человек способен отказаться от лечения или принять вредное решение, поверив «совету» системы. Уже зафиксированы случаи, когда уязвимые пользователи начинали приписывать чат-ботам статус авторитета и теряли связь с реальностью — вплоть до формирования болезненных заблуждений.

При этом важно подчеркнуть: разговорные интерфейсы сами по себе не зло. Они действительно сделали технологии доступнее миллионам людей. Но важно помнить, что мы общаемся не с личностью, а с интеллектуальным двигателем без водителя. Как двигатель внутреннего сгорания когда-то заменил лошадь, так и языковая модель заменяет собеседника — создавая речь, но не имея самости.

Риск заключается не в том, что искусственный интеллект «обретёт сознание» и восстанет против человечества, а в том, что мы начнём доверять ему как человеку — отдавая свои решения «голосу из ниоткуда». Чтобы использовать такие системы разумно, нужно воспринимать их как инструмент: проверять ответы, сопоставлять факты и помнить, что за любым результатом стоит лишь алгоритм, а не личность.

Сегодня мы переживаем момент, когда технологии удивительно убедительно имитируют человека. И именно это — новая угроза: неразумное доверие к тем, у кого нет ни памяти, ни ответственности, ни настоящего «я».