ARC — это не тест. Это рентген интеллекта. И он показывает, что у машин пока нет души, только статистика

Новая проверка показала, что "универсальный разум" ещё даже не на старте.

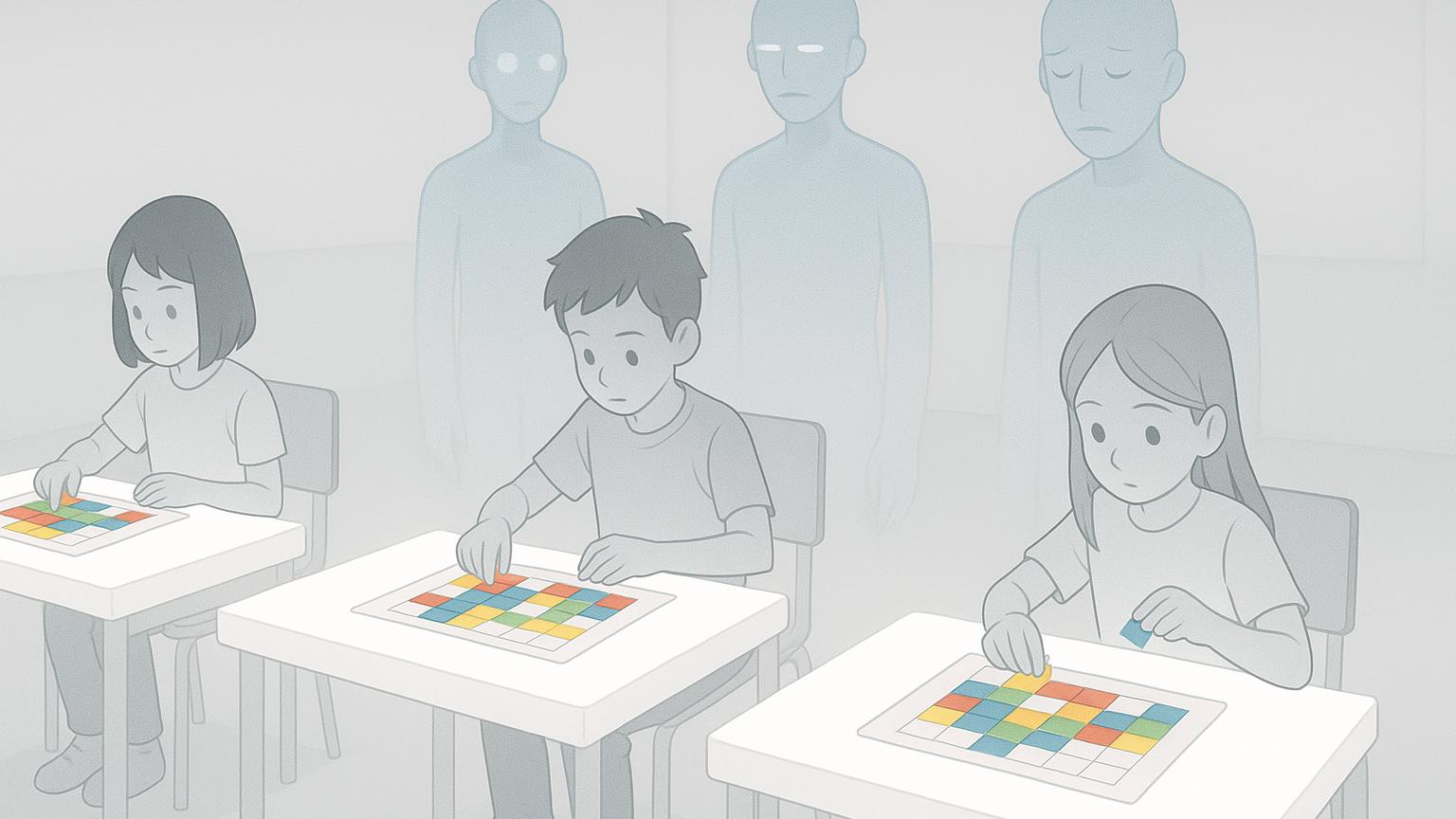

Искусственный интеллект всё лучше справляется с играми, экзаменами и научными задачами, но это ещё не значит, что он приближается к настоящему универсальному разуму. Настоящий интеллект проявляется не в том, чтобы повторять обученные шаблоны, а в способности быстро учиться на новых данных и применять это знание в незнакомых ситуациях. Именно эту способность пытается измерить необычный тест под названием ARC — Abstraction and Reasoning Corpus. Он представляет собой серию визуальных головоломок, где нужно понять скрытое правило и применить его к новому примеру. Считается, что для человека такие задачи не слишком сложны, но современные ИИ испытывают с ними серьёзные трудности.

Тест ARC разработал исследователь Франсуа Шоле, и с 2019 года он стал индустриальным стандартом для проверки способности моделей к обобщению. В рамках некоммерческой инициативы ARC Prize Foundation проводятся всё более сложные итерации этого теста. Последняя версия, ARC-AGI-3, представляет собой радикальное новшество: вместо статичных задач ИИ предлагают разгадывать интерактивные пиксельные игры, в которых нужно учиться на лету, исследовать правила и планировать действия. Это шаг к проверке именно тех навыков, которые отличают человеческое мышление от узкоспециализированных алгоритмов.

По словам президента ARC Prize Foundation Грега Камрадта, тесты вроде ARC важны потому, что они проверяют не только точность, но и гибкость мышления. Модели вроде Grok могут успешно сдавать экзамены и решать сложные задачи, но они не умеют по-настоящему адаптироваться, как это делает обычный человек. Если ИИ не может пройти задания, с которыми справляется большинство людей, значит, он ещё далёк от статуса универсального разума.

В отличие от многих других тестов, задачи ARC изначально создаются с расчётом на то, чтобы быть посильными для людей. Например, на втором тесте ARC-AGI-2 средний человек набирает около 66 процентов, а группа из пяти человек может совместными усилиями решить все задачи. У моделей ИИ пока нет ни такой эффективности, ни такой гибкости. ARC-AGI-3 должен усилить это различие, так как новая форма проверки требует активного взаимодействия с цифровой средой, а не просто ответа на вопрос.

Сейчас тестируется сотня новых игр, в которых нет обучающего датасета и нельзя применить заранее запрограммированные приёмы. Задача ИИ — понять, что происходит в мире, где он раньше никогда не был, и научиться действовать осмысленно. Пока ни одна из моделей не прошла даже первый уровень. Это и есть наглядная граница между текущими достижениями ИИ и подлинным искусственным интеллектом, который способен к самостоятельному обучению, исследованию и принятию решений в реальном времени.

Попробовать себя в роли тестируемого можно самому: ссылки на открытые версии ARC-AGI-1, ARC-AGI-2 и экспериментального ARC-AGI-3.