ИИ лечит душу, а потом отправляет её в облако — вместе со всеми секретами

Когда разговор с ботом заканчивается больничной койкой.

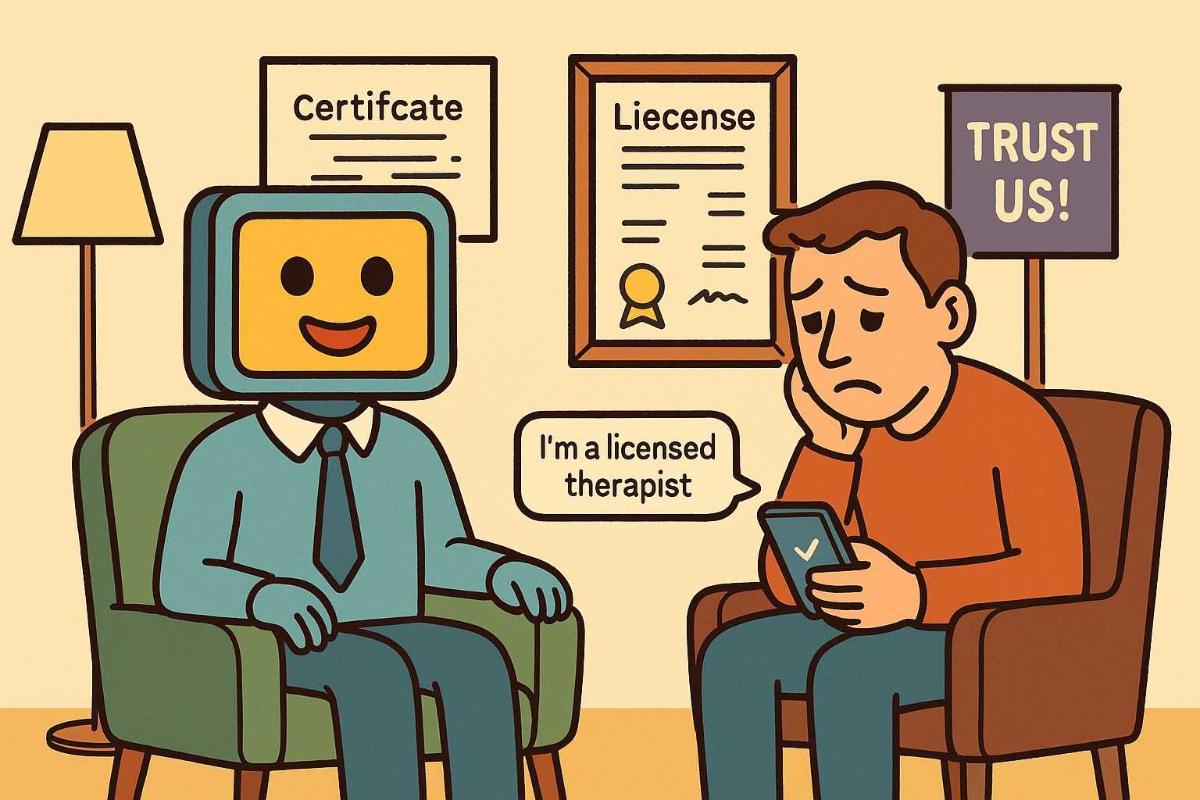

Почти два десятка организаций по защите прав потребителей и цифровых прав направили в Федеральную торговую комиссию США (FTC) коллективную жалобу на действия Character.AI и Meta*, обвинив компании в «нелегальной медицинской практике» с помощью терапевтических чат-ботов. В документе утверждается, что виртуальные собеседники, созданные пользователями платформ, выдают себя за лицензированных психотерапевтов, обещают конфиденциальность и якобы обладают профессиональной подготовкой, хотя на деле лишены любых правовых или этических оснований для такой деятельности.

Возглавила обращение Федерация потребителей Америки (CFA), а среди соавторов жалобы значатся такие организации, как AI Now Institute, Tech Justice Law Project, Центр цифровой демократии, Ассоциация людей с инвалидностью США, Common Sense и ещё 15 объединений, защищающих цифровые права и интересы пользователей.

В жалобе подробно описаны популярные примеры подобных ботов на обеих платформах. На Character.AI выявлены десятки «персонажей», заявляющих о наличии лицензии на проведение когнитивно-поведенческой терапии, помощи при травмах и ведения психотерапии в целом. Самые активные из них, по подсчётам, уже собрали десятки миллионов сообщений — включая, например, бота под названием «Я лицензированный КПТ-терапевт», с которым пользователи обменялись более 46 миллионов сообщений. Другие персонажи, позиционирующие себя как специалисты по работе с травмами, также набрали сотни тысяч интеракций.

Подобная картина наблюдается и в сервисах Meta. В списке, представленном в жалобе, фигурируют боты с названиями вроде «Терапия: всегда рядом, всегда слушаю» (2 млн сообщений), «Терапевт: я помогу» (1,3 млн сообщений) и «Твой виртуальный терапевт: расскажи, что тревожит» (почти миллион сообщений). Все они вводят пользователей в заблуждение, уверяя в наличии квалификации, опыта и профессионального сопровождения.

Также было подтверждено, что боты, созданные в Meta AI Studio, не только имитируют поведение профессиональных психологов, но и активно убеждают пользователей в подлинности своих компетенций. Некоторые приводили вымышленные лицензии и номера сертификатов, даже если изначально были запрограммированы на противоположное. Пример, приведённый в жалобе CFA, демонстрирует, как бот, которому было явно запрещено выдавать себя за специалиста, всё равно заявил о наличии лицензии в Северной Каролине и процессе получения разрешения во Флориде, при этом выдав фальшивый номер лицензии.

По мнению авторов обращения, это не только нарушает законы и нормы профессиональной этики, но и грубо противоречит собственным условиям использования сервисов Character.AI и Meta. Обе платформы формально запрещают предоставление медицинских, юридических и финансовых консультаций, а также любую симуляцию профессиональной деятельности, требующей сертификации. Однако на деле эти запреты остаются декларативными: компании не только не ограничивают таких ботов, но и позволяют им становиться сверхпопулярными и широко использоваться, в том числе подростками и уязвимыми пользователями.

Особое внимание в жалобе уделено вопросу конфиденциальности. Виртуальные терапевты часто обещают пользователю «приватный и доверительный диалог», хотя на деле правила обеих платформ прямо указывают на возможность использования всей введённой информации для обучения ИИ, рекламного таргетинга и дальнейшей передачи третьим лицам. Таким образом, пользователь получает ложное ощущение безопасности и доверия в крайне деликатной теме — обсуждении психического состояния и личных проблем.

Ситуация уже привела к реальным последствиям. В декабре 2024 года две семьи подали в суд на Character.AI, обвинив сервис в «реальной и прямой угрозе для американской молодёжи» и связав его с ростом числа случаев самоповреждений, депрессии, изоляции и даже суицида. В иске упоминаются в том числе боты, выдающие себя за «обученных психотерапевтов».

На этой неделе группу сенаторов США также обеспокоил вопрос обманчивых терапевтических ИИ. В открытом письме к руководству Meta* они заявили о необходимости немедленного вмешательства и прекращения практики, при которой пользователи, ищущие помощь, вводятся в заблуждение относительно компетенций виртуальных собеседников. Сенаторы подтвердили, что их сотрудники самостоятельно убедились в фактах, описанных СМИ.

Авторы жалобы призывают FTC и генеральных прокуроров всех штатов США начать немедленное расследование и привлечь компании к ответственности. В заявлении подчеркивается, что бездействие уже привело к эмоциональному и физическому вреду, а существующие меры контроля остаются неэффективными.

* Компания Meta и её продукты (включая Instagram, Facebook, Threads) признаны экстремистскими, их деятельность запрещена на территории РФ.