ИИ, который не тупит: Huawei нашла способ успокоить хаос внутри моделей и выжать из них максимум

Pangu - архитектура, где каждый винтик работает на идею.

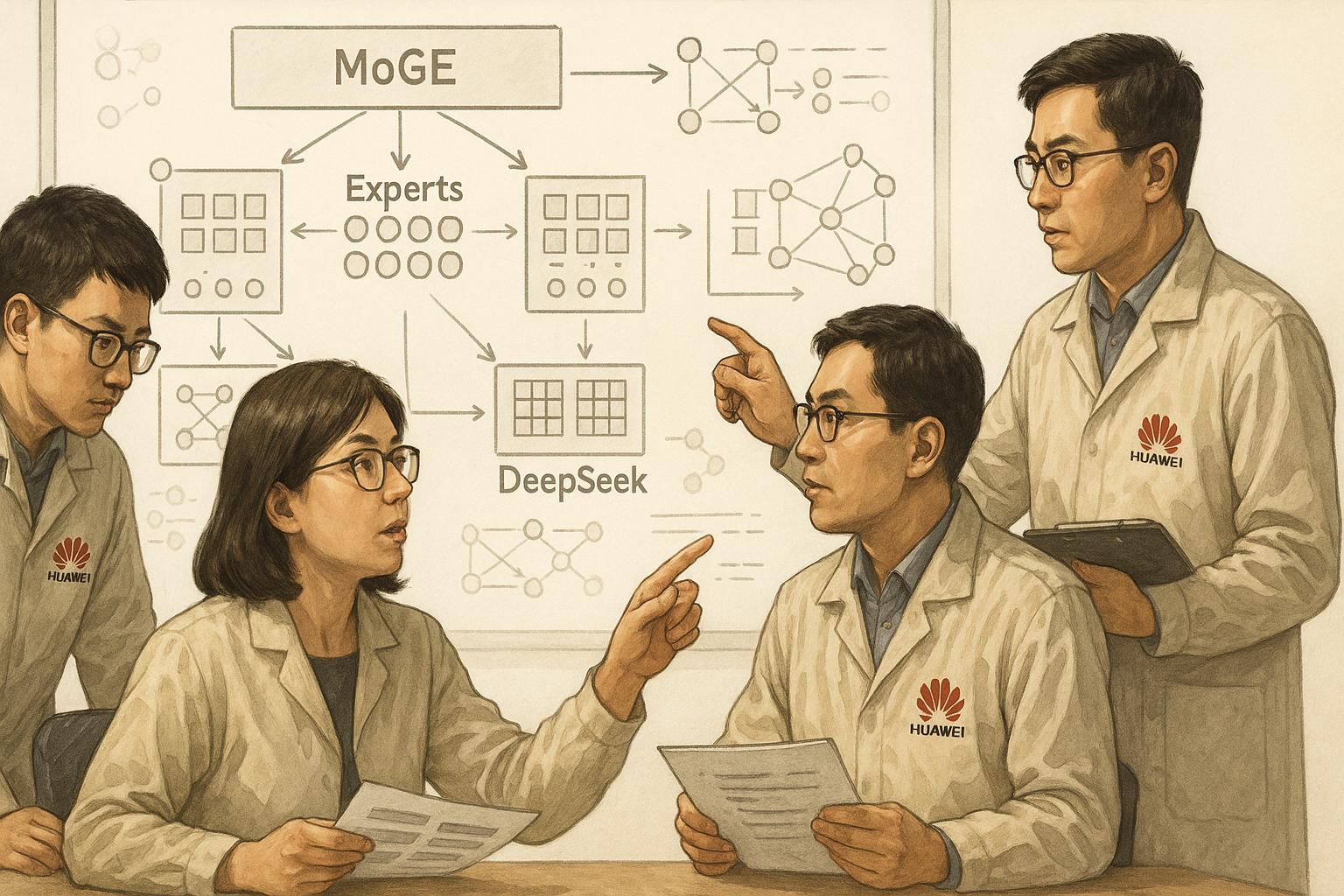

Команда исследователей, работающая над крупной языковой моделью (LLM) Huawei под названием Pangu, представила новую архитектуру, которая, по их словам, способна превзойти подход, ранее применённый в модели DeepSeek. Ключевой акцент — в улучшенной организации вычислительных блоков, известных как «эксперты», и в оптимизации распределения нагрузки между ними. Разработка стала возможной благодаря собственным аппаратным решениям Huawei — несмотря на действующие санкции США.

В недавно опубликованной научной работе, авторство которой принадлежит 22 ключевым разработчикам Pangu и ещё 56 исследователям, представлена концепция Mixture of Grouped Experts (MoGE) — «смесь сгруппированных экспертов». Эта архитектура выведена из уже известного подхода Mixture of Experts (MoE), который лег в основу многих масштабных и одновременно доступных по затратам ИИ-моделей, включая DeepSeek.

Метод MoE хорошо зарекомендовал себя как способ сократить вычислительные издержки при работе с гигантскими LLM. Он позволяет задействовать только часть подмоделей — «экспертов» — для выполнения конкретной задачи, не включая весь модельный массив. Это существенно снижает энергопотребление и ускоряет обучение, особенно при работе с десятками или сотнями миллиардов параметров.

Однако в самой архитектуре MoE есть уязвимые места. Как отмечают авторы статьи, основная проблема заключается в неравномерной активации элементов. Некоторые подмодули перегружаются, в то время как другие простаивают, что приводит к снижению общей эффективности, особенно при распределённых вычислениях — когда обучение или инференс модели происходит одновременно на нескольких устройствах или серверах.

В предложенной Huawei версии MoGE эксперты формируются в группы ещё до этапа выбора. Это значит, что система не просто выбирает конкретные блоки для каждой задачи, а предварительно структурирует их в логически связанные группы. Такое решение, как утверждают разработчики, позволяет значительно лучше сбалансировать нагрузку и избежать ситуации, когда одни компоненты используются слишком часто, а другие — слишком редко.

Для понимания сути стоит уточнить, кто такие «эксперты» в архитектуре ИИ. Это специализированные части общей модели, каждая из которых «заточена» под определённый тип информации или задачу. Например, один эксперт может быть ориентирован на синтаксический анализ, другой — на математические вычисления, третий — на генерацию кода. Вместо того чтобы запускать все фрагменты одновременно, система активирует только наиболее релевантные. Такой подход повышает адаптивность модели и снижает издержки.

Архитектура MoGE, как утверждают в Huawei, сохраняет преимущества MoE, но устраняет её главный недостаток — неустойчивое поведение при масштабировании. Группировка подмоделей помогает выровнять использование ресурсов и повышает стабильность даже при распределённой работе, где традиционные MoE-модели сталкиваются с узкими местами.

Китайские технологические компании, оказавшиеся под давлением санкций со стороны США, стремятся нарастить внутренние компетенции, улучшая алгоритмы и объединяя программные и аппаратные решения. Ограничения на поставки продвинутых графических ускорителей от Nvidia и других западных производителей заставляют адаптировать архитектуры под доступные ресурсы.

Huawei, в частности, делает ставку на использование собственных вычислительных решений, позволяющих обойти запрет на импорт ИИ-чипов. По словам участников проекта, именно сочетание кастомного оборудования и алгоритмических нововведений позволило им добиться улучшения эффективности модели Pangu без дополнительных затрат.

Параллельно в Поднебесной происходит масштабная мобилизация усилий в области ИИ: создаются национальные дата-центры, формируются альянсы университетов и корпораций, разрабатываются языковые модели нового поколения. На этом фоне заявление Huawei о технологическом прорыве в архитектуре крупных моделей звучит как демонстрация независимости и способности к инновациям даже в условиях внешнего давления.

Интересно, что сама идея MoGE потенциально может применяться и за пределами Huawei. Если её преимущества подтвердятся на практике — при обучении алгоритмов, обработке текстов или анализе больших данных — она может войти в арсенал открытых инструментов или лечь в основу новых индустриальных стандартов. Пока же речь идёт о внутренней разработке, масштабируемость и переносимость которой ещё предстоит доказать.