Грамматика, как у профессора, а это фишинг. Да, теперь ИИ — ваш враг

Почему идеальная орфография в письме — главный признак того, что вас обманывают.

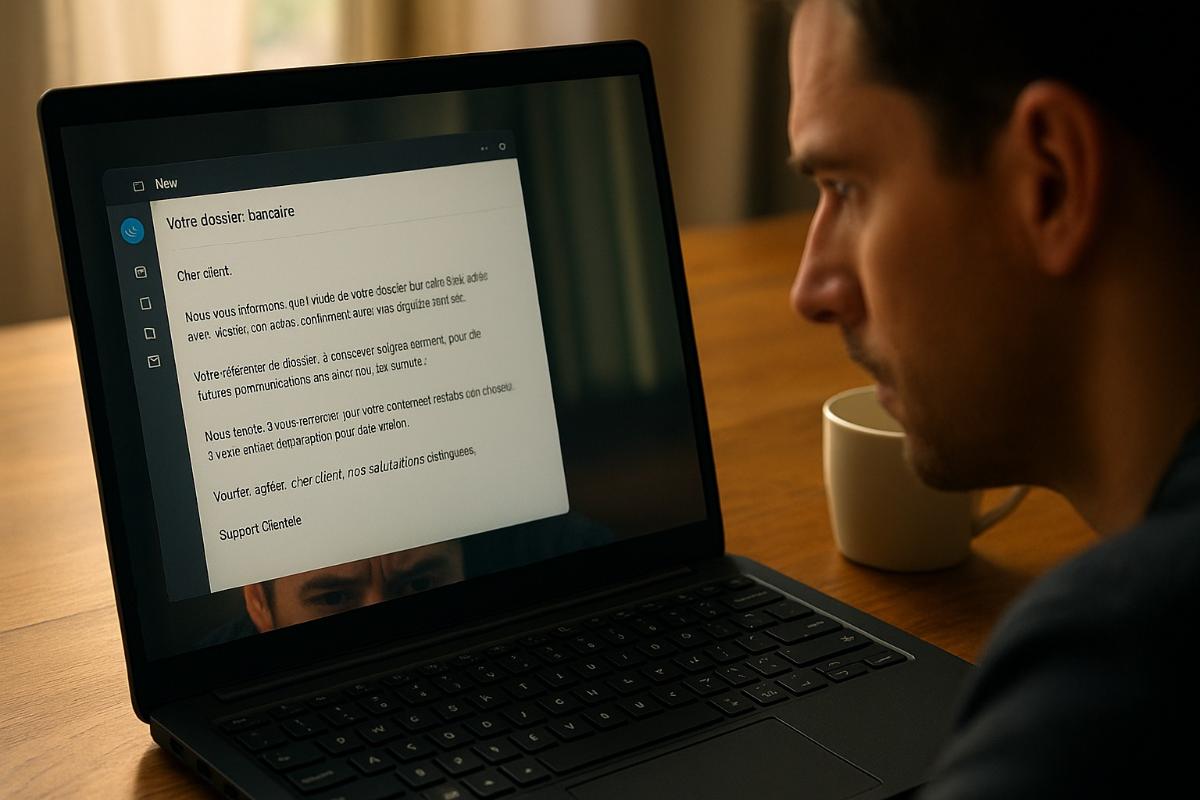

Идея, что спам легко распознать по корявой орфографии и убогому синтаксису, больше не работает. Генеративные нейросети не просто повысили качество мошеннических писем — они превратили их в безупречные, культурно и лингвистически адаптированные сообщения, которые всё труднее отличить от настоящей переписки. Спам больше не выглядит подозрительно — он выглядит идеально. И именно это стало новым красным флагом.

Раньше мошенники ограничивались английским, испанским или, в лучшем случае, формальным французским, потому что нанимать носителей других языков было долго, дорого и бессмысленно. Теперь с помощью ИИ преступники без труда генерируют письма и сообщения на любом диалекте, от квебекского до европейского варианта португальского. В итоге жертвы получают убедительные фейковые письма, написанные так, будто их написал сосед по лестничной клетке.

По словам Честера Висневского, глобального CISO компании Sophos, на конференции RSAC, сейчас, вероятно, до половины всего спама создаётся нейросетями. Он подчёркивает: грамматика и пунктуация в таких письмах стали настолько безупречными, что это, наоборот, должно настораживать. Люди, в отличие от машин, почти всегда допускают ошибки — даже если пишут на родном языке.

Переход к ИИ дал злоумышленникам ещё одно преимущество — масштабируемость. Они больше не ограничены ни географией, ни языками. В Квебеке, например, фишинг долгое время проваливался просто потому, что приходил на формальном французском, а не на привычном квебекском. Теперь нейросети генерируют такие фразы, которые звучат абсолютно нативно. Похожая ситуация и в Португалии: раньше мошенники ориентировались на Бразилию как на более массовый рынок, но теперь европейский вариант языка также попал в зону риска.

Одна из самых коварных форм обмана, романтическое мошенничество, также претерпело трансформацию. На первых этапах «соблазнения» с жертвой переписывается чат-бот, искусно играющий роль сочувствующего, внимательного и заинтересованного собеседника. Как только контакт установлен, к делу подключается человек — и начинается просьба о помощи, переводах денег или заманивание в финансовые аферы под видом инвестиций.

Но, пожалуй, самая опасная технология, ставшая массовой благодаря ИИ, — это дипфейк-аудио. По словам Висневского, сегодня можно буквально за копейки сгенерировать голос любого сотрудника — например, специалиста IT-отдела — и обзвонить всех коллег с просьбой выдать пароль или другую чувствительную информацию. Такой обман работает в реальном времени и не требует особых технических навыков.

Что касается видео-дипфейков, здесь пока сохраняется относительное спокойствие. Висневский высказывает сомнения по поводу громких инцидентов, вроде случая в Гонконге, где якобы видеозвонок с дипфейком убедил сотрудника перевести $25 миллионов. Он считает, что это скорее попытка списать ошибку на модную угрозу, чем реальный пример. Даже крупнейшие компании пока не умеют делать реалистичные интерактивные видеомодели — но это лишь вопрос времени. Он прогнозирует, что при текущих темпах развития технологии массовые дипфейки в видеозвонках станут реальностью уже через два года.

Однако с ним не согласен операционный директор NCC Group Кевин Браун. По его словам, команда пентестеров уже добилась определённых успехов в создании видеофейков для конкретных задач. Технология существует, просто ещё не поставлена на поток. Но и это лишь вопрос времени.

И Висневский, и Браун сходятся в одном: пора перестраивать систему верификации общения. Старые признаки фишинга — орфографические ошибки, ощущение спешки и несвязная речь — больше не работают. Будущее за проверкой личности по новым каналам, которые пока ещё не подделываются на лету.