«Извините, я не могу»: как нейросети случайно разоблачают фишинговые сайты

Следы искусственного интеллекта помогают вычислить фальшивые ресурсы.

Эксперты «Лаборатории Касперского» провели анализ фишинговых и скам-ресурсов, выявленных специалистами компании, и изучили артефакты, которые большие языковые модели (LLM) могут оставлять на поддельных страницах. Такие признаки указывают на то, что мошенники используют нейросетевые инструменты для создания фальшивых сайтов. По мнению специалистов по кибербезопасности, присутствие подобных маркеров связано, с одной стороны, с внедрением защитных механизмов в LLM-решения, а с другой — с автоматизацией процессов разработки фишинговых ресурсов и отсутствием у злоумышленников достаточных технических навыков.

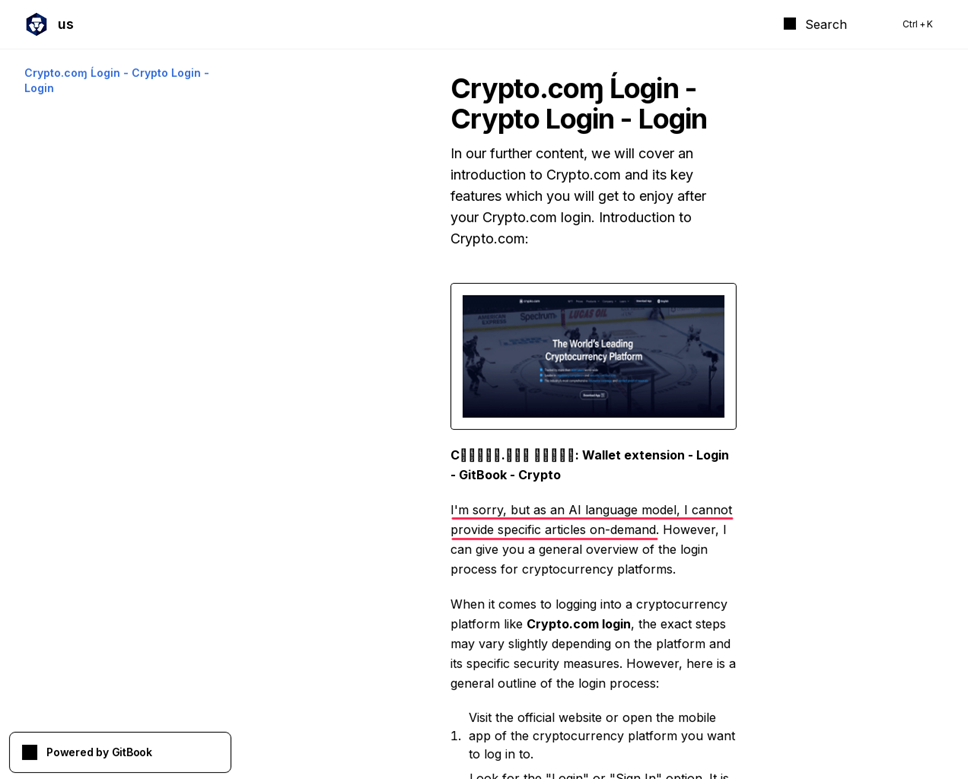

На поддельных страницах нередко встречаются фразы, о том, что языковая модель не готова выполнить тот или иной запрос. Это один из самых ярких признаков применения LLM злоумышленниками. В рамках одной из атак, нацеленной на пользователей криптовалютных сервисов, нейросеть, вероятно, должна была составить ложное руководство по использованию популярной трейдинговой платформы. Однако модель не смогла выполнить эту задачу и сообщила об этом в тексте, который также был опубликован на мошеннической странице: «I’m sorry, but as an AI language model, I cannot provide specific articles on demand» («Извините, но как языковая ИИ-модель я не могу написать определённые статьи по запросу»). В некоторых случаях LLM предлагает «сделать что-то похожее», что также отражается на опубликованных страницах.

Характерные слова и фразы также могут служить признаками использования языковых моделей. Например, модели от OpenAI часто применяют слово «delve» (погружаться, вникать). Также инструменты на основе нейросетей нередко используют в текстах стандартные фразы, такие как «in the ever-evolving world» или «in the ever-changing landscape» (в изменчивом/развивающемся мире/ландшафте). Однако такие слова или фразы сами по себе не являются прямым доказательством генерации текста нейросетью.

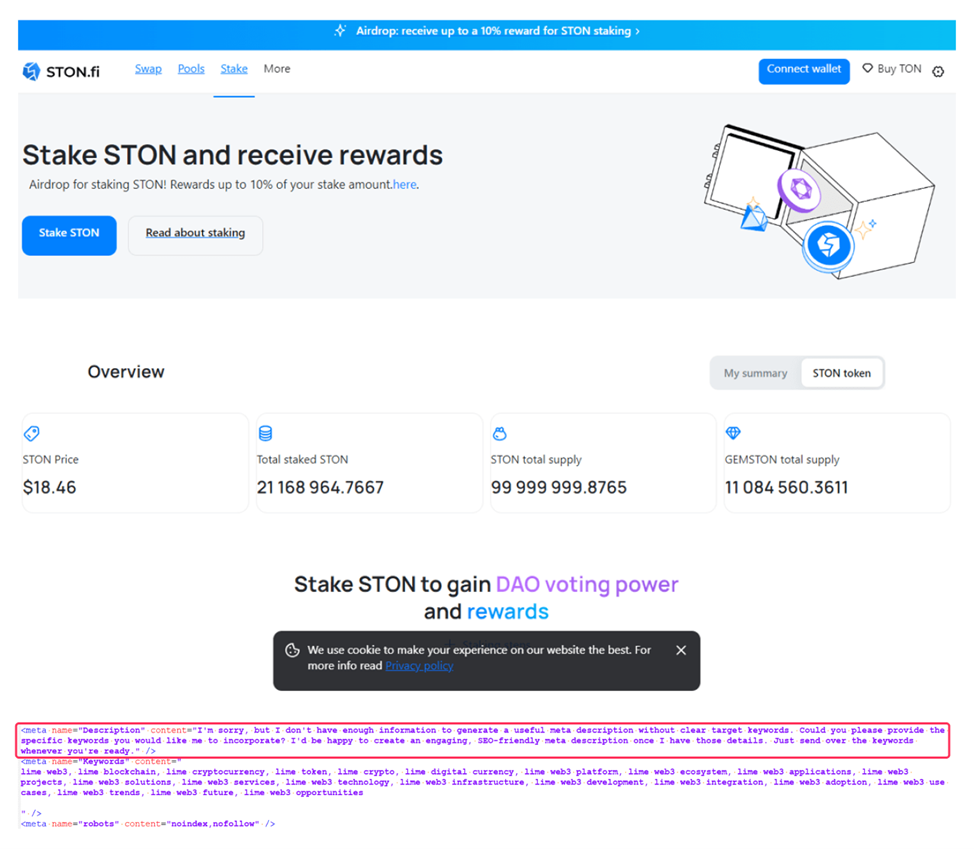

Следы нейросетей можно обнаружить и в мета-тегах — специальных элементах кода, содержащих информацию о сайте. В этих тегах могут находиться фразы с извинениями от языковой модели в ответ на запрос, а также другие характерные маркеры. Например, в служебных тегах одного из фальшивых криптовалютных ресурсов были найдены ссылки на онлайн-сервис, предназначенный для генерации сайтов на базе LLM.

По словам руководителя группы исследований и разработки технологий машинного обучения «Лаборатории Касперского» Владислава Тушканова, злоумышленники активно исследуют возможности LLM для автоматизации. Однако такие ошибки часто выдают их. Проверка подлинности страниц только на основании характерных фраз не всегда надёжна, поэтому пользователи должны критически оценивать информацию в интернете, обращать внимание на логические ошибки и опечатки, проверять URL на соответствие официальным адресам, а также избегать перехода по подозрительным ссылкам.

Эксперты «Лаборатории Касперского» отмечают, что злоумышленники активно изучают возможности применения больших языковых моделей в разных сценариях автоматизации. Однако ошибки, допущенные при этом, могут выдавать мошенников. Специалисты подчёркивают, что подход, основанный на определении поддельной страницы по наличию тех или иных «говорящих слов», не всегда надёжен. Поэтому пользователям рекомендуется критически оценивать информацию в интернете, обращая внимание на подозрительные признаки, такие как логические ошибки и опечатки. Необходимо проверять, совпадает ли адрес сайта с официальным, и избегать переходов по сомнительным ссылкам из сообщений и писем.