Хакеры взломали ИИ: LLMjacking позволяет продавать доступ к мозгам машин

Атака приносит убыток в $46 000 ежедневно.

Специалисты Sysdig обнаружили новую схему атаки, при которой украденные учетные данные к облачным сервисам используются для доступа к услугам облачных LLM-моделей с целью продажи доступа другим киберпреступникам. Обнаруженная атака была направлена на модель Claude (v2/v3) от Anthropic и получила название LLMjacking.

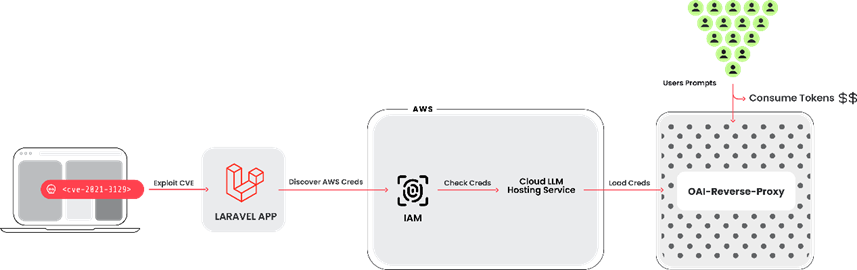

Для выполнения атаки злоумышленник взломал систему с уязвимой версией фреймворка Laravel (RCE-уязвимость CVE-2021-3129 с оценкой CVSS: 9.8), после чего завладел учетными данными Amazon Web Services (AWS), чтобы получить доступ к LLM-сервисам.

В числе использованных инструментов — скрипт на Python с открытым исходным кодом, который проверяет ключи для различных сервисов от Anthropic, AWS Bedrock, Google Cloud Vertex AI, Mistral и OpenAI.

Атакующий использовал API для проверки своих полномочий без привлечения внимания. Например, отправка запроса с параметром «max_tokens_to_sample» установленным в -1 не вызывает ошибку доступа, а возвращает исключение «ValidationException», что подтверждает наличие у аккаунта жертвы доступа к сервису. Отмечается, что во время проверки никакие запросы к LLM не выполнялись. Достаточно было установить, какие права имеют учетные записи.

Кроме того, киберпреступник использовал инструмент oai-reverse-proxy, который действует как обратный прокси-сервер для API LLM-модели, что позволяет продавать доступ к скомпрометированным аккаунтам, не раскрывая исходные учетные данные.

Цепочка атаки LLMjacking

В Sysdig объяснили, что такое отклонение от традиционных атак, направленных на внедрение команд и «отравление» моделей, позволяет хакерам монетизировать доступ к LLM, в то время как владелец облачного аккаунта оплачивает счета, не подозревая об этом. По данным Sysdig, подобная атака может привести к затратам на услуги LLM более $46 000 в день для жертвы.

Использование LLM может быть дорогостоящим, в зависимости от модели и количества подаваемых в нее токенов. Максимизируя ограничения квот, злоумышленники также могут помешать скомпрометированной организации использовать модели, нарушая бизнес-операции.

Организациям рекомендуется включить подробное ведение журналов и контролировать облачные журналы на предмет подозрительной или несанкционированной активности, а также обеспечить эффективное управление уязвимостями, чтобы предотвратить первоначальный доступ.