AIRI представил первую российскую мультимодальную языковую модель OmniFusion 1.1

Она способна поддерживать визуальный диалог и отвечать на вопросы по картинкам.

Институт искусственного интеллекта (ИИ) AIRI выпустил открытую версию своей мультимодальной языковой модели OmniFusion 1.1. Эта передовая разработка представляет собой первую в России языковую модель, способную вести визуальный диалог и отвечать на вопросы пользователей по картинкам. В перспективе модель сможет работать не только с картинками, но также с аудио, 3D и видеоконтентом. Открытый исходный код для обучения и ее веса модели доступны для свободного использования.

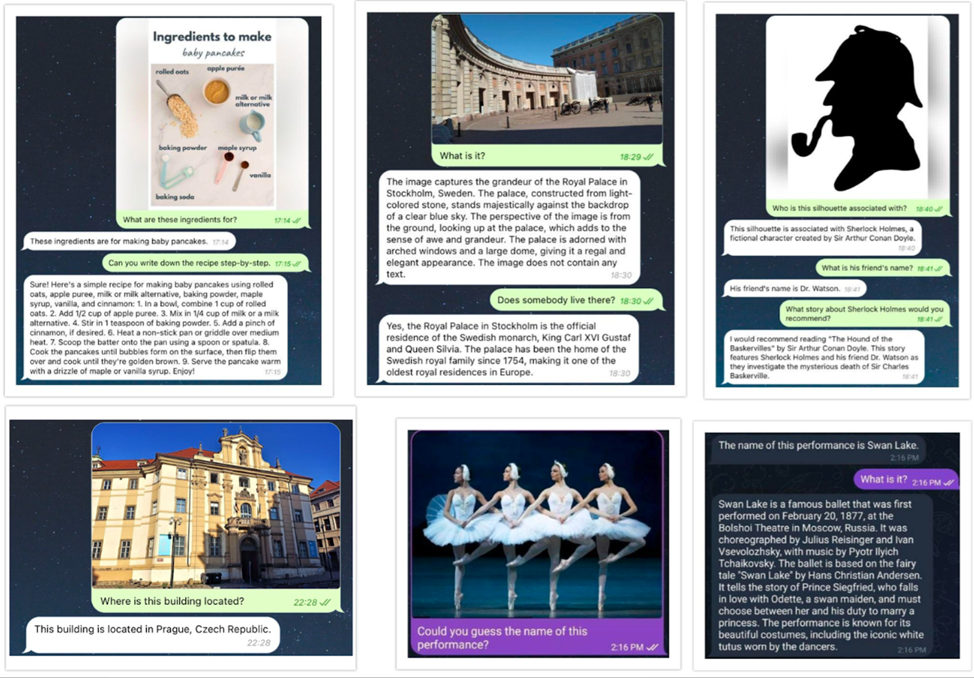

Согласно заявлениям разработчиков, OmniFusion может распознавать и описывать изображения. Используя эту модель, можно получить объяснения того, что изображено на фотографии, узнать рецепт для приготовления блюда по фото ингредиентов, проанализировать карту помещения, понять, как собрать устройство по фотографиям его отдельных частей, или проанализировать медицинские изображения и указать проблему. Однако для последней задачи модель необходимо дополнительно обучить на специализированных наборах данных с привлечением экспертов в области медицины.

Примеры работы модели OmniFusion 1.1

Качество работы модели в различных вариантах ее архитектуры было оценено с помощью 8 известных бенчмарков, включая TextVQA (бенчмарк для оценки ответов на вопросы по изображениям с текстом), POPE (бенчмарк для оценки случаев, когда модель начинает выдумывать несуществующие данные в ответах) и ScienceQA (бенчмарк с вопросами на научные темы, основанными на лекциях).

В основе архитектуры OmniFusion лежит методика совмещения предварительно обученной большой языковой модели и визуальных энкодеров, позволяющих кодировать информацию на изображении в числовой вектор, называемый эмбеддингом.