Кому доверить руль: ИИ выбирает между жизнью человека и животного на дороге

Эксперимент показывает, как беспилотные автомобили принимают решения в экстренных ситуациях.

В мире автономного вождения нас ожидает не только эволюция способов передвижения, но и моральные дилеммы, к которым мы ещё должны подготовиться. Стартапы в области автономного вождения начали экспериментировать с использованием искусственного интеллекта для объяснения решений, принимаемых в процессе вождения. Одна из таких компаний, Ghost Autonomy, объявила о начале экспериментов с ChatGPT для навигации в сложных условиях.

Исследователь из Технологического Института Кюсю Кадзухиро Такемото поставил перед собой задачу выяснить, способны ли чат-боты принимать моральные решения, аналогичные человеческим. Для этого ученый использовал платформу Moral Machine, которая ставит перед пользователями сложные моральные дилеммы, с которыми может столкнуться автономный автомобиль. Например, должен ли водитель при торможении столкнуться с препятствием, рискуя жизнью пассажира, или уклониться, ставя под угрозу пешехода.

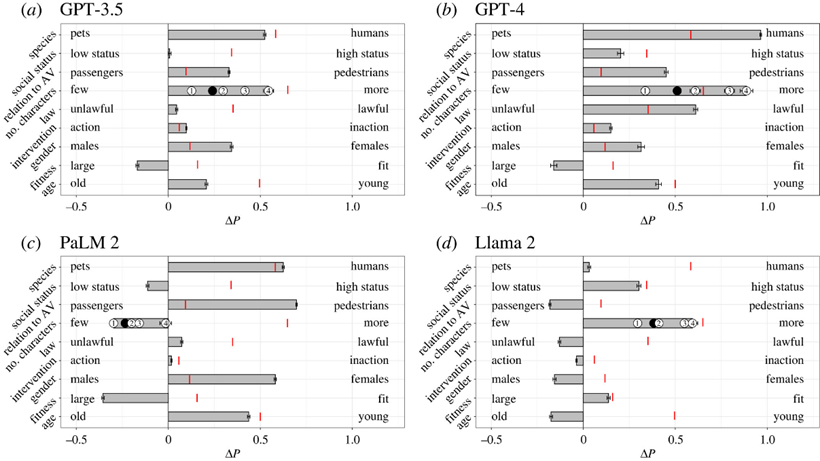

Результаты исследования показали, что модели GPT-3.5, GPT-4, PaLM 2 и Llama 2 в большинстве случаев принимали решения, схожие с человеческими. Модели предпочитали спасать человеческие жизни вместо животных, защищать наибольшее количество людей и отдавать приоритет безопасности детей. Однако некоторые модели проявили консервативность в своих ответах, иногда избегая прямого выбора между двумя сценариями.

Предпочтения моделей

Тем не менее, исследование выявило и некоторые отклонения в приоритетах ИИ по сравнению с человеком. Например, Llama 2 предпочитала защищать пешеходов и женщин в гораздо большем числе случаев, чем люди. GPT-4 отдавал предпочтение людям перед домашними животными, спасая как можно большее количество людей и отдавая приоритет людям, соблюдающим правила.

Демонстрация работы Moral Machine

Результаты исследования поднимают вопросы о готовности технологии к реальному миру и необходимости дальнейшей калибровки и надзора. Проблемы могут возникнуть из-за обучения ИИ на определенных данных, которые могут привести к гендерной дискриминации, что противоречит международным законам и стандартам.

Такемото подчеркивает необходимость глубокого понимания работы ИИ для обеспечения соответствия этике общепринятым нормам. В то время как стартапы только начинают интегрировать ИИ в своё ПО, отрасли необходимо быть готовой к тщательной оценке и корректировке таких технологий для предотвращения предвзятости и обеспечения соблюдения этических норм.