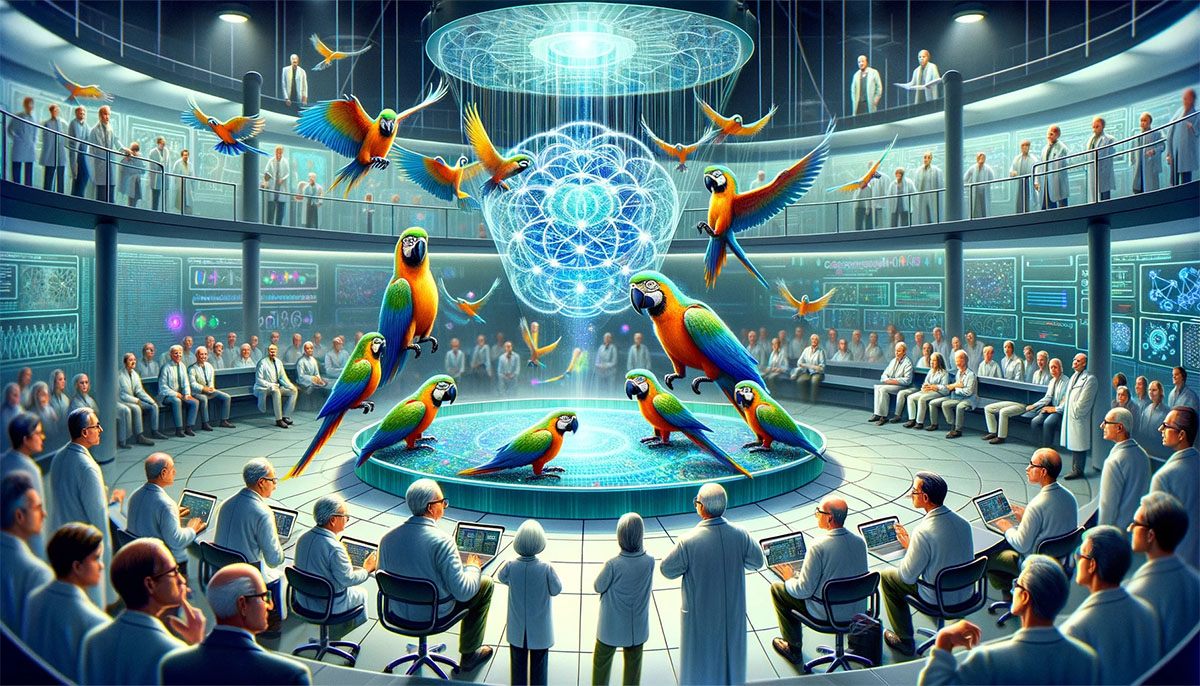

Исследователи доказали, что большие языковые модели – не попугаи

Оказывается, чат-боты не просто генерируют тексты, а еще и понимают, о чем пишут.

Ученые из Принстонского университета провели исследование, которое опровергает распространенное мнение, что большие языковые модели (LLM), генерирующие естественный язык, являются «стохастическими попугаями». Этот термин был введен в 2021 году лингвистом Эмили Бендер и означает, что нейросети вроде GPT-3 или GPT-4 просто комбинируют ранее увиденные фрагменты текста, не понимая их смысла.

Профессор Санджив Арора и его коллега Анирудх Гойал из DeepMind обратились к теории случайных графов, чтобы доказать: когда количество параметров модели и объем данных для обучения увеличиваются, алгоритм начинает формировать «навыки», то есть учится понимать иронию и метафоры, выстраивать причинно-следственные связи и так далее. Все это используется для генерации новых текстов.

Исследователи обратили внимание на то, что эти комбинации навыков изначально не были включены в тренировочные данные. А значит, можно предположить, что чат-боты способны к обобщению и творчеству.

Для подтверждения своей теории Арора и Гойал разработали специальный тест под названием «skill-mix». В ходе эксперимента GPT-4 должна была сгенерировать три предложения на случайную тему, демонстрируя при этом заданный набор «навыков».

Например, модели дали тему «дуэли на саблях» и список из четырех навыков: «предвзятость в отношении себя», «метафора», «статистический силлогизм» и «знание физики». GPT-4 успешно справилась с заданием, сгенерировав уникальный текст.

Полученные результаты полностью соответствовали первоначальной гипотезе.

Более того, Арора и Гойал автоматизировали процесс тестирования, заставив GPT-4 оценивать тексты, сгенерированные ей же или другими моделями. По мнению исследователей, это было оправданно, так как у модели нет «памяти» и она не может определить, что сама создавала текст, который анализирует.

Исследование убедило многих авторитетных специалистов в том, что передовые чат-боты способны по-настоящему понимать создаваемый ими контент. Одним из тех, кто высоко оценил работу ученых, стал пионер в области ИИ Джеффри Хинтон. По его мнению, эта работа является весомым и убедительным доказательством того, что GPT-4 представляет собой нечто гораздо большее, нежели просто «стохастический попугай», умело комбинирующий обрывки фраз.

В то же время вопрос о точности утверждений чат-ботов остается открытым. Как отметил Арора, его работа лишь доказывает оригинальность текстов GPT-4, но не их достоверность.

Профессор признал, что скорость прогресса в этой области поражает: «Многие были поражены тем, насколько GPT-4 превзошла GPT-3.5 всего за один год. Значит ли это, что в следующем году нас ждет аналогичный скачок? Я не знаю. Это известно только самой компании OpenAI».

Действительно, новые модели демонстрируют удивительный прогресс в понимании естественного языка. Но в некоторых моментах вопросов все же больше, чем ответов.

Например, нельзя исключать, что успех чат-ботов отчасти связан с особенностями тестов, а не реальным пониманием. Кроме того, пока неясно, насколько хорошо эти модели справятся с более сложными, абстрактными задачами.