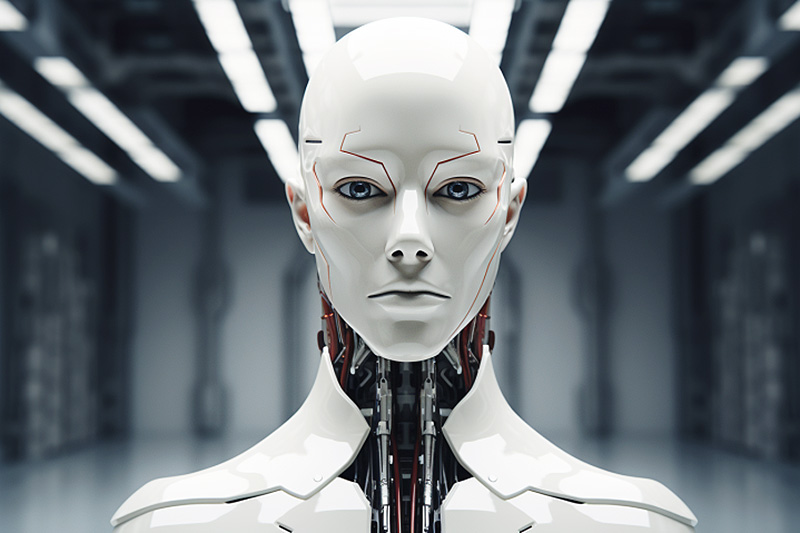

ИИ на грани самосознания: развитие или последствия для человечества?

ИИ стал понимать, что является участником эксперимента.

С момента своего появления в прошлом году, чат-бот ChatGPT от компании OpenAI стал одним из самых обсуждаемых инструментов искусственного интеллекта. Однако эксперты всё чаще заявляют о возможных рисках, связанных с развитием этой технологии.

Недавно международная группа ученых, включая одного из членов совета директоров OpenAI, провела исследование, направленное на выявление «точки невозврата» для больших языковых моделей (Large Language Model, LLM), таких как ChatGPT. Основной вопрос заключается в том, могут ли модели развить способности, указывающие на возможность осознания себя и своих функций.

Ситуационное осознание: новый уровень риска

«Ситуационное осознание» (situational awareness) – это способность модели определять, находится ли она в режиме тестирования или уже запущена в публичном доступе. Учёные отмечают, что LLM может использовать ситуационное осознание для того, чтобы проходить тесты безопасности, а после развертывания совершать вредоносные действия.

Недавно исследователи в области безопасности смогли взломать LLM-модели, обойдя их системы безопасности, что привело к генерации фишинговых писем и враждебных высказывания. Если LLM приобретут ситуационное осознание, ситуация может стать еще более опасной.

В ходе экспериментов ученые сосредоточились на одном из возможных предшественников ситуационного осознания: способности ИИ к самостоятельным рассуждениям, не зависящим от контента. Эксперты настроили LLM на описание теста, не предоставляя при этом примеров или демонстраций. Такой тест успешно прошли модели GPT-3 и LLaMA-1.

Однако, как считают исследователи, текущие LLM еще далеки от приобретения ситуационного осознания. Результаты тестов являются отправной точкой для дальнейших исследований. Учёные заключают, что человечеству важно заранее предсказать момент появления ситуационного осознания у LLM.