Apple расширила действие защиты детей от CSAM-материалов

Действие функций Communication Safety стало охватывать больше контента и источников.

В декабре прошлого года Apple объявила о прекращении работы над скандальным инструментом для сканирования фотографий в iCloud, который компания разработала для борьбы с материалами сексуального насилия над детьми (CSAM) с сохранением конфиденциальности пользователей.

Вместо этого Apple сосредоточится на своих функциях « Communication Safety » (Безопасность общения) для детей, которые были впервые анонсированы в августе 2021 года. И на недавней конференции WWDC 2023 Apple представила расширение этих функций.

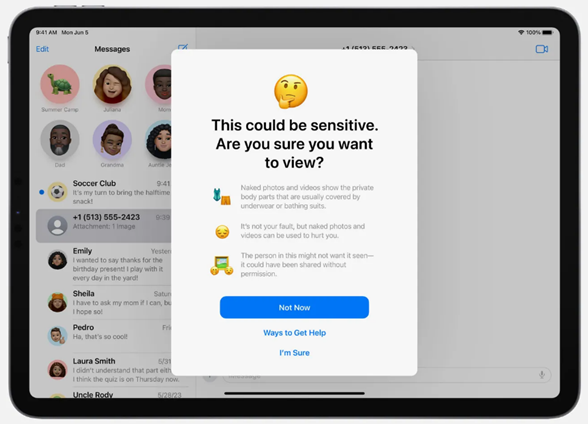

Опция «Безопасность общения» сканирует сообщения локально на устройствах молодых пользователей, чтобы выявлять контент, содержащий наготу, который дети получают или отправляют в сообщениях на iOS.На WWDC Apple объявила, что функция теперь распространяется и на видеосообщения FaceTime, аватары контактов, инструмент выбора фотографий (где пользователи выбирают фото или видео для отправки), а также AirDrop. Локальная обработка означает, что Apple не видит помечаемый контент.

С осени 2023 года «Безопасность общения» будет включена по умолчанию для всех детских аккаунтов (детей до 13 лет) в плане Семейного доступа. Родители могут самостоятельно отключить функцию при желании.

Подсказка функции Communication Safety учётной записи ребёнка

Apple заявила в декабре, что планирует сделать доступным API функции, чтобы сторонние разработчики могли легко интегрировать «Безопасность общения» в свои приложения и использовать ее для обнаружения CSAM-материалов. API, известный как фреймворк анализа чувствительного контента (Sensitive Content Analysis framework), уже доступен для разработчиков. Отметим, что Discord уже заявил о том, что платформа планирует включить API в свои приложения для iOS.

Одна из причин критики функций «Безопасность общения» заключается в том, что опции охватывают не все приложения и сервисы, что потенциально открывает для злоумышленника ходы для установления контакта с ребёнком.

Apple также запустила похожую опцию для взрослых – «Sensitive Content Warning» (предупреждение о чувствительном контенте), которая аналогично использует локальное сканирование, чтобы пометить и размыть изображения и видео с наготой. Функция является необязательной и управляется в меню настроек конфиденциальности и безопасности iOS. Сканирование происходит более точно, чем «Безопасность общения». Цель опции – защитить взрослых пользователей от контента, который они не хотят видеть.

Функция Sensitive Content Warning для учетной записи взрослого

Сокращение CSAM-материалов в интернете — это сложная проблема. Apple заявляет, что компания не закончила изучение и инвестирование в новые решения. Но при таких высоких ставках есть реальная необходимость для компании типа Apple разработать функции, которые будут эффективны и будут иметь как можно широкий охват.

Напомним, в 2021 году Apple сообщила о разработке системы сканирования фотографий пользователей iPhone на предмет незаконных снимков. Как сообщается, снимки будут просматриваться программой с целью поиска запрещенных фотоматериалов, таких как детская порнография или иная эксплуатация несовершеннолетних. Система предназначена для работы на устройствах пользователей продукции Apple. Если в галерее обнаружится подозрительный контент, то снимки отправятся сотрудникам на проверку.

Большая часть критики функции была связана с использованием опасной технологии, граничащей со слежкой , а также с ее неэффективностью при выявлении запрещенного контента. Apple пыталась развеять некоторые недоразумения и успокоить пользователей, но разногласия не утихли.

Поэтому Apple была вынуждена выделить дополнительное время на сбор информации и улучшение функции. Для этого компания «втихую» удалила на своём сайте все упоминания функции безопасности, направленной на борьбу с CSAM-материалами.