Google скрывает свой секретный соус: что за PaLM 2?

Компания анонсировала свою новую языковую модель, которая используется в 25 продуктах, но не раскрывает ни количество параметров, ни источники данных, на которых она обучена.

В среду Google представила PaLM 2 - семейство основных языковых моделей (LLM), которые по своим возможностям сопоставимы с GPT-4 от OpenAI. На своем мероприятии Google I/O в Маунтин-Вью, Калифорния, Google сообщила, что уже использует PaLM 2 для работы 25 продуктов, включая свой разговорный AI-ассистент Bard.

PaLM 2 - семейство больших языковых моделей (LLM), которые были обучены на огромном объеме данных и умеют предсказывать следующее слово после ввода человеком. PaLM - аббревиатура от "Pathways Language Model", а "Pathways" - техника машинного обучения, созданная в Google. PaLM 2 является продолжением оригинальной PaLM, которую Google анонсировала в апреле 2022 года.

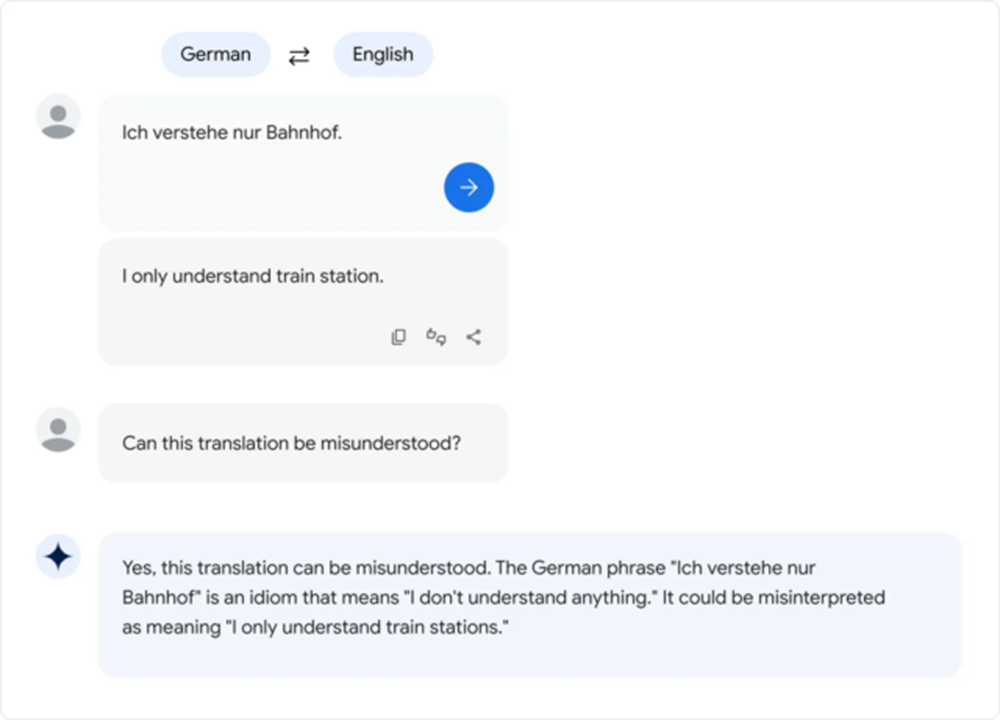

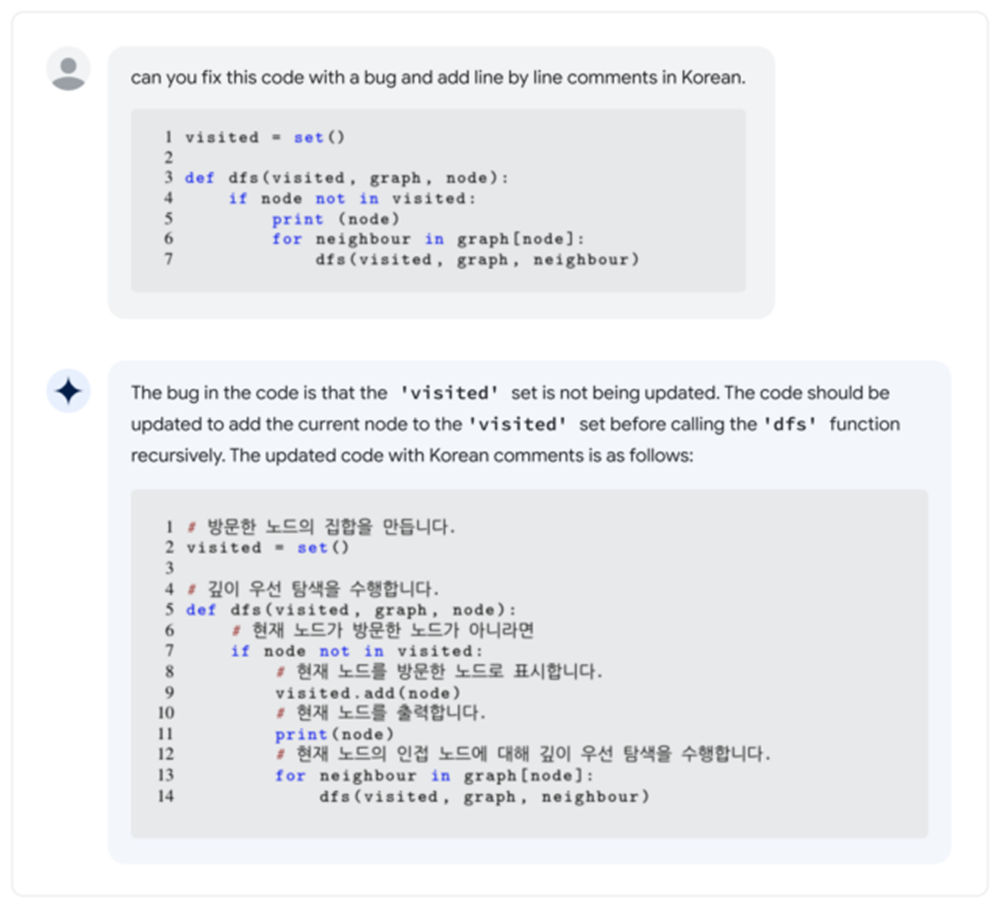

По словам Google, PaLM 2 поддерживает более 100 языков и может выполнять "рассуждения", генерацию кода и мультиязычный перевод. Во время своего выступления на Google I/O генеральный директор Google Сундар Пичаи сказал, что PaLM 2 имеет четыре размера: Gecko, Otter, Bison, Unicorn. Gecko - самый маленький и может работать на мобильном устройстве. Кроме Bard, PaLM 2 лежит в основе AI-функций в документах, таблицах и слайдах.

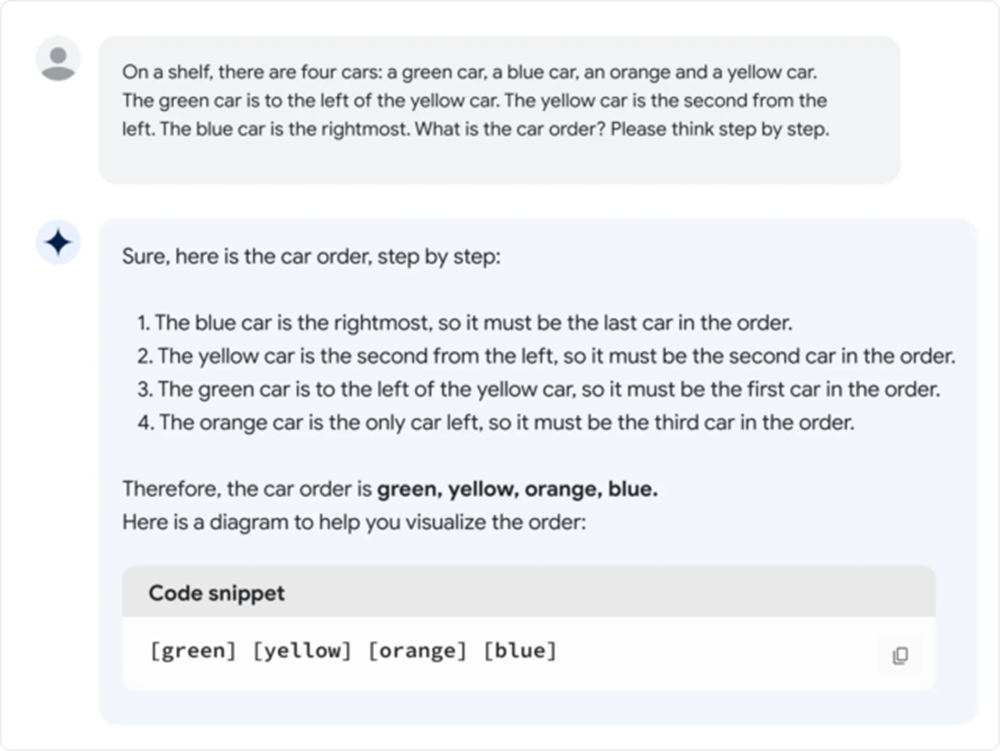

Предоставленный Google пример «рассуждения» PaLM 2.

Но как PaLM 2 соотносится с GPT-4? В техническом отчете о PaLM 2 говорится, что PaLM 2 превосходит GPT-4 в некоторых математических, переводческих и логических задачах. Но реальность может не соответствовать бенчмаркам Google. В краткой оценке версии PaLM 2 для Bard Этан Моллик, профессор Уортона, который часто пишет об AI, обнаружил, что производительность PaLM 2 выглядит хуже, чем у GPT-4 и Bing по различным неформальным языковым тестам, которые он подробно описал в твиттере.

До недавнего времени семейство языковых моделей PaLM было внутренним продуктом Google Research без доступа для потребителей, но Google начала предоставлять ограниченный доступ к API в марте. Тем не менее, первая PaLM была заметна своим огромным размером: 540 миллиардов параметров. Параметры — это числовые переменные, которые служат как изученные "знания" модели, позволяющие ей делать прогнозы и генерировать текст на основе получаемого от нее ввода.

Предоставленный Google пример языка перевода PaLM 2.

Больше параметров примерно означает больше сложности, но нет гарантии того, что они используются эффективно. Для сравнения: GPT-3 от OpenAI (из 2020 года) имеет 175 миллиардов параметров. OpenAI никогда не раскрывала количество параметров в GPT-4.

Подобный подход приводит к большому вопросу: насколько "большой" PaLM 2 в плане количества параметров? Google не называет цифры, что разочаровало некоторых экспертов по отрасли, которые часто выступают за большую прозрачность в том, что заставляет AI-модели работать.

Google молчит не только о количестве параметров. Компания говорит, что PaLM 2 была обучена на "разнообразном наборе источников: веб-документах, книгах, коде, математике и разговорных данных", но не уточняет, о каких данных идет речь.

Как и другие наборы данных для больших языковых моделей, набор данных PaLM 2, вероятно, включает в себя широкий спектр авторских материалов, использованных без разрешения, и потенциально вредных материалов, собранных из Интернета. Обучающие данные решающим образом влияют на вывод любой AI-модели, поэтому некоторые эксперты выступают за использование открытых наборов данных, которые могут предоставить возможности для научной воспроизводимости и этического анализа.

Предоставленный Google пример написания программного кода на PaLM 2.

"Теперь, когда LLM стали продуктами (а не просто исследованиями), мы находимся на поворотном пункте: коммерческие компании станут все менее и менее прозрачными *именно* по поводу компонентов, которые наиболее важны", - написал в твиттере Джесси Додж, научный сотрудник Института AI Аллена. "Только если сообщество открытого исходного кода сможет объединиться, мы сможем держаться наравне!"

Пока критика за скрытие своего секретного соуса не остановила Google от широкого внедрения AI-моделей, несмотря на тенденцию всех LLM просто выдумывать вещи из воздуха. Во время Google I/O представители компании продемонстрировали AI-функции во многих своих основных продуктах, что означает, что широкий круг публики может скоро столкнуться с AI-выдумками.

И что касается LLM, PaLM 2 - это далеко не конец истории: в ключевой речи на I/O Пичаи упомянул, что новая мультимодальная AI-модель под названием "Gemini" сейчас находится в процессе обучения. Пока продолжается гонка за AI-гегемонией, пользователи Google в США и 180 других странах (загадочным образом исключая Канаду и континентальную Европу) могут попробовать PaLM 2 сами как часть Google Bard - экспериментального AI-ассистента.