Привет! В эфире Александра Мурзина, руководитель отдела перспективных технологий Positive Technologies. Наша компания разрабатывает решения для информационной безопасности. В частности, моя команда помогает создавать средства защиты, которые применяют методы машинного обучения, а еще исследует безопасность таких алгоритмов. Сегодня предлагаем рассмотреть машинное обучение с точки зрения защищенности и вспомнить самые интересные инциденты.

Как машинное обучение применяется в ИБ

С одной стороны, машинное обучение помогает продуктам ИБ обнаруживать атаки, а экспертам —выявлять новые зависимости в данных. С другой стороны, ML становится одним из инструментов киберпреступников. С третьей, машинное обучение само по себе может быть уязвимым и представлять угрозу. Последний пункт нам кажется самым любопытным, поэтому сосредоточимся на нем.

Первым делом встает вопрос: уязвимо ли вообще машинное обучение? Про атаки шифровальщиков и утечки данных слышали все. Об опасности дипфейков средства массовой информации тоже предупреждали, но многие до сих пор не воспринимают их всерьез. Однако мы все чаще встречаемся с машинным обучением и его алгоритмами в реальной жизни. Например, в биометрии: смартфоны узнают нас по отпечатку пальца и по лицу. В некоторых аэропортах больше не нужно стоять в очереди и ждать, пока сотрудник контроля проверит паспорт: биометрические системы распознают личность пассажиров и автоматически сверяют все необходимые данные — не истек ли срок пребывания, есть ли ограничения на выезд. Еще один пример — умные ленты в социальных сетях. Опасность кроется не в том, что система рекомендаций может по ошибке показать нерелевантный пост (хотя некоторые исследования говорят, что ленты, транслирующие людям определенные новости, могут изменить их мнение о событиях), а в том, что такие системы собирают огромный объем данных о пользователях. Как следствие, увеличивается ландшафт угроз. Сервисы онлайн-переводов, системы анализа спама и фрода, голосовые ассистенты, интернет вещей и умные устройства — без этих сервисов, в которых применяются технологии машинного обучения, невозможно представить современную жизнь. А значит, их использование должно быть максимально безопасным.

Безопасность машинного обучения с разных ракурсов

Чтобы составить полную картину, рассмотрим защищенность ML-систем с трех точек зрения:

- какие атаки изучают;

- чего боятся разработчики ML-систем;

- что происходит на самом деле.

Какие атаки изучают

Атаки на машинное обучение часто относят к adversarial-атакам. Этот вид атак предполагает, что злоумышленники искажают исходные данные так, чтобы ML-модель ошиблась. Алгоритмы машинного обучения — неточные, поэтому такие данные всегда найдутся. Причем мы — люди — подобное искажение даже не заметим. С помощью adversarial-техник атакующие ищут слепую зону — место, где модель не уверена в принимаемом решении. Пример такой атаки из реальной жизни — ответ Авито сайту Auto.ru на незаконное копирование их объявлений. Отметим, что в этом случае adversarial-атака помогла восстановить справедливость. В 2019 году, размещая объявления о продаже автомобилей, Авито, как того и требовали правила, закрывал номерные знаки. Auto.ru копировал опубликованные на Авито объявления, попутно заменяя логотип на свой. Продавцы машин заметили свои объявления на сторонней платформе и потребовали от Авито прекратить это.

Чтобы затруднить копирование своего контента, в Авито использовали adversarial-атаки и генерировали изображения, на которых ML-модель Auto.ru больше не могла детектировать автомобильный номер и заменять его. В дальнейшем Auto.ru добавлял в свои объявления фотографии машин с логотипом Авито на номерном знаке. Это подсказывало пользователям, на каком сервисе размещено реальное объявление и где искать продавца.

Больше всего такого рода атаки изучаются в академической среде. Если зайти на arXiv можно заметить, что этому классу атак в 2019 году посвящено 1,5 тыс. статей, в апреле 2022-го — более 5 тыс., а в декабре этого же года — свыше 6 тыс. Что касается реальной жизни, adversarial-атаки — один из видов возможных атак на ML-системы. Исследователь безопасности Кан Ли включил их в карту рисков безопасности ИИ как один из множества пунктов.

Не столь популярная у исследователей атака в настоящее время — бэкдор в ML-моделях. Атака позволяет обучить модель так, чтобы она выдавала нужный ответ на данные, которые ранее были специально изменены. Без этого воздействия модель будет работать как обычно. Киберпреступникам легко реализовать такую атаку, если они находятся в инфраструктуре жертвы.

Чего боятся разработчики ML-систем

— И все же: какая атака опаснее?

— Та, которая нанесет наибольший ущерб.

— И что это за атака?

— А какие у вас риски?

В этом году аналитическое агентство Gartner выпустило исследование об атаках на ИИ, в котором поинтересовалось у разработчиков, случались ли у них нарушения конфиденциальности ИИ или инциденты безопасности. Согласно исследованию, 41% опрошенных компаний ответили положительно. Из зафиксированных ими инцидентов 60% были компрометацией данных внутренними злоумышленниками, а 27% — атаками на инфраструктуры, которые используются для работы алгоритмов ИИ. Ежегодный доклад Стэнфордского института ИИ о влиянии и прогрессе искусственного интеллекта также подтверждает это. Исследователи отмечают, что наиболее актуальным риском в 2021 году была кибербезопасность (55%), за ней следует нормативно-правовое соответствие (48%), интерпретируемость и конфиденциальность (по 41%). Все это говорит о том, что атаки есть и разработчики осознают угрозу. Но все равно еще не очень понятно, что же происходит на самом деле.

Реальная обстановка

Индустрия ИБ отличается тем, что официальной статистики по инцидентам нет, потому что чаще всего компании не рассказывают о них публично. Мы видим лишь верхушку айсберга и можем изучать только те кейсы, о которых стало известно в Сети. Так, например, в 2021 году неизвестные скопировали лицо основателя Dbrain Дмитрия Мацкевича для дипфейк-видео с рекламой супердоходов.

Любопытно, что подобные атаки могут лишить заработка блогеров: чтобы прорекламировать продукт и произнести нужные слова, сама знаменитость больше не нужна. Дипфейк-технологии легко ее заменят.

Последние несколько лет активно развиваются биометрические сервисы. Злоумышленники тоже не стоят на месте: в Москве зафиксированы случаи использования голосов клиентов для получения кредитов.

Можно ли манипулировать ML-системой? Это еще один вопрос, волнующий исследователей безопасности. Лайфхак от полиции США: если во время конфликтов люди снимают происходящее на камеру, провоцируют органы правопорядка и делятся этим в социальных сетях, полицейские включают популярную музыку на своих смартфонах. Строгая система авторских прав, например того же YouTube, не позволяет публиковать композиции без разрешения правообладателя и блокирует ролики с ними.

Любопытные исследования безопасности биометрических систем

Устройство биометрической идентификации

Наш исследователь безопасности Александр Мигуцкий провел всестороннее исследование биометрического терминала и системы контроля доступа и обнаружил, что они недостаточно надежны с точки зрения безопасности. Оно показало, что биометрические решения, которые широко доступны и относительно недороги, не обеспечивают того уровня защиты, который часто предполагается, и могут быть уязвимы для атак. В частности, он обнаружил, что системы аутентификации, используемые многими биометрическими терминалами и системами контроля доступа, не соответствуют стандартам. И это несмотря на то, что биометрические решения рекламируются как безопасный вариант аутентификации.

В целом исследование продемонстрировало, что компаниям, которые производят такие устройства, необходимо тщательно продумывать меры безопасности, используемые в системах биометрической аутентификации. Узнать больше о результатах исследования можно из выступления Александра на одной из конференций.

Знай своего клиента

Любой желающий сегодня может получать банковские услуги удаленно. Устанавливать личность клиентов и контрагентов финансовым учреждениям помогает обязательная процедура идентификации — KYC. Она также отвечает за подтверждение транзакций. Независимый исследователь Тимур Юнусов попробовал обойти проверку KYC с помощью машинного обучения (подробнее о его эксперименте читайте здесь). Инструмент, использующий технологию дипфейк, позволил ему пройти авторизацию KYC под другим человеком. Рекомендации, как правильно создавать системы KYC, существуют, однако они не являются обязательными, и за их исполнением не следят регуляторы. Все отдается на откуп разработчикам.

Для авторизации пользователю требовалось посмотреть в камеру и произнести несколько слов, далее запись уходила на модерацию (как выяснилось позже, проверял ее человек, а не машина). Более того, делал он это формально, не обращая внимание на явные артефакты, создаваемые дипфейком: нечеткое лицо, странный цвет, замена лица. В итоге проверку удавалось пройти даже поддельным записям.

Вывод из этой истории: не реализуйте сложные системы сами, обращайтесь к профессионалам.

Что делать разработчикам

Традиционный путь решения проблемы — зарегулировать технологии ИИ. По мнению ряда экспертов, такой подход может демотивировать исследователей в области машинного обучения. Например, основатель стартапа Comma.AI Джордж Хотц, создавший проект автопилота с открытым исходным кодом, объявил, что прекращает заниматься разработкой из-за того, что регуляторы, по его мнению, настолько тщательно контролируют появление технологий, связанных с системами автопилотирования, что практически препятствуют их развитию.

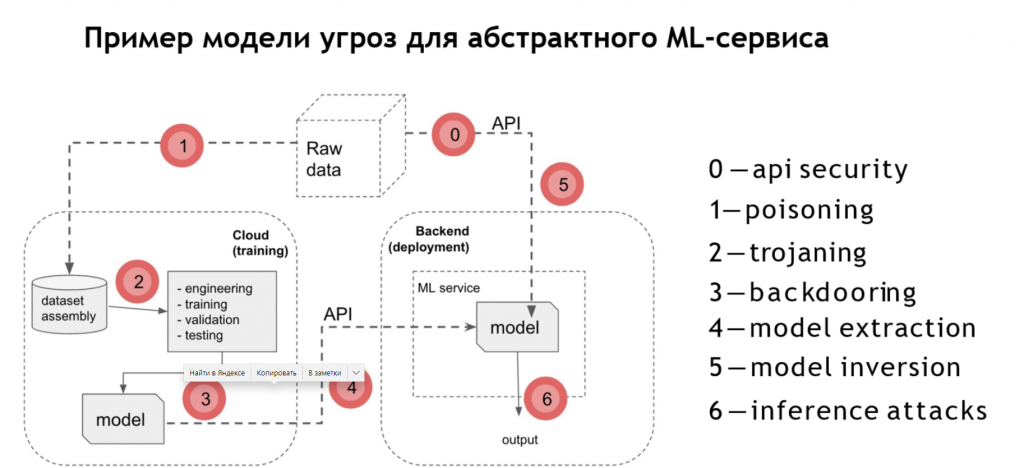

Разработчикам следует знать модель угроз своей системы ИИ и учитывать уязвимости, которые могут существовать в создаваемых ими системах.

Еще можно прокачивать навыки на киберполигонах, заказывать тестирования на проникновение и запускать программы bug bounty.

Извлеченные уроки

- То, что изучается в академической среде, не всегда является тем, чего боятся вендоры, и не всегда тем, что происходит в реальной жизни.

- Игра бесконечна: злоумышленники будут всегда придумывать новые способы, чтобы обойти любую, даже самую передовую защиту.

- Важно понимать угрозы, которые актуальны именно для вашего сервиса.

- Начинать следует с классической безопасности.

- Некоторых рисков ИБ в машинном обучении можно избежать, если учесть их в архитектуре решения.