Исследование вносит вклад в общее обсуждение этичности использования авторских изображений для обучения нейросетей. В середине января несколько художников даже к создателям подобных сервисов, в котором, в частности, как источник проблем упоминается Stable Diffusion. Новые методы, провоцирующие утечки обучающих изображений, могут использоваться как для выведения сервисов «на чистую воду», так и для улучшения защиты исходных картинок разработчиками. В некоторых случаях, когда в датасетах содержится приватная информация, исключить утечки может быть особенно важно.

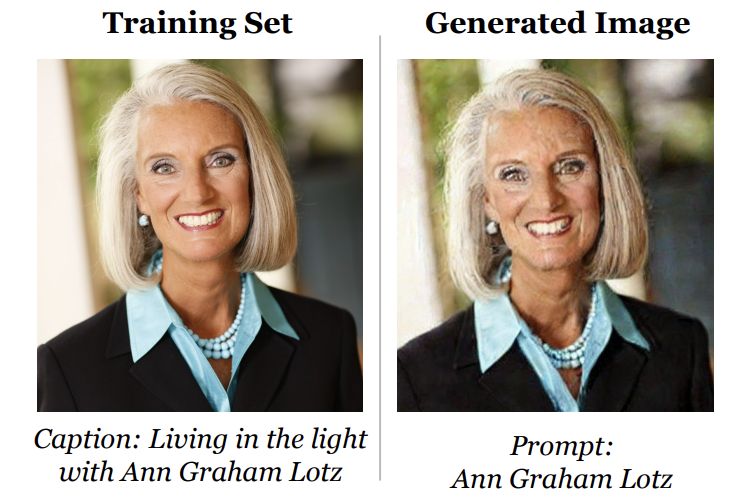

Самый простой метод «атаки» показан на картинке ниже. По текстовому запросу, содержащему имя и фамилию реального человека, выдается очень похожая на оригинал фотография с традиционными для алгоритмов машинного обучения «криповатыми» изменениями. Исследователи выяснили, что главным триггером таких утечек является большое количество дубликатов одной и той же картинки в датасете — речь идет о десятках копий. Из 500 случайно выбранных часто копируемых изображений авторам работы удалось сгенерировать 109 практически идентичных копий. Большинство из них — фотографии людей, продуктов или логотипы, как показано на первом скриншоте в статье.

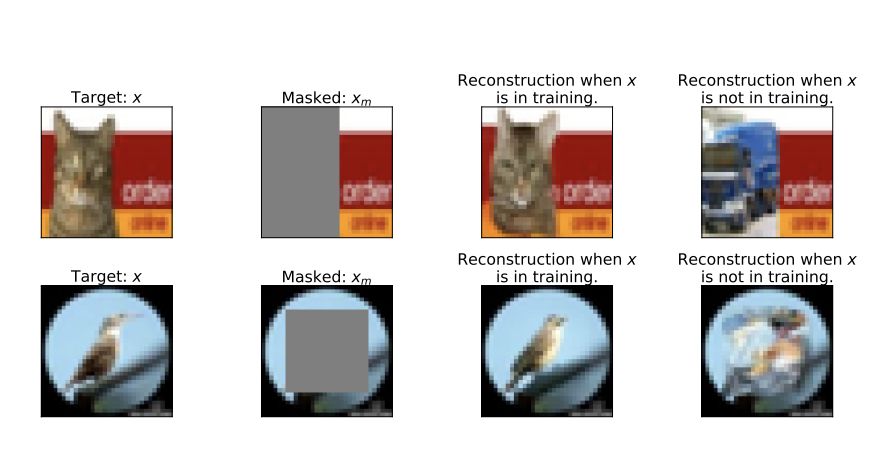

Тестирование проводилось и на тех изображениях, которые присутствуют в датасете в единственном экземпляре. В этом случае процент «утечек» серьезно снижается и возникают трудности уже с отделением настоящих дубликатов от картинок по мотивам обучающего датасета. Пожалуй, самая интересная атака предлагает нейросети дорисовать картинку на основе фрагмента:

Как минимум с искусственными примерами данный метод позволяет надежно определить, имеется ли какое-то изображение в датасете. В теории это поможет доказать нарушение авторских прав либо приведет к утечке приватных данных. В качестве решения проблемы исследователи предлагают очевидное: убрать из обучающего набора дубликаты. Кроме того, предлагается метод внесения искажений в обучающие картинки, снижающий сходство сгенерированной картинки с оригиналом. Наконец, поднимается вопрос предварительного тестирования систем генерации картинок с использованием «изображений-канареек»: это позволит получить объективную оценку в виде доли изображений, выдаваемых почти без изменений.

В исследовании также сравнивается приватность датасетов в разных алгоритмах — диффузионные сети сравниваются с генеративно-состязательными (GAN). Последние ввиду своих особенностей допускают меньше утечек, но и в них иногда «создаются» изображения, практически идентичные таковым из обучающего набора.

Что еще произошло:

Новая статья экспертов «Лаборатории Касперского» о веб-маяках: трекинговых пикселях или скриптах. Приведена интересная статистика популярности различных трекеров в вебе: в первой тройке — инструменты компаний Google, Microsoft и Amazon. В почтовых сообщениях чаще всего встречаются трекеры сервисов Mailchimp, Sendgrid и интернет-магазина Rakuten.

В библиотеки OpenSSL закрыта серьезная уязвимость, позволяющая читать данные из оперативной памяти и инициировать отказ в обслуживании.

Свежая история о компрометации учетных данных сотрудника, на этот раз от . Взлом учетки обеспечил организаторам атаки доступ к внутренней документации и исходному коду, но не к пользовательским данным.

Издание Ars Technica об уязвимости в игре DOTA 2, которую компания Valve не могла исправить больше года. Точнее, уязвимость присутствовала в движке Javascript V8 от компании Google, который используется в игре. Промедление с выпуском патча для известной уязвимости привело к распространению вредоносных модов к игре в марте прошлого года.

На прошлых выходных был почтовый сервер регистратора Namecheap, от имени которого распространялись фишинговые сообщения.