CVE‑2017‑11176: Пошаговая эксплуатация уязвимости ядра в Linux (часть 3)

Эта статья начнется с рассмотрения подсистемы памяти и SLAB аллокатора.

Автор: Lexfo

Во второй части в качестве замены скриптам для System Tap был реализован концептуальный код, активирующий уязвимость из пространства пользователя.

Эта статья начнется с рассмотрения подсистемы памяти и SLAB аллокатора. Данные темы настолько обширны, что мы настоятельно рекомендуем ознакомиться с дополнительной информацией в других источниках. Ознакомление с этими темами абсолютно обязательно при разработке любого эксплоита как на базе уязвимостей типа use‑after‑free, так и связанных с переполнением кучи.

Однако базовая теория, касающаяся use‑after‑free будет объяснена, а также рассмотрены методы сбора информации, которая потребуется для эксплуатации подобного рода проблем. Затем мы будем применять полученные знания для конкретно нашего случая и, в частности, будем анализировать доступные примитивы. Также будет рассмотрена стратегия переразмещения, которая будет использоваться для «преобразования» use-after-free в примитив произвольного вызова. В итоге, наш эксплоит будет вызывать панику ядра управляемым образом (больше никаких случайных крахов).

Техники, рассматриваемые в этой статье, пригодны для эксплуатации любых ошибок типа use‑after‑free в ядре Линукса (через конфликт типов). Более того, эксплуатация use‑after‑free происходит при помощи произвольного вызова. Поскольку будет использоваться специфический код, эксплоит нельзя считать ни универсальным, ни заточенным на обход защиты kASLR (Рандомизация размещения адресного пространства в ядре).

Ту же самую уязвимость можно эксплуатировать различными способами для получения других примитивов (для произвольного чтения/записи) и обхода kaslr/smap/smep (в четвертой части будет рассмотрен обход smep). Имея на руках концептуальный код, вы сможете продолжить развитие своей креативности на поприще создания эксплоитов.

Стоит отметить, что эксплоиты уровня ядра запускаются в очень хаотичной среде. В предыдущих статьях сей факт нас не очень затрагивал, но теперь будет. Если говорить более конкретно, то речь идет о переразмещении (reallocation). То есть, если возникнет причина, по которой ваш эксплоит «сломается» (поскольку вы проиграли гонку), то с высокой степенью вероятности из-за переразмещения. Надежное переразмещение – это непаханое поле для исследований, а более сложные трюки не будут рассматриваться в этой статье.

Кроме того, поскольку сейчас будет иметь значение компоновка структур данных, которая отличается в отладочной и рабочей версии ядра, мы говорим «до свидания» System Tap, поскольку этот инструмент не будет работать ядре, скомпилированным для рабочих сред. Более того, следует упомянуть о том, что ваша компоновка структур во многом будет отличаться от наших, и код эксплоита, представленного в этой статье, в вашей системе без дополнительных изменений работать не будет.

Приступаем к форсированию (множества) крахов. Здесь и начинается самое веселье J.

Базовые концепции #3

В третьей части в разделе «Базовые концепции» мы рассмотрим подсистему памяти (также называемую «mm»), которая настолько огромна, что существуют целые книги, посвященные этой части ядра. Поскольку в этом разделе мы рассмотрим лишь малую часть, рекомендуется изучить дополнительные источники, указанные ниже. Тем не менее, мы коснемся базовых структур данных ядра, которые используются для управления памятью, чтобы вы были в курсе дела хотя бы примерно:

Understanding the Linux Kernel (главы 2,8,9)

Как минимум, рекомендуем почитать главу 8 книги «Understanding The Linux Virtual Memory Manager».

В конце этого раздела будет рассмотрен макрос container_of() и использование дважды связанного циклического списка в ядре. Также будет показан пример, чтобы вы поняли суть работы макроса list_for_each_entry_safe(), что является обязательным при разработке эксплоитов.

Управление страницами физической памяти

Одна из наиболее важных задач любой операционной системы – управление памятью, которое должно быть быстрым, безопасным, стабильным и минимизировать фрагментирование. К сожалению, большинство этих задач противоречат друг другу (например, излишняя безопасность часто влияет на производительность). Чтобы повысить эффективность, физическая память разделяется на непрерывные блоки фиксированной длины. Каждый такой блок, также называемый фреймом страницы, имеет (в основном) фиксированный размер 4096 байт, который может быть извлечен при помощи макроса PAGE_SIZE.

Поскольку ядро обрабатывает память, то должно и следить за каждым фреймом физической памяти, в том числе и за информацией, касающейся фреймов. Например, ядро должно знать, является ли фрейм страницы доступным для использования. Подобная информация хранится в структуре данных page, которая также называется дескриптором страницы.

Ядро может запрашивать одну или несколько смежных страниц, используя функцию alloc_pages(), а также может освобождать страницы при помощи функции free_pages(). За обработку этих запросов отвечает аллокатор, который называется зонированным аллокатором фреймов страницы (Zoned Page Frame Allocator). Поскольку этот аллокатор использует алгоритм Buddy system algorithm, то часто называется Buddy аллокатором.

Slab аллокаторы

Степень детализации, которую дает buddy аллокатор не всегда уместна. Например, если надо выделить только 128 байт памяти, ядро может запросить страницу, но тогда 3968 байт памяти будут израсходованы впустую. Этот эффект называется внутренней фрагментацией. Чтобы решить данную проблему, в Линуксе предусмотрены Slab аллокаторы, которые дают большую детализацию. Грубо говоря, рассматривайте Slab аллокатор как эквивалент функций malloc() / free() для ядра.

В ядре Линукса есть три различных Slab аллокатора (но используется только один):

SLAB аллокатор: самая первая версия этой линейки аллокаторов, которая предназначена для оптимизации аппаратного кэша (до сих пор используется в Debian).

SLUB аллокатор: «новый» стандартный аллокатор, появившийся в 2007 году (используется в Ubuntu/CentOS/Android).

SLOB аллокатор: разработан для встроенных систем с небольшим объемом памяти.

Примечание: мы будем придерживаться следующего соглашения об именах: Slab - обобщает все три аллокатора (SLAB, SLUB, SLOB) как класс. SLAB (все буквы в верхнем регистре) – один из трех аллокаторов, а slab – объект, используемый Slab аллокаторами.

Мы не сможем рассмотреть все Slab аллокаторы, а только один SLAB аллокатор, который хорошо задокументирован и к тому же используется в целевой системе. SLUB аллокатор на данный момент более распространен, но плохо задокументирован. Однако мы считаем, что со SLUB аллокатором проще разобраться, поскольку там нет «раскрашивания кэша» (cache coloring), не отслеживается «полный slab», отсутствует управление внутренним/внешним slab и т. д. Чтобы узнать, какой из трех аллокаторов используется в вашей системе, введите следующую команду:

$ grep "CONFIG_SL.B=" /boot/config-$(uname -r)

Часть, связанная с переразмещением, будем изменяться в зависимости от используемого Slab аллокатора. Несмотря на то, что SLAB аллокатор более сложен для понимания, но более прост (по сравнению со SLUB) для эксплуатации ошибки use-after-free. С другой стороны, у SLUB аллокатора есть другое преимущество: slab aliasing (т.е. большинство объектов хранятся в kmemcache «общего назначения»).

Кэш и slab

Поскольку ядро имеет тенденцию повторно размещать объекты одинакового размера, было бы не очень эффективно постоянно запрашивать/освобождать одинаковые страницы в памяти. Чтобы повысить эффективность, Slab аллокатор хранит объект того же размера в кэше (пуле выделенных фреймов памяти). Кэш описывается структурой kmem_cache (также называемой «дескриптором кэша»):

struct kmem_cache {

// ...

unsigned int num; // number of objects per slab

unsigned int gfporder; // logarithm number of contiguous page frames in a slab

const char *name; // name of the cache

int obj_size; // object size in this cache

struct kmem_list3 **nodelists; // holds list of empty/partial/full slabs

struct array_cache *array[NR_CPUS]; // per-cpu cache

};

Объекты сами по себе хранятся в slab’ах, которые представляют собой один или несколько фреймов смежных страниц. Единичный slab может хранить числовые объекты размером obj_size. Например, slab, распределенный по единичной странице (размером 4096 байт), может хранить 4 объекта размером 1024 байта.

Статус единичного slab (например, количество свободных объектов) описывается структурой slab (также называемой «структурой управления slab»):

struct slab {

struct list_head list;

unsigned long colouroff;

void *s_mem; // virtual address of the first object

unsigned int inuse; // number of "used" object in the slab

kmem_bufctl_t free; // the use/free status of each objects

unsigned short nodeid;

};

Структура управления slab может храниться как внутри объекта slab, так и в другом месте памяти. Смысл заключается в том, чтобы уменьшить внешнюю фрагментацию. Место хранения структуры управления slab зависит от размера объекта кэша. Если размер объекта меньше 512 байт, эта структура хранится внутри slab, иначе – в другом участке памяти.

Примечание: поскольку мы эксплуатируем ошибку use-after-free место хранение структуры особого значения не имеет. С другой стороны, если вы эксплуатируете переполнение кучи, тогда место хранения нужно учитывать.

Извлечение виртуального адреса объекта в slab можно сделать через поле s_mem в комбинации со смещениями. Грубо говоря, представьте, что адрес первого объекта – s_mem, второго – s_mem + obj_size, третьего - s_mem + 2* obj_size и так далее. В реальности формула более сложная из-за «окрашивания», которое используется для повышения эффективности аппаратного кэша, однако эта тема выходит за рамки данной статьи.

Обработка slab’ов и взаимодействие с Buddy аллокатором

Когда объект slab создан, Slab аллокатор запрашивает у Buddy аллокатора фреймы страниц. Когда объект slab уничтожается, выделенные страницы возвращаются обратно Buddy аллокатору. В целях повышения эффективности ядро пытается уменьшить количество актов создания/разрушения объектов slab.

Примечание: может возникнуть вопрос, почему поле gfporder структуры kmem_cache представляет собой логарифмическое число фреймов смежных страниц. Причина заключается в том, что Buddy аллокатор работает не с байтовыми размерами, а с «порядком» на базе степени двойки. То есть порядок нуля означает одну страницу, порядок единицы – две смежные страницы, порядок двойки – четыре смежные страницы и так далее.

Для каждого кэша Slab аллокатор хранит три дважды связанных списка объектов slab:

Полные slab’ы: все объекты slab используются (то есть выделены).

Свободные slab’ы: все объекты slab свободны (то есть каждый slab пустой).

Смешанные slab’ы: некоторые объекты используются, некоторые – свободные.

Эти списки хранятся в дескрипторе кэша структуры kmem_cache в поле nodelists. Каждый slab принадлежит одному из этих списков. Объекты slab могут перемещаться между списками во время размещения или освобождения (например, когда размещается последний свободный объект списка со смешанными объектами, этот slab перемещается в список, где хранятся полные объекты).

Чтобы сократить интенсивность взаимодействий с Buddy аллокатором, SLAB аллокатор хранит пул нескольких объектов, которые хранятся в свободном и смешанном списках. При размещении объекта, аллокатор пытается найти свободный объект в этих списках. Если все slab’ы полные, Slab аллокатор должен создать новый объект, сделав запрос к Buddy аллокатору на дополнительные страницы. Эта операция называется cache_grow(). С другой стороны, если Slab имеет «очень много» свободных slab’ов, некоторые объекты разрушаются, и страницы возвращаются обратно Buddy аллокатору.

По-процессорная (per-cpu) структура данных array_cache

В предыдущем разделе было рассмотрено, что во время размещения Slab должен просканировать списки свободных и смешанных slab’ов. Поиск свободного слота при помощи сканирования списков – не очень эффективная операция (например, списки доступа требуют блокировки, нужно искать смещение в slab и так далее).

Чтобы улучшить производительность, Slab хранит массив указателей на свободные объекты. Этот массив представляет собой структуру данных array_cache и хранится в поле array структуры kmem_cache.

struct array_cache {

unsigned int avail; // number of pointers available AND index to the first free slot

unsigned int limit; // maximum number of pointers

unsigned int batchcount;

unsigned int touched;

spinlock_t lock;

void *entry[]; // the actual pointers array

};

Сам по себе массив array_cache используется как структура данных, работающая по принципу LIFO (Last‑In First‑Out; Последним пришел, первым вышел), то есть как стек. Для эксплуататора уязвимости эта тема очень на руку. Именно из-за принципа LIFOэксплуатировать ошибки use‑after‑free проще в SLAB, чем в SLUB.

В случае отработки кода наибыстрейшим образом выделение памяти будет выглядеть так:

static inline void *____cache_alloc(struct kmem_cache *cachep, gfp_t flags) // yes... four "_"

{

void *objp;

struct array_cache *ac;

ac = cpu_cache_get(cachep);

if (likely(ac->avail)) {

STATS_INC_ALLOCHIT(cachep);

ac->touched = 1;

objp = ac->entry[--ac->avail]; // <-----

}

// ... cut ...

return objp;

}

Наибыстрейший сценарий отработки кода, связанного с освобождением объекта, выглядит так:

static inline void __cache_free(struct kmem_cache *cachep, void *objp)

{

struct array_cache *ac = cpu_cache_get(cachep);

// ... cut ...

if (likely(ac->avail < ac->limit)) {

STATS_INC_FREEHIT(cachep);

ac->entry[ac->avail++] = objp; // <-----

return;

}

}

Таким образом, при наилучшем стечении обстоятельств, операции выделения/освобождения будут иметь сложность O(1).

Предупреждение: если наибыстрейший сценарий завершится неудачно, выделение переходит к более медленному алгоритму (т.е. к сканированию списков свободных/смешанных объектов slab или еще более медленному (cache grow)).

Обратите внимание, что для каждого процессора существует только один массив array_cache. В текущем работающем процессоре array_cache можно извлечь при помощи функции cpu_cache_get(). Эта схема позволяет (как и в случае со всеми по-процессорными переменными) сократить блокировки и увеличить производительность.

Предупреждение: Каждый указатель объекта в массиве array_cache может принадлежать различным slab’ам.

Кэши общего назначения и назначенные кэши

Чтобы уменьшить внутреннюю фрагментацию, ядро создает несколько кэшей с объектами размером равным степени двойки (32, 64, 128, ...). В этом случае внутренняя фрагментация будет всегда меньше 50%. На самом деле, когда ядро пытается выделить память определенного размера, то ищет ближайший ограниченный сверху кэш, куда может уместиться размещаемый объект. Например, для выделения 100 байт подойдет кэш размером 128 байт.

В SLAB кэши общего назначения идут с префиксом «size-» (например, «size‑32», «size‑64»). В SLUB кэши общего назначения идут с префиксом «kmalloc-» (например, «kmalloc‑32», ...). Поскольку нам кажется, что соглашения об именах нагляднее в SLUB, мы будем использовать префиксы «kmalloc», даже если в целевой системе используется SLAB.

Чтобы выделить/освободить память в кэше общего назначения, ядро использует функции kmalloc() и kfree().

Поскольку некоторые объекты будут размещаться/освобождаться много раз, ядро создает специальные «назначенные» кэши. Например, структура file как объект используется во многих местах, у которого есть специальный назначенный кэш filp. Создание назначенного кэша для этих объектов гарантирует, что внутренняя фрагментация тех кэшей будет около нуля.

Чтобы выделить/освободить память в назначенном кэше, ядро использует функции kmem_cache_alloc() и kmem_cache_free().

Функции kmalloc() и kmem_cache_alloc() являются обертками для функции __cache_alloc(), а kfree() и kmem_cache_free() – для __cache_free().

Примечание: Полный список кэшей и другую полезную информацию можно узнать в /proc/slabinfo.

Макрос container_of()

Container_of() используется ядром повсеместно, и рано или поздно все равно придется разобраться, как работает этот макрос.

#define container_of(ptr, type, member) ({ \

const typeof( ((type *)0)->member ) *__mptr = (ptr); \

(type *)( (char *)__mptr - offsetof(type,member) );})

Макрос container_of() предназначен для извлечения адреса структуры через одного из членов этой структуры. Этот макрос использует два других макроса:

· typeof() - определяет статический (compile‑time) тип.

· offsetof() - находит смещение (в байтах) поля в структуре.

Таким образом, container_of() получает адрес текущего поля структуры и вычитает смещение этого поля из указателя на это поле. Рассмотрим конкретный пример:

struct foo {

unsigned long a;

unsigned long b; // offset=8

}

void* get_foo_from_b(unsigned long *ptr)

{

// "ptr" points to the "b" field of a "struct foo"

return container_of(ptr, struct foo, b);

}

void bar() {

struct foo f;

void *ptr;

printf("f=%p\n", &f); // <----- print 0x0000aa00

printf("&f->b=%p\n", &f->b); // <----- print 0x0000aa08

ptr = get_foo_from_b(&f->b);

printf("ptr=%p\n", ptr); // <----- print 0x0000aa00, the address of "f"

}

Циклические дважды связанные списки

Ядро в Линуксе интенсивно использует циклические дважды связанные списки. Важно понимать, как устроены эти списки в целом, которые, к тому же, потребуется нам, чтобы добраться до примитива произвольного вызова. Вместо ознакомления с реализацией сразу же смастерим простой пример, чтобы лучше разобраться с этой темом. По завершению этого раздела вы должны понимать, как работает макрос list_for_each_entry_safe().

Примечание: чтобы не усложнять жизнь, далее мы будем использовать термин «список» вместо «дважды связанный циклический список».

Для обработки списка Линукс использует следующую структуру:

struct list_head {

struct list_head *next, *prev;

};

Эта структура двойного назначения и может использоваться в одном из следующих случаев:

1. Для описания списка (заголовка списка).

2. Для описания элемента в списке.

Список можно инициализировать при помощи функции INIT_LIST_HEAD, которая делает так, что поля next и prev указывают на сам список.

static inline void INIT_LIST_HEAD(struct list_head *list)

{

list->next = list;

list->prev = list;

}

Теперь определим фиктивную структуру resource_owner:

struct resource_owner

{

char name[16];

struct list_head consumer_list;

};

void init_resource_owner(struct resource_owner *ro)

{

strncpy(ro->name, "MYRESOURCE", 16);

INIT_LIST_HEAD(&ro->consumer_list);

}

Чтобы использовать этот список, каждый элемент (например, consumer) списка должен быть полем, описываемым структурой list_head. Например:

struct resource_consumer

{

int id;

struct list_head list_elt; // <----- this is NOT a pointer

};

Элементы consumer (покупатель) добавляются/удаляются из списка при помощи функций list_add() и list_del() соответственно. Типичный код выглядит так:

int add_consumer(struct resource_owner *ro, int id)

{

struct resource_consumer *rc;

if ((rc = kmalloc(sizeof(*rc), GFP_KERNEL)) == NULL)

return -ENOMEM;

rc->id = id;

list_add(&rc->list_elt, &ro->consumer_list);

return 0;

}

Теперь нам нужно освободить список с элементами consumer, однако у нас есть только указатель на начало списка (такая неудачная архитектура используется намеренно). Мы достаем структуру при помощи макроса container_of(), удаляем элемент из списка и освобождаем структуру.

void release_consumer_by_entry(struct list_head *consumer_entry)

{

struct resource_consumer *rc;

// "consumer_entry" points to the "list_elt" field of a "struct resource_consumer"

rc = container_of(consumer_entry, struct resource_consumer, list_elt);

list_del(&rc->list_elt);

kfree(rc);

}

Теперь нам нужно написать функцию для получения содержимого структуры resource_consumer, используя id. То есть нужно будет пройтись по всему списку при помощи макроса list_for_each():

#define list_for_each(pos, head) \

for (pos = (head)->next; pos != (head); pos = pos->next)

#define list_entry(ptr, type, member) \

container_of(ptr, type, member)

Как видно из кода выше, нам понадобился макрос container_of(), поскольку list_for_each() дает нам только указатель структуры list_head (т.е. итератор). Для выполнения этой операции часто используется макрос list_entry(), который делает то же самое, но имеет более наглядное имя:

struct resource_consumer* find_consumer_by_id(struct resource_owner *ro, int id)

{

struct resource_consumer *rc = NULL;

struct list_head *pos = NULL;

list_for_each(pos, &ro->consumer_list) {

rc = list_entry(pos, struct resource_consumer, list_elt);

if (rc->id == id)

return rc;

}

return NULL; // not found

}

Объявление структуры list_head и использование макросов list_entry()/container_of() – немного громоздко. Чтобы упростить задачу, можно воспользоваться макросом list_for_each_entry(), который использует макросы list_first_entry() и list_next_entry().

#define list_first_entry(ptr, type, member) \

list_entry((ptr)->next, type, member)

#define list_next_entry(pos, member) \

list_entry((pos)->member.next, typeof(*(pos)), member)

#define list_for_each_entry(pos, head, member) \

for (pos = list_first_entry(head, typeof(*pos), member); \

&pos->member != (head); \

pos = list_next_entry(pos, member))

Предыдущий код можно переписать в более компактном виде (без объявления структуры list_head):

struct resource_consumer* find_consumer_by_id(struct resource_owner *ro, int id)

{

struct resource_consumer *rc = NULL;

list_for_each_entry(rc, &ro->consumer_list, list_elt) {

if (rc->id == id)

return rc;

}

return NULL; // not found

}

Теперь нам нужна функция, которая очищает список. Здесь возникает две проблемы:

Функция release_consumer_by_entry() реализована не очень удачно и принимает в качестве аргумента указатель структуры list_head.

При использовании макроса list_for_each() предполагается, что список изменяться не будет.

Таким образом, нам нельзя освобождать элементы во время прохождения по списку, поскольку может возникнуть ошибка use‑after‑free. Чтобы решить эту задачу была создана функция list_for_each_safe(), которая заблаговременно берет следующий элемент:

#define list_for_each_safe(pos, n, head) \

for (pos = (head)->next, n = pos->next; pos != (head); \

pos = n, n = pos->next)

При использовании этой функции необходимо объявить две структуры list_head:

void release_all_consumers(struct resource_owner *ro)

{

struct list_head *pos, *next;

list_for_each_safe(pos, next, &ro->consumer_list) {

release_consumer_by_entry(pos);

}

}

Поскольку мы пришли к выводу, что release_consumer_by_entry() реализована не очень удачно, переписываем эту функцию, когда в качестве аргумента передается указатель структуры resource_consumer (без использования макроса container_of()):

void release_consumer(struct resource_consumer *rc)

{

if (rc)

{

list_del(&rc->list_elt);

kfree(rc);

}

}

Поскольку теперь структура list_head в аргументе не передается, функцию release_all_consumers() можно переписать, используя макрос list_for_each_entry_safe():

#define list_for_each_entry_safe(pos, n, head, member) \

for (pos = list_first_entry(head, typeof(*pos), member), \

n = list_next_entry(pos, member); \

&pos->member != (head); \

pos = n, n = list_next_entry(n, member))

void release_all_consumers(struct resource_owner *ro)

{

struct resource_consumer *rc, *next;

list_for_each_entry_safe(rc, next, &ro->consumer_list, list_elt) {

release_consumer(rc);

}

}

Прекрасно! В нашем коде больше не используются структуры list_head.

Надеюсь, теперь вы поняли, как работает макрос list_for_each_entry_safe(). Если нет, перечитайте этот раздел заново. Функция list_for_each_entry_safe() будет использоваться для того, чтобы добраться до примитива произвольного вызова в эксплоите. Этот же макрос мы увидим в дизассемблированном коде (из-за смещений), поэтому лучше понять логику работы list_for_each_entry_safe() прямо сейчас.

Суть уязвимостей типа use‑after‑free

В этом разделе будет рассмотрена базовая теория, касающаяся use‑after‑free, а также условия, необходимые для использования ошибок подобного типа, и наиболее распространенные стратегии эксплуатации.

Паттерн

Сложно придумать более правильное имя для подобного рода уязвимостей, поскольку в этом названии описывается сама суть проблемы. Простейший паттерн ошибки use‑after‑free:

int *ptr = (int*) malloc(sizeof(int));

*ptr = 54;

free(ptr);

*ptr = 42; // <----- use-after-free

Причина, почему ситуация, показанная выше, называется уязвимостью - никто не знает, что находится у памяти (на которую указывает ptr) после вызова free(ptr). Этот указатель называется подвисшим. Операции чтения и/или записи приводят к непредсказуемым последствиям. В лучшем случае, ничего не произойдет, в худшем – крах приложения (или ядра).

Сбор информации

Эксплуатация дыр use‑after‑free в ядра часто осуществляется по одной и той же схеме. Однако прежде нужно получить ответы на следующие вопросы:

Какой используется аллокатор? Как работает этот аллокатор?

О каком объекте идет речь?

Какому кэшу принадлежит этот объект? Каков размер объекта? Какой тип кэша (общего назначения или назначенный)?

Где происходит выделение/освобождение памяти?

Где используется объект после освобождения? Как происходит чтение/запись?

Чтобы ответить на эти вопросы, в Google разработали прекрасный инструмент: KASAN (Kernel Address SANitizer). Типичный отчет выглядит так:

==================================================================

BUG: KASAN: use-after-free in debug_spin_unlock // <--- the "where"

kernel/locking/spinlock_debug.c:97 [inline]

BUG: KASAN: use-after-free in do_raw_spin_unlock+0x2ea/0x320

kernel/locking/spinlock_debug.c:134

Read of size 4 at addr ffff88014158a564 by task kworker/1:1/5712 // <--- the "how"

CPU: 1 PID: 5712 Comm: kworker/1:1 Not tainted 4.11.0-rc3-next-20170324+ #1

Hardware name: Google Google Compute Engine/Google Compute Engine,

BIOS Google 01/01/2011

Workqueue: events_power_efficient process_srcu

Call Trace: // <--- call trace that reach it

__dump_stack lib/dump_stack.c:16 [inline]

dump_stack+0x2fb/0x40f lib/dump_stack.c:52

print_address_description+0x7f/0x260 mm/kasan/report.c:250

kasan_report_error mm/kasan/report.c:349 [inline]

kasan_report.part.3+0x21f/0x310 mm/kasan/report.c:372

kasan_report mm/kasan/report.c:392 [inline]

__asan_report_load4_noabort+0x29/0x30 mm/kasan/report.c:392

debug_spin_unlock kernel/locking/spinlock_debug.c:97 [inline]

do_raw_spin_unlock+0x2ea/0x320 kernel/locking/spinlock_debug.c:134

__raw_spin_unlock_irq include/linux/spinlock_api_smp.h:167 [inline]

_raw_spin_unlock_irq+0x22/0x70 kernel/locking/spinlock.c:199

spin_unlock_irq include/linux/spinlock.h:349 [inline]

srcu_reschedule+0x1a1/0x260 kernel/rcu/srcu.c:582

process_srcu+0x63c/0x11c0 kernel/rcu/srcu.c:600

process_one_work+0xac0/0x1b00 kernel/workqueue.c:2097

worker_thread+0x1b4/0x1300 kernel/workqueue.c:2231

kthread+0x36c/0x440 kernel/kthread.c:231

ret_from_fork+0x31/0x40 arch/x86/entry/entry_64.S:430

Allocated by task 20961: // <--- where is it allocated

save_stack_trace+0x16/0x20 arch/x86/kernel/stacktrace.c:59

save_stack+0x43/0xd0 mm/kasan/kasan.c:515

set_track mm/kasan/kasan.c:527 [inline]

kasan_kmalloc+0xaa/0xd0 mm/kasan/kasan.c:619

kmem_cache_alloc_trace+0x10b/0x670 mm/slab.c:3635

kmalloc include/linux/slab.h:492 [inline]

kzalloc include/linux/slab.h:665 [inline]

kvm_arch_alloc_vm include/linux/kvm_host.h:773 [inline]

kvm_create_vm arch/x86/kvm/../../../virt/kvm/kvm_main.c:610 [inline]

kvm_dev_ioctl_create_vm arch/x86/kvm/../../../virt/kvm/kvm_main.c:3161 [inline]

kvm_dev_ioctl+0x1bf/0x1460 arch/x86/kvm/../../../virt/kvm/kvm_main.c:3205

vfs_ioctl fs/ioctl.c:45 [inline]

do_vfs_ioctl+0x1bf/0x1780 fs/ioctl.c:685

SYSC_ioctl fs/ioctl.c:700 [inline]

SyS_ioctl+0x8f/0xc0 fs/ioctl.c:691

entry_SYSCALL_64_fastpath+0x1f/0xbe

Freed by task 20960: // <--- where it has been freed

save_stack_trace+0x16/0x20 arch/x86/kernel/stacktrace.c:59

save_stack+0x43/0xd0 mm/kasan/kasan.c:515

set_track mm/kasan/kasan.c:527 [inline]

kasan_slab_free+0x6e/0xc0 mm/kasan/kasan.c:592

__cache_free mm/slab.c:3511 [inline]

kfree+0xd3/0x250 mm/slab.c:3828

kvm_arch_free_vm include/linux/kvm_host.h:778 [inline]

kvm_destroy_vm arch/x86/kvm/../../../virt/kvm/kvm_main.c:732 [inline]

kvm_put_kvm+0x709/0x9a0 arch/x86/kvm/../../../virt/kvm/kvm_main.c:747

kvm_vm_release+0x42/0x50 arch/x86/kvm/../../../virt/kvm/kvm_main.c:758

__fput+0x332/0x800 fs/file_table.c:209

____fput+0x15/0x20 fs/file_table.c:245

task_work_run+0x197/0x260 kernel/task_work.c:116

exit_task_work include/linux/task_work.h:21 [inline]

do_exit+0x1a53/0x27c0 kernel/exit.c:878

do_group_exit+0x149/0x420 kernel/exit.c:982

get_signal+0x7d8/0x1820 kernel/signal.c:2318

do_signal+0xd2/0x2190 arch/x86/kernel/signal.c:808

exit_to_usermode_loop+0x21c/0x2d0 arch/x86/entry/common.c:157

prepare_exit_to_usermode arch/x86/entry/common.c:194 [inline]

syscall_return_slowpath+0x4d3/0x570 arch/x86/entry/common.c:263

entry_SYSCALL_64_fastpath+0xbc/0xbe

The buggy address belongs to the object at ffff880141581640

which belongs to the cache kmalloc-65536 of size 65536 // <---- the object's cache

The buggy address is located 36644 bytes inside of

65536-byte region [ffff880141581640, ffff880141591640)

The buggy address belongs to the page: // <---- even more info

page:ffffea000464b400 count:1 mapcount:0 mapping:ffff880141581640

index:0x0 compound_mapcount: 0

flags: 0x200000000008100(slab|head)

raw: 0200000000008100 ffff880141581640 0000000000000000 0000000100000001

raw: ffffea00064b1f20 ffffea000640fa20 ffff8801db800d00

page dumped because: kasan: bad access detected

Memory state around the buggy address:

ffff88014158a400: fb fb fb fb fb fb fb fb fb fb fb fb fb fb fb fb

ffff88014158a480: fb fb fb fb fb fb fb fb fb fb fb fb fb fb fb fb

>ffff88014158a500: fb fb fb fb fb fb fb fb fb fb fb fb fb fb fb fb

^

ffff88014158a580: fb fb fb fb fb fb fb fb fb fb fb fb fb fb fb fb

ffff88014158a600: fb fb fb fb fb fb fb fb fb fb fb fb fb fb fb fb

==================================================================

Довольно симпатично, не правда ли?

Примечание: вышеуказанный отчет об ошибках был получен при помощи еще одной прекрасной утилиты syzkaller.

К сожалению, в вашей тестовой среде KASAN может не запуститься, потому что, насколько мне известно, этот инструмент заточен под ядра версии 4.x и поддерживает не все архитектуры. В этом случае вам придется делать всю работу вручную.

Кроме того, KASAN показывает только одно место, где возникает use‑after‑free. В реальности висячих указателей может быть намного больше (подробнее эту тему рассмотрим позже), и чтобы найти эти указатели, нужно дополнительно анализировать код.

Эксплуатация ошибок use‑after‑free через несоответствие типов

Существует несколько способов эксплуатации уязвимостей use‑after‑free. Например, можно поиграться с метаданными аллокатора. Однако использование этого метода на уровне ядра может оказаться немного затруднительным. Задача осложняется еще и тем, что придется восстанавливать ядро после окончания отработки эксплоита. Восстановление ядра будет рассмотрено в четвертой части. Этот шаг нельзя обойти, поскольку в противном случае ядро упадет после завершения эксплоита, что мы уже наблюдали в предыдущей части.

Наиболее распространенный способ эксплуатации UAF (use‑after‑free) – через несоответствие типов (type confusion), которое возникает, когда ядро неправильно интерпретирует тип данных. Если говорить более конкретно, то при использовании указателя ядро «думает», что идет ссылка на один тип данных, а на самом деле указатель ссылается на другой тип данных. Поскольку ядро написано на С, проверка типов происходит во время компиляции. Однако процессор не особо заботится о типах, а только разыменовывает адреса с фиксированными смещениями.

В целом, стратегия эксплуатации UAF через несоответствие типов выглядит следующим образом:

Перевод ядра в нужное состояние (например, подготовка сокета к блокировке).

Активация уязвимости, которая освобождает целевой объект. В то же время висячие указатели должны оставаться нетронутыми.

Немедленное повторное размещение другого объекта, у которого мы можем контролировать данные.

Активация примитива в UAF через висячие указатели.

Перехват управления нулевого кольца.

Восстановление ядра и удаление следов.

Профит!

Если вы смастерили эксплоит правильно, единственное, где у вас может возникнуть загвоздка – шаг 3. Далее увидите, почему.

Примечание: Эксплуатация уязвимостей use‑after‑free через несоответствие типов предполагает, что целевой объект принадлежит кэшу общего назначения. В противном случае нужно использовать более продвинутые техники, которые мы не будет рассматривать в этой серии.

Анализ UAF (кэш, размещение в памяти, освобождение)

В этом разделе будут даны ответы на вопросы, затронутые выше, касающиеся сбора информации.

Какой используется аллокатор?

В нашей целевой системе используется SLAB аллокатор. Как было упомянуто в разделе «Базовые концепции #3», узнать текущий рабочий аллокатор можно в файле, содержащим конфигурацию ядра. Альтернативный способ: посмотреть имена кэшей общего назначения в файле /proc/slabinfo. В именах кэшей есть префиксы «size-» или «kmalloc-»?

Мы также рассмотрели структуры данных, с которыми работает этот аллокатор (особенно array_cache).

Примечание: Если вы плохо знакомы с механикой работы вашего аллокатора (особенно ветвями кода функций kmalloc()/kfree()), настало время ознакомиться.

О каком объекте идет речь?

Если после ознакомления с первой и второй частью еще не очевидно, то напомним, что уязвимость use‑after‑free будет эксплуатировать в отношении структуры netlink_sock, которая объявлена следующим образом:

// [include/net/netlink_sock.h]

struct netlink_sock {

/* struct sock has to be the first member of netlink_sock */

struct sock sk;

u32 pid;

u32 dst_pid;

u32 dst_group;

u32 flags;

u32 subscriptions;

u32 ngroups;

unsigned long *groups;

unsigned long state;

wait_queue_head_t wait;

struct netlink_callback *cb;

struct mutex *cb_mutex;

struct mutex cb_def_mutex;

void (*netlink_rcv)(struct sk_buff *skb);

struct module *module;

};

В нашем случае объект для эксплуатации уязвимости очевиден, однако иногда подбор подходящей кандидатуры может отнять много времени. Особенно если объект владеет другими объектами (т.е. обрабатывает жизненный цикл этих объектов). UAF может быть в одном из этих дочерних объектов.

Где освобождается объект?

В первой части было показано, что в начале вызова mq_notify() счетчик ссылок структуры netlink_sock равен единице. Затем счетчик ссылок увеличивается на единицу в функции netlink_getsockbyfilp, уменьшается на единицу в функции netlink_attachskb(), а затем еще раз уменьшается на единицу в функции. Таким образом, получается следующая последовательность вызовов:

- mq_notify

- netlink_detachskb

- sock_put // <----- atomic_dec_and_test(&sk->sk_refcnt)

Поскольку счетчик вызовов становится равным нулю, то освобождается во время вызова функции sk_free():

void sk_free(struct sock *sk)

{

/*

* We subtract one from sk_wmem_alloc and can know if

* some packets are still in some tx queue.

* If not null, sock_wfree() will call __sk_free(sk) later

*/

if (atomic_dec_and_test(&sk->sk_wmem_alloc))

__sk_free(sk);

}

Вспоминаем, что в поле sk‑>sk_wmem_alloc хранится «текущий» размер буфера отправки. Во время инициализации структуры netlink_sock в этом поле была установлена единица. Поскольку мы не отослали ни одного сообщения целевому сокету, перед началом вызова sk_free() в этом поле все также остается единица. Далее происходит вызов __sk_free():

// [net/core/sock.c]

static void __sk_free(struct sock *sk)

{

struct sk_filter *filter;

[0] if (sk->sk_destruct)

sk->sk_destruct(sk);

// ... cut ...

[1] sk_prot_free(sk->sk_prot_creator, sk);

}

Если выполняется условие в строке [0], происходит вызов «специализированного» деструктора. В строке [1] вызывается функция sk_prot_free() с аргументом, представляющим собой тип, описываемый структурой proto. В конце объект освобождается в зависимости от принадлежности тому или иному кэшу (см. следующий раздел):

static void sk_prot_free(struct proto *prot, struct sock *sk)

{

struct kmem_cache *slab;

struct module *owner;

owner = prot->owner;

slab = prot->slab;

security_sk_free(sk);

if (slab != NULL)

kmem_cache_free(slab, sk); // <----- this one or...

else

kfree(sk); // <----- ...this one ?

module_put(owner);

}

Таким образом, получаем следующее дерево вызовов:

- <<< what ever calls sock_put() on a netlink_sock (e.g. netlink_detachskb()) >>>

- sock_put

- sk_free

- __sk_free

- sk_prot_free

- kmem_cache_free or kfree

Примечание: Вспоминаем, что sk и netlink_sock являются псевдонимами (см. первую часть). То есть освобождение указателя объекта sock влечет за собой освобождение всего объекта netlink_sock!

Сейчас нам нужно разобраться с последним вызовом, но вначале необходимо узнать, к какому кэшу относится объект.

К какому кэшу принадлежит объект?

Вспоминаем, что Линукс является объектно-ориентированной системой со множеством слоев абстракций и специализаций (см. первую часть).

Структура proto принадлежит еще одному слою абстракции:

1. Операции файла с типом socket (структура file) определяются объектом socket_file_ops.

2. Операции BSD-сокета семейства netlink (структура socket) определяются объектом netlink_ops.

3. Операции объекта sock (структура sock) определяются объектами netlink_proto и netlink_family_ops.

Примечание: к netlink_family_ops мы вернемся в следующем разделе.

В отличие от socket_file_ops и netlink_ops, представляющих собой в основном таблицу виртуальных функций, структура proto является чуть более сложной. В этой структуре, помимо таблицы виртуальных функций, есть информация, описывающая жизненный цикл структуры sock. В частности, «как» специализированный объект sock может быть размещен.

В нашем случае самыми важными являются поля slab и obj_size:

// [include/net/sock.h]

struct proto {

struct kmem_cache *slab; // the "dedicated" cache (if any)

unsigned int obj_size; // the "specialized" sock object size

struct module *owner; // used for Linux module's refcounting

char name[32];

// ...

}

В случае с объектом netlink_sock используется структура netlink_proto:

static struct proto netlink_proto = {

.name = "NETLINK",

.owner = THIS_MODULE,

.obj_size = sizeof(struct netlink_sock),

};

Поле obj_size определяет не конечный размер выделяемой памяти, а только часть (см. следующий раздел).

Как видно выше, многие поля остаются пустыми (т.е. равными NULL). Можно ли сделать вывод, что у структуры netlink_proto нет назначенного кэша? Мы не можем сказать точно, поскольку поле slab определяется во время регистрации протокола. Мы коснемся регистрации протокола лишь вскользь, чтобы иметь базовое понимание.

В Линуксе сетевые модули загружаются либо во время загрузки операционной системы, либо более «ленивым» способом, когда определенный сокет начинает использоваться впервые. В любом случае вызывается «инициализирующая» функция. В случае с netlinkподобной функцией является netlink_proto_init(), которая выполняет следующие операции:

1. Вызывает proto_register(&netlink_proto, 0).

2. Вызывает sock_register(&netlink_family_ops).

Функция proto_register определяет, будет ли протокол использовать назначенный кэш. Если да, то создается назначенный kmem_cache, если нет – будут использоваться кэши общего назначения. Выбор того или иного кэша зависит от параметра alloc_slab (второй аргумент):

// [net/core/sock.c]

int proto_register(struct proto *prot, int alloc_slab)

{

if (alloc_slab) {

prot->slab = kmem_cache_create(prot->name, // <----- creates a kmem_cache named "prot->name"

sk_alloc_size(prot->obj_size), 0, // <----- uses the "prot->obj_size"

SLAB_HWCACHE_ALIGN | proto_slab_flags(prot),

NULL);

if (prot->slab == NULL) {

printk(KERN_CRIT "%s: Can't create sock SLAB cache!\n", prot->name);

goto out;

}

// ... cut (allocates other things) ...

}

// ... cut (register in the proto_list) ...

return 0;

// ... cut (error handling) ...

}

Только в этом месте протоколу может выделен назначенный кэш. Поскольку функция netlink_proto_init() вызывает proto_register с аргументом alloc_slab равным нулю, протокол netlink использует один из кэшей общего назначения. Как вы можете догадаться, рассматриваемый кэш общего назначения будет зависеть от значения, установленного в поле obj_size.

Подробности в следующем разделе.

Где происходит размещение?

На данный момент нам известно, что во время «регистрации протокола» в семействе netlink происходит регистрация структуры net_proto_family, а, значит, и структуры netlink_family_ops:

struct net_proto_family {

int family;

int (*create)(struct net *net, struct socket *sock,

int protocol, int kern);

struct module *owner;

};

static struct net_proto_family netlink_family_ops = {

.family = PF_NETLINK,

.create = netlink_create, // <-----

.owner = THIS_MODULE,

};

При вызове функции netlink_create() структура socket уже размещена. Цель netlink_create() – разместить структуру netlink_sock, связать эту структуру с сокетом и инициализировать поля структур socket и netlink_sock. Здесь же проводятся проверки на тип сокета (RAW, DGRAM) и идентификатор netlink-протокола (NETLINK_USERSOCK, ...).

static int netlink_create(struct net *net, struct socket *sock, int protocol, int kern)

{

struct module *module = NULL;

struct mutex *cb_mutex;

struct netlink_sock *nlk;

int err = 0;

sock->state = SS_UNCONNECTED;

if (sock->type != SOCK_RAW && sock->type != SOCK_DGRAM)

return -ESOCKTNOSUPPORT;

if (protocol < 0 || protocol >= MAX_LINKS)

return -EPROTONOSUPPORT;

// ... cut (load the module if protocol is not registered yet - lazy loading) ...

err = __netlink_create(net, sock, cb_mutex, protocol, kern); // <-----

if (err < 0)

goto out_module;

// ... cut...

}

В свою очередь, функция __netlink_create() играет главную роль во время создания структуры netlink_sock.

static int __netlink_create(struct net *net, struct socket *sock, struct mutex *cb_mutex, int protocol, int kern)

{

struct sock *sk;

struct netlink_sock *nlk;

[0] sock->ops = &netlink_ops;

[1] sk = sk_alloc(net, PF_NETLINK, GFP_KERNEL, &netlink_proto);

if (!sk)

return -ENOMEM;

[2] sock_init_data(sock, sk);

// ... cut (mutex stuff) ...

[3] init_waitqueue_head(&nlk->wait);

[4] sk->sk_destruct = netlink_sock_destruct;

sk->sk_protocol = protocol;

return 0;

}

Функция __netlink_create() делает следующее:

[0] – устанавливает в качестве виртуальной таблицы функций сокета, описываемой структурой proto_ops, объект netlink_ops.

[1] – размещает netlink_sock, используя информацию полей prot‑>slab и prot‑>obj_size.

[2] – инициализирует буфер приема/передачи, переменные sk_rcvbuf/sk_sndbuf, привязывает сокет к структуре sock и т. д.

[3] – инициализирует очередь ожидания (см. вторую часть).

[4] – определяет специализированный деструктор, который будет вызываться во время освобождения структуры netlink_sock (см. предыдущий раздел).

Наконец, функция sk_alloc() вызывает sk_prot_alloc() [1], используя структуру proto (т.е. netlink_proto). Именно в этом месте ядро выбирает для размещения назначенный кэш или кэш общего назначения:

static struct sock *sk_prot_alloc(struct proto *prot, gfp_t priority, int family)

{

struct sock *sk;

struct kmem_cache *slab;

slab = prot->slab;

if (slab != NULL) {

sk = kmem_cache_alloc(slab, priority & ~__GFP_ZERO); // <-----

// ... cut (zeroing the freshly allocated object) ...

}

else

sk = kmalloc(sk_alloc_size(prot->obj_size), priority); // <-----

// ... cut ...

return sk;

}

Как было показано выше, во время регистрации netlink-протокола, поле slab не используется (поскольку в этом поле установлено NULL). Таким образом, вызывается функция kmalloc() и, соответственно, используется кэш общего назначения.

Теперь нам нужно разобраться с деревом вызовов до функции netlink_create(). Как можно догадаться, стартовая точка отсчета – системный вызов socket(). Мы не будем рассматривать все возможные сценарии (останется вам в качестве домашнего задания), а затронем только самую суть:

- SYSCALL(socket)

- sock_create

- __sock_create // allocates a "struct socket"

- pf->create // pf == netlink_family_ops

- netlink_create

- __netlink_create

- sk_alloc

- sk_prot_alloc

- kmalloc

Теперь мы знаем, где размещается объект netlink_sock и выбирается кэш kmem_cache общего назначения. Однако пока мы не знаем, какой конкретно используется кэш (kmalloc‑32? kmalloc‑64?).

Статические и динамические методы для вычисления размера объекта

Из предыдущего раздела мы знаем, что объект netlink_sock размещается в кэше общего назначения kmem_cache во время следующего вызова:

kmalloc(sk_alloc_size(prot->obj_size), priority)

Содержимое функции sk_alloc_size():

#define SOCK_EXTENDED_SIZE ALIGN(sizeof(struct sock_extended), sizeof(long))

static inline unsigned int sk_alloc_size(unsigned int prot_sock_size)

{

return ALIGN(prot_sock_size, sizeof(long)) + SOCK_EXTENDED_SIZE;

}

Примечание: структура sock_extended создается для расширения первоначальной структуры sock без нарушения двоичного интерфейса приложений (ABI) в ядре. Особо разбираться в этой теме не обязательно, но отметим, что размер этого объекта добавляется к первоначально выделяемой памяти.

Таким образом, получаем следующую формулу: sizeof(struct netlink_sock) + sizeof(struct sock_extended) + SOME_ALIGNMENT_BYTES.

Важно отметить, что нам не нужен точный размер. Поскольку выделение происходит в кэше общего назначения kmem_cache, нам лишь нужно найти кэш, ограниченный сверху, в котором можно разместить объект (см. Базовые концепции #3).

Предупреждение-1: В разделе «Базовые концепции #3» говорилось, что кэши общего назначения имеют размер равный степени двойки, что, на самом деле, не совсем верно. В некоторых системах используются размеры «kmalloc‑96» и «kmalloc‑192», поскольку размеры большинства объектов близки к этим значениям, а не к степени двойки. Эти кэши уменьшают внутреннюю фрагментацию.

Предупреждение-2: Методы, используемые исключительно для отладки, могут помочь примерно вычислить размеры объектов. Однако в рабочих системах из-за препроцессоров CONFIG_* размеры тех же объектов в ядре будут другими. Разница в размерах может варьироваться от нескольких до сотен байт! Кроме того, следует обращать особое внимание на те случаи, когда вычисленный размер объекта близок к границе размера объекта kmem_cache. Например, объект размером 260 будет находиться в кэше kmalloc‑512. Однако в рабочей системе размер может уменьшиться до 220 байт (соответственно, будет использоваться кэш kmalloc‑256, и во время эксплуатации могут возникнуть проблемы).

При помощи Метода #5 (см. ниже) выяснится, что наш целевой размер «kmalloc‑1024». Этот кэш очень подходит для эксплуатации уязвимости use‑after‑free, в чем вы убедитесь, после изучения раздела, посвященного переразмещению.

Метод #1 [статический]: Ручное вычисление

Идея заключается в том, чтобы вручную сложить все размеры полей (тип int – 4 байта, long – 8 байт и так далее). Этот метод хорошо работает для «небольших» структур, но дает большую погрешность для больших. Нужно учитывать, выравнивание, дополнение и упаковку. Например:

struct __wait_queue {

unsigned int flags; // offset=0, total_size=4

// offset=4, total_size=8 <---- PADDING HERE TO ALIGN ON 8 BYTES

void *private; // offset=8, total_size=16

wait_queue_func_t func; // offset=16, total_size=24

struct list_head task_list; // offset=24, total_size=40 (sizeof(list_head)==16)

};

Размер структуры выше вычислить легко. Но если вы посмотрите на структуру sock, то погрешность может оказаться очень большой, поскольку нужно учитывать каждый препроцессорный макрос CONFIG_ и обрабатывать сложные «объединения».

Метод #2 [статический]: при помощи Pahole (применим только для отладочной версии)

Pahole делает всю работу из предыдущего метода автоматически. Например, выгрузим скелет структуры socket:

$ pahole -C socket vmlinuz_dwarf

struct socket {

socket_state state; /* 0 4 */

short int type; /* 4 2 */

/* XXX 2 bytes hole, try to pack */

long unsigned int flags; /* 8 8 */

struct socket_wq * wq; /* 16 8 */

struct file * file; /* 24 8 */

struct sock * sk; /* 32 8 */

const struct proto_ops * ops; /* 40 8 */

/* size: 48, cachelines: 1, members: 7 */

/* sum members: 46, holes: 1, sum holes: 2 */

/* last cacheline: 48 bytes */

};

На первый взгляд кажется, что эта утилита подойдет для решения нашей задачи, однако для корректной работы Pahole нужно, чтобы в образе ядра были символы DWARF, которых нет в ядрах, используемых в рабочих системах.

Метод #3 [статический]: при помощи дизассемблеров

Вы не сможете точно вычислить размер, переданный в kmalloc(), поскольку это значение рассчитывается динамически. Однако вы можете попробовать поискать смещение, используемое в тех структурах (особенно в последних полях), а завершить вычисления вручную. Мы воспользуемся этим методом позже.

Метод #4 [динамический]: при помощи System Tap (применим только для отладочной версии)

В первой части рассматривалось, как в продвинутом режиме в Sytem Tap написать код (модуль) для ядра. Мы можем воспользоваться этой техникой еще раз и «повторно запустить» функцию sk_alloc_size(). Обратите внимание, что возможно у вас не получится вызвать sk_alloc_size() напрямую, поскольку эта функция встроенная. Однако вы можете скопировать/вставить код и сделать выгрузку.

Еще один способ снять параметры kmalloc() – во время системного вызова socket(). Вполне возможно будет несколько вызовов kmalloc(), и чтобы найти правильный, нужно закрыть только что созданный сокет, снять параметры функции kfree() и сравнить указатели с тем, которые используются в kmalloc(). Поскольку первый аргумент функции kmalloc() – размер, вы найдете корректное значение.

Альтернативный вариант: вызов функции print_backtrace() внутри kmalloc(). Однако следует быть очень внимательным, поскольку System Tap перестает выводить результаты, если сообщений слишком много!

Метод #5 [динамический]: при помощи «/proc/slabinfo»

На первый взгляд, кажется, что этот метод не заслуживает внимания, но на самом деле работает великолепно. Если kmem_cache использует назначенный кэш, тогда можно узнать размер объекта в колонке «objsize» при условии, что вы знаете имя kmem_cache (см. структуру proto)!

С другой стороны, можно написать простую программу, которая размещает множество целевых объектов. Например:

int main(void)

{

while (1)

{

// allocate by chunks of 200 objects

for (int i = 0; i < 200; ++i)

_socket(AF_NETLINK, SOCK_DGRAM, NETLINK_USERSOCK);

getchar();

}

return 0;

}

Примечание: техника, показанная выше, называется heap spraying (распыление кучи).

В отдельном окне выполните следующую команду:

watch -n 0.1 'sudo cat /proc/slabinfo | egrep "kmalloc-|size-" | grep -vi dma'

Затем запустите программу и нажмите любую клавишу для выделения следующего блока. Через некоторое время вы увидите, что один из кэшей общего назначения (см. колонки active_objs/num_objs) начинает увеличиваться. Тот кэш, который будет разрастаться – и есть наш искомый kmem_cache!

Краткие итоги

Было потрачено много времени на сбор информации. Однако проделанная работа пойдет на пользу. Теперь мы лучше знаем API, используемое в сетевом протоколе. Надеюсь, теперь вы понимаете, почему KASAN – прекрасный инструмент, который делает все манипуляции, показанные выше (и даже больше), в автоматическом режиме.

Подытоживаем ответы на все вопросы:

· Какой используется аллокатор? SLAB.

· Какой нужен объект? Структура netlink_sock.

· К какому кэшу принадлежит этот объект? kmalloc‑1024.

· Где выделяется память?

- SYSCALL(socket)

- sock_create

- __sock_create // allocates a "struct socket"

- pf->create // pf == netlink_family_ops

- netlink_create

- __netlink_create

- sk_alloc

- sk_prot_alloc

- kmalloc

· Где освобождается память?

- <<< what ever calls sock_put() on a netlink_sock (e.g. netlink_detachskb()) >>>

- sock_put

- sk_free

- __sk_free

- sk_prot_free

- kfree

Теперь осталось разобраться, как, собственно, написать сам эксплоит, о чем мы поговорим следующем разделе.

Анализ UAF (висячие указатели)

Возвращаемся к нашей уязвимости.

В этом разделе мы найдем висячие указатели, связанные с уязвимостью, и разберемся, почему написанный ранее концептуальный код (см. вторую часть) вызывает крах, и почему мы уже выполнили «трансфер UAF» (этот термин не является «официальным»), что сыграет нам на руку.

Идентификация висячих указателей

На данный момент ядро просто падает, мы не можем узнать об ошибках через dmesg, и у нас нет ни одного дерева вызовов, чтобы разобраться, почему происходит крах. Единственное, в чем мы точно уверены – возникает падение после того, как мы нажимаем на клавишу, но никогда перед. Конечно, это явление ожидаемое, поскольку мы уже сделали «трансфер UAF».

Теперь разберем подробности.

Во время инициализации эксплоита мы сделали следующее:

Создали NETLINK-сокет.

Сделали привязку созданного сокета.

Заполнили буфер приема у сокета.

Сделали дубликат сокета (дважды).

Теперь мы находимся в следующей ситуации:

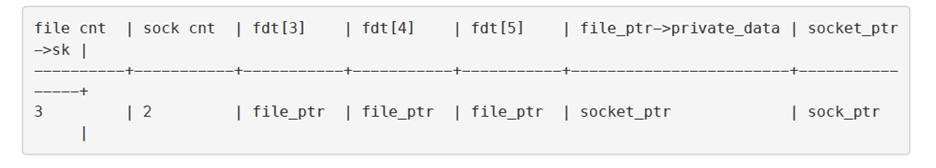

Рисунок 1: Состояние памяти после инициализации эксплоита

Обратите внимание на различие между socket_ptr (структура socket) и sock_ptr (структура netlink_sock).

Содержимое элементов таблицы файловых дескрипторов из схемы выше:

fdt[3] (fd=3) – sock_fd.

fdt[4] (fd=4) – unblock_fd.

fdt[5] (fd=5) – sock_fd2.

У структуры file, связанной с нашим netlink-сокетом, счетчик ссылок равен 3 (увеличивался в функции socket() и два раза в dup(). Счетчик ссылок структуры sock равен 2 (увеличивался в функциях socket() и bind()).

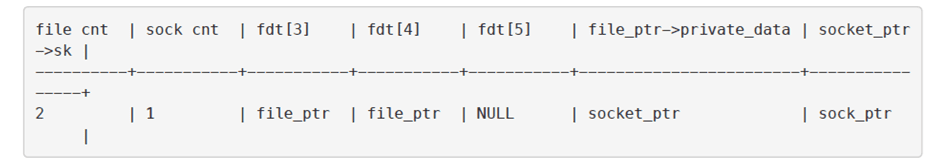

Предположим, что мы активировали уязвимость один раз. Счетчик ссылок структуры sock будет уменьшен на единицу, счетчик ссылок структуры file тоже будет уменьшен на единицу, а элемент fdt[5] станет равным NULL. Обратите внимание, что вызов close(5) не уменьшил счетчик ссылок структуры sock на единицу (уменьшение произошло из-за уязвимости)!

Теперь ситуация становится следующей:

Рисунок 2: Состояние памяти после первичной активации уязвимости

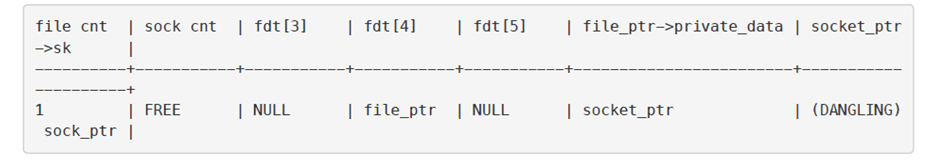

Активируем уязвимость во второй раз:

Рисунок 3: Состояние памяти после повторной активации уязвимости

И вновь вызов close(3) не уменьшил счетчик ссылок структуры sock (уменьшение произошло из-за уязвимости)! Поскольку теперь счетчик стал равен нулю, структура sock освободилась.

Как мы видим, структура file до сих пор остается действующей, поскольку на эту структуру указывает fdt[4] (см. Рисунок 3). Более того, в структуре socket появился висячий указатель на только что освобожденный объект sock. Это явление и называется «трансфер UAF». В отличие от первого сценария (см. первую часть), где переменная «sock» была висячим указателем (в функции mq_notify()), теперь висячим указателем является поле sk структуры socket. Другими словами, у нас есть «доступ» к висячему указателю структуры socket через структуру file через файловый дескриптор unblock_fd.

Возникает вопрос, почему структура socket до сих пор хранит висячий указатель? Причина заключается в том, что объект netlink_sock освобождается функцией __sk_free(), которая делает следующее (см. предыдущий раздел):

1. Вызывает функцию netlink_sock_destruct() (деструктор сокета).

2. Вызывает функцию sk_prot_free().

Ни одна из вышеперечисленных функция не обновляет структуру socket.

Если вы взглянете на логи dmesg перед нажатием клавиши (в эксплоите), то найдете схожее сообщение:

[ 141.771253] Freeing alive netlink socket ffff88001ab88000

Это сообщение приходит из деструктора netlink_sock_destruct() объекта sock (который вызывается функцией __sk_free()):

static void netlink_sock_destruct(struct sock *sk)

{

struct netlink_sock *nlk = nlk_sk(sk);

// ... cut ...

if (!sock_flag(sk, SOCK_DEAD)) {

printk(KERN_ERR "Freeing alive netlink socket %p\n", sk); // <-----

return;

}

// ... cut ...

}

Ну, хорошо. Мы нашли один висячий указатель. Но на самом деле таких указателей больше.

Во время привязки целевого сокета при помощи функции netlink_bind() мы видели, что счетчик ссылок увеличился на единицу, вследствие чего можно сослаться на этот объект в функции netlink_getsockbypid(). Если не вдаваться глубоко в детали, то можно сказать, что указатели структуры netlink_sock хранятся в списке хешей поля nl_table (эта тема рассматривается в четвертой части). По время освобождения объекта sock эти указатели также становится висячими.

Важно найти все висячие указатели по двум причинам:

1. Эти указатели могут использоваться для эксплуатации уязвимости use‑after‑free и для получения нужных примитивов.

2. Мы должны починить эти указатели во время восстановления ядра.

Двигаемся дальше. Теперь нужно разобраться, почему ядро падает во время завершения эксплоита.

Почему возникает крах

В предыдущем разделе мы нашли три висячих указателя:

· Указатель sk, принадлежащий структуре socket.

· Два указателя в перечне хешей поля nl_table в структуре netlink_sock.

Пришло время выяснить, почему возникает крах при отработке концептуального кода.

Что происходит, когда мы нажимаем клавишу во время отработки концептуального кода? Эксплоит просто завершает свою работу, однако сей факт означает многое. Ядру нужно освободить все ресурсы, выделенные для процессора, иначе будет много утечек памяти.

Сама по себе процедура выхода немного сложна. В основном все начинается с функции do_exit(). В некоторый момент происходит освобождение файловых ресурсов. В целом, сценарий выхода такой:

1. Вызывается функция do_exit() ([kernel/exit.c]).

2. Внутри do_exit() вызывается функция exit_files(), которая освобождает ссылку текущей структуры files_struct при помощи функции put_files_struct().

3. Поскольку эта ссылка была последней, put_files_struct() вызывает функцию close_files().

4. Функция close_files() пробегается по таблице файловых дескрипторов и вызывает функцию filp_close() для каждого оставшегося файла.

5. Когда дело доходит до файла, на который указывает дескриптор unblock_fd, функция filp_close() вызывает fput().

6. Поскольку ссылка была последней, вызывается функция __fput().

7. В конце, функция __fput() вызывает файловую операцию file‑>f_op‑>release(), которая представляет собой функцию sock_close().

8. Функция sock_close() вызывает sock‑>ops‑>release() (функцию netlink_release() структуры proto_ops) и устанавливает в поле sock‑>file значение NULL.

9. Начиная с netlink_release(), существует множество операций, приводящих к уязвимости use‑after‑free, что является причиной краха.

Грубо говоря, поскольку мы не закрыли unblock_fd, этот дескриптор будет освобожден по завершению программы. В конце будет запущена функция netlink_release(). Начиная с этой функции, есть множество уязвимостей UAF, и будет большая удача, если не возникнет крах:

static int netlink_release(struct socket *sock)

{

struct sock *sk = sock->sk; // <----- dangling pointer

struct netlink_sock *nlk;

if (!sk) // <----- not NULL because... dangling pointer

return 0;

netlink_remove(sk); // <----- UAF

sock_orphan(sk); // <----- UAF

nlk = nlk_sk(sk); // <----- UAF

// ... cut (more and more UAF) ...

}

Очень много примитивов. Даже слишком. Проблема в том, что каждый примитив должен:

Делать что-то полезное или не выполнять никаких операций (no‑op).

Не вызывать краха (из-за функции BUG_ON()) и плохих разыменований.

По вышеуказанным причинам, функция netlink_release() – не очень хороший кандидат для эксплуатации (см. следующий раздел).

Перед тем как двигаться дальше, убедимся, что мы нашли основную причину краха. Модифицируем и запустим концептуальный код:

int main(void)

{

// ... cut ...

printf("[ ] ready to crash?\n");

PRESS_KEY();

close(unblock_fd);

printf("[ ] are we still alive ?\n");

PRESS_KEY();

}

Прекрасно. Сейчас мы не видим сообщения «[ ] are we still alive?», а, значит, наша догадка оказалась верной, и ядро падает из-за уязвимостей в функции netlink_release(). Также можно сделать еще одни важный вывод:

У нас есть способ активации бреши use‑after‑free в любой момент, когда мы захотим!

Теперь, когда мы нашли висячие указатели, поняли, почему ядро падает и убедились, что можем активировать UAF в любой момент, пришло время написать эксплоит.

Эксплоит (Переразмещение)

«Переходим от теории к практике!»

Вне зависимости от конкретной уязвимости, эксплуатация use‑after‑free (через конфликт типов) требуется переразмещения, для чего требуется соответствующий гаджет, который выполняет эту функцию.

Гаджет переразмещения – это способ спровоцировать ядро на вызов функции kmalloc() (то есть отработку кода ядра) из пространства пользователя (в основном через системный вызов). Идеальный гаджет для переразмещения должен обладать следующими характеристиками:

Быть быстрым: до вызова kmalloc() должен быть путь как можно короче.

Управлять данными: гаджет должен уметь заполнять память, выделенную через kmalloc(), произвольным содержимым.

Не блокировать: гаджет не должен блокировать поток.

Быть гибким: аргумент size функции kmalloc() должен быть управляемым.

К сожалению, довольно сложно найти гаджет, соответствующий всем вышеуказанным условиям. Хорошо известный гаджет - msgsnd() (System V IPC) – быстрый, не блокирует поток, имеет доступ к любому кэшу общего назначения kmem_cache размером 64 байта. Однако вы не сможете управляет данными первых 48 байт (sizeof(struct msg_msg)). Мы не будем использовать этот гаджет, но если вам интересно, изучите функцию sysv_msg_load().

В этом разделе будет рассмотрен другой хорошо известный гаджет: буфер вспомогательных данных (также называемый sendmsg()). Затем мы коснемся главной проблемы, которая может привести к ошибке в эксплоите, и методов минимизации этого риска. В заключении будет рассмотрена реализация переразмещения из пространства пользователя.

Что такое «переразмещение» (SLAB)

Чтобы эксплуатировать уязвимость use‑after‑free через несоответствие типов, нужно разместить управляемый объект на месте старой структуры netlink_sock. Предположим, что этот объект находился по адресу 0xffffffc0aabbcced. Мы не можем изменить это местонахождение!

«Если вы не можете прийти к ним, позвольте им прийти к вам».

Операция размещения объекта в определенном участке памяти называется переразмещением. Обычно в этом участке памяти располагался объект, который только что освобожден (в нашем случае – структура netlink_sock).

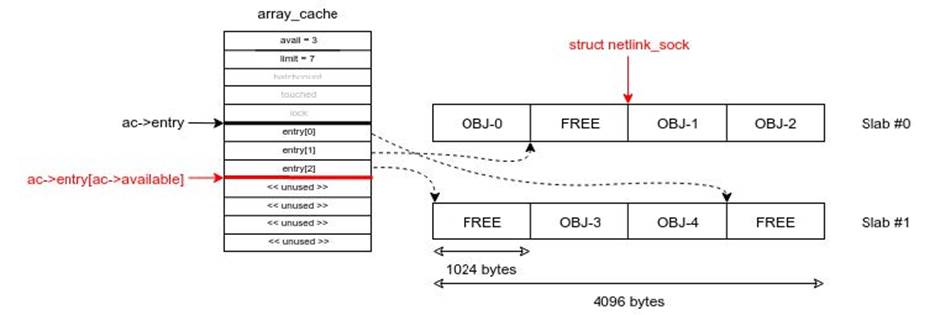

В SLAB аллокаторе переразмещение выполняется довольно просто. Почему? При помощи структуры array_cache SLAB использует алгоритм LIFO. То есть последний освобождаемый участок памяти указанного размера (kmalloc‑1024) будет первым для повторного размещения того же самого размера (см. раздел Базовые концепции #3). Более того, этот механизм не зависит от типа slab. Вы можете пропустить это свойство во время переразмещения при помощи SLUB аллокатора.

Рассмотрим структуру кэша kmalloc‑1024:

Каждый объект в кэше kmalloc‑1024 kmem_cache имеет размер 1024 байт.

Каждый slab состоит из одной страницы (4096 байт). То есть на каждый slab приходится 4 объекта.

Предположим, что кэш состоит из двух slab’ов.

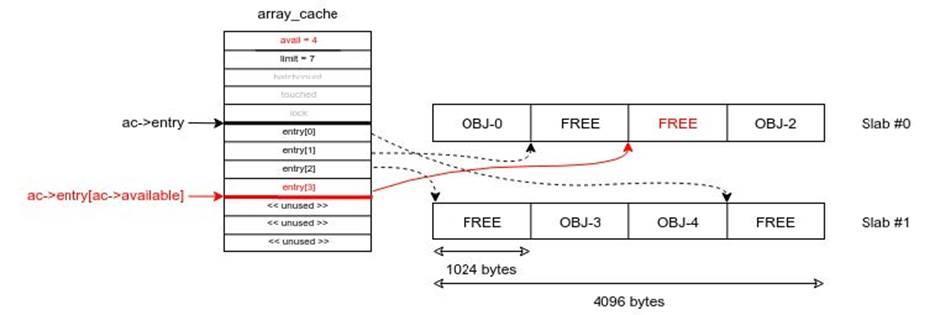

Перед освобождением объекта netlink_sock имеем следующую структуру памяти:

Рисунок 4: Структуру памяти перед освобождением объекта netlink_sock

Обратите внимание, что поле ac‑>available представляет собой индекс (плюс 1) следующего свободного объекта. Затем объект netlink_sock становится свободным. В наибыстрейшем сценарии выполнения кода освобождение объекта (kfree(objp)) эквивалентно следующему выражению:

ac->entry[ac->avail++] = objp; // "ac->avail" is POST-incremented

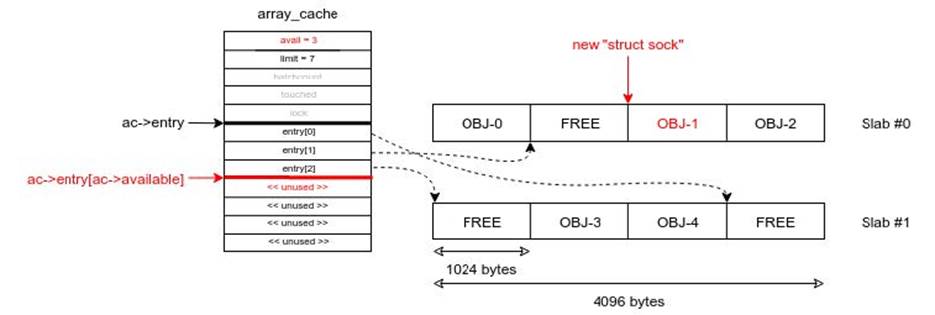

Таким образом, получаем следующую схему.

Рисунок 5: Структуру памяти после освобождения объекта netlink_sock

В конце, объект структуры sock размещается (kmalloc(1024)) при помощи следующей операции (наибыстрейший сценарий):

objp = ac->entry[--ac->avail]; // "ac->avail" is PRE-decremented

Получаем следующую схему:

Рисунок 6: Структуру памяти после повторного размещения объекта netlink_sock

Таким образом, область памяти, где размещена новая структура sock, находится в том же месте, что и старая область памяти, где была структура netlink_sock (например, 0xffffffc0aabbccdd). То есть мы сделали повторное размещение или переразмещение. Неплохо, не так ли?

Выше показан идеальный сценарий. На практике возникает множество подводных камней, о которых мы поговорим позже.

Гаджет для переразмещения

В предыдущих статьях рассматривалось два буфера у сокетов: для отправки и приема. Существует еще опциональный буфер (option buffer), который также называется буфером вспомогательных данных (ancillary data buffer). В этом разделе мы рассмотрим, как заполнить этот буфер произвольными данными и использовать в качестве гаджета для переразмещения.

Этот гаджет доступен из «верхней» части системного вызова sendmsg(). Функция __sys_sendmsg() (практически) напрямую вызывается SYSCALL_DEFINE3 (sendmsg):

static int __sys_sendmsg(struct socket *sock, struct msghdr __user *msg,

struct msghdr *msg_sys, unsigned flags,

struct used_address *used_address)

{

struct compat_msghdr __user *msg_compat =

(struct compat_msghdr __user *)msg;

struct sockaddr_storage address;

struct iovec iovstack[UIO_FASTIOV], *iov = iovstack;

[0] unsigned char ctl[sizeof(struct cmsghdr) + 20]

__attribute__ ((aligned(sizeof(__kernel_size_t))));

/* 20 is size of ipv6_pktinfo */

unsigned char *ctl_buf = ctl;

int err, ctl_len, iov_size, total_len;

// ... cut (copy msghdr/iovecs + sanity checks) ...

[1] if (msg_sys->msg_controllen > INT_MAX)

goto out_freeiov;

[2] ctl_len = msg_sys->msg_controllen;

if ((MSG_CMSG_COMPAT & flags) && ctl_len) {

// ... cut ...

} else if (ctl_len) {

if (ctl_len > sizeof(ctl)) {

[3] ctl_buf = sock_kmalloc(sock->sk, ctl_len, GFP_KERNEL);

if (ctl_buf == NULL)

goto out_freeiov;

}

err = -EFAULT;

[4] if (copy_from_user(ctl_buf, (void __user *)msg_sys->msg_control, ctl_len))

goto out_freectl;

msg_sys->msg_control = ctl_buf;

}

// ... cut ...

[5] err = sock_sendmsg(sock, msg_sys, total_len);

// ... cut ...

out_freectl:

if (ctl_buf != ctl)

[6] sock_kfree_s(sock->sk, ctl_buf, ctl_len);

out_freeiov:

if (iov != iovstack)

sock_kfree_s(sock->sk, iov, iov_size);

out:

return err;

}

Функция __sys_sendmsg делает следующее:

[0] – объявляет в стеке буфер ctl размером 36 байт (16 + 20).

[1] – проверяет, чтобы пользовательская переменная msg_controllen была меньше или равна, чем INT_MAX.

[2] – копирует пользовательскую переменную msg_controllen в буфер ctl_len.

[3] – размещает буфер ядра ctl_buf размером ctl_len при помощи функции kmalloc().

[4] – копирует байты пользовательских данных в количестве ctl_len из msg_control в буфер ядра ctl_buf, размещенный в шаге [3].

[5] – вызывает функцию sock_sendmsg(), которая вызывает sock‑>ops‑>sendmsg() (обратный вызов сокета).

[6] – освобождает буфер ядра ctl_buf.

Обратите внимание, что в этой функции происходит обработка множества пользовательских данных, что нам очень нравится. Если подытожить вышеупомянутые шаги, то мы можем разместить буфер ядра при помощи функции kmalloc():

Поле msg‑>msg_controllen может быть произвольного размера (должно быть больше 36, но меньше INT_MAX).

Поле msg‑>msg_control может содержать произвольные данные.

Рассмотрим, что делает функция sock_kmalloc():

void *sock_kmalloc(struct sock *sk, int size, gfp_t priority)

{

[0] if ((unsigned)size <= sysctl_optmem_max &&

atomic_read(&sk->sk_omem_alloc) + size < sysctl_optmem_max) {

void *mem;

/* First do the add, to avoid the race if kmalloc

* might sleep.

*/

[1] atomic_add(size, &sk->sk_omem_alloc);

[2] mem = kmalloc(size, priority);

if (mem)

[3] return mem;

atomic_sub(size, &sk->sk_omem_alloc);

}

return NULL;

}

Во-первых, аргумент size сравнивается с параметром ядра «optmem_max» [0], который можно извлечь при помощи следующей команды:

$ cat /proc/sys/net/core/optmem_max

Если аргумент size меньше, чем тот параметр, то значение size добавляется к размеру буфера текущей вспомогательной памяти (option memory buffer size), после чего опять проверяется, меньше ли полученное значение, чем «optmem_max» [0]. Мы должны сделать эту проверку в эксплоите. Не забывайте, что нашим целевым кэшем kmem_cache является kmalloc‑1024. Если размер «optmem_max» меньше или равен 512, то нам нужно найти другой гаджет для переразмещения. При создании объекта sock в поле sk_omem_alloc во время инициализации устанавливается 0.

Примечание: Не забывайте, что kmalloc(512 + 1) будет попадать в кэш kmalloc‑1024.

Если проверка [0] пройдена, затем sk_omem_alloc увеличивается на значение size [1]. Далее будет вызов kmalloc() с аргументом size. Если вызов завершится успешно, будет возвращен указатель [3], иначе – sk_omem_alloc уменьшается на значение size и функция вернет NULL.

Таким образом, мы можем вызвать kmalloc() с практически произвольным аргументом size (в диапазоне ([36, sysctl_optmem_max]). Содержимое также будет заполнено произвольными данными. Однако существует проблема. Буфер ctl_buf будет автоматически освобожден при выходе из функции (см. строку [6] в предыдущем листинге). Таким образом, вызов [5] sock_sendmsg() (т.е. обратный вызов sock‑>ops‑>sendmsg()) должен заблокироваться.

Блокировка sendmsg()

В предыдущей статье было рассмотрено, как заблокировать вызов sendmsg(), а конкретно – при помощи заполнение буфера приема. Сразу возникает идея, провернуть тот же трюк с функцией netlink_sendmsg(), но к сожалению в этом случае данный метод не сработает. Причина заключается в том, что функция netlink_sendmsg() будет вызывать netlink_unicast(), которая в свою очередь вызывает netlink_getsockbypid(). Таким образом, будет разыменован висячий указатель в списке хешей поля nl_table (т.е. возникнет уязвимость use‑after‑free).

То есть нужно использовать другой тип сокетов: AF_UNIX. Вероятно, может подойти и какой-то альтернативный вариант, но главное преимущество AF_UNIX в том, что это семейство сокетов присутствует практически в каждой системе и не требует особых привилегий.

Предупреждение: Мы не будем описывать реализацию AF_UNIX (в частности функцию unix_dgram_sendmsg()), поскольку повествование займет слишком много времени. На самом деле, много схожих моментов с сокетами AF_NETLINK, и нам важно понять два аспекта:

· Размещение произвольных данных во «вспомогательном» буфере (см. последний раздел).

· Блокировка вызова unix_dgram_sendmsg().

Как и netlink_unicast(), функция sendmsg() может быть заблокирована, если:

1. Целевой буфер приема полный.

2. Таймаут сокета равен MAX_SCHEDULE_TIMEOUT.

В функции unix_dgram_sendmsg() (как и в netlink_unicast()) значение timeo вычисляется по следующей формуле:

timeo = sock_sndtimeo(sk, msg->msg_flags & MSG_DONTWAIT);

static inline long sock_sndtimeo(const struct sock *sk, int noblock)

{

return noblock ? 0 : sk->sk_sndtimeo;

}

Таким образом, если мы не установим аргумент noblock (т.е. не будем использовать MSG_DONTWAIT), таймаут будет равен sk_sndtimeo. Этим значением можно управлять через функцию setsockopt():

int sock_setsockopt(struct socket *sock, int level, int optname, char __user *optval, unsigned int optlen)

{

struct sock *sk = sock->sk;

// ... cut ...

case SO_SNDTIMEO:

ret = sock_set_timeout(&sk->sk_sndtimeo, optval, optlen);

break;

// ... cut ...

}

Которая вызывает функцию sock_set_timeout():

static int sock_set_timeout(long *timeo_p, char __user *optval, int optlen)

{

struct timeval tv;

if (optlen < sizeof(tv))

return -EINVAL;

if (copy_from_user(&tv, optval, sizeof(tv)))

return -EFAULT;

if (tv.tv_usec < 0 || tv.tv_usec >= USEC_PER_SEC)

return -EDOM;

if (tv.tv_sec < 0) {

// ... cut ...

}

*timeo_p = MAX_SCHEDULE_TIMEOUT; // <-----

if (tv.tv_sec == 0 && tv.tv_usec == 0) // <-----

return 0; // <-----

// ... cut ...

}

В конце если мы вызовем setsockopt() с опцией SO_SNDTIMEO и передадим структуру timeval, заполненную нулями, таймаут будет равен MAX_SCHEDULE_TIMEOUT, и возникнет бесконечная блокировка. Для этой операции не требуется специальных привилегий.

Одна проблема решена.

Вторая проблема заключается в том, нам нужно иметь дело с кодом, который использует данные буфера управления. Этот код отрабатывает на очень ранней стадии в функции unix_dgram_sendmsg():

static int unix_dgram_sendmsg(struct kiocb *kiocb, struct socket *sock, struct msghdr *msg, size_t len)

{

struct sock_iocb *siocb = kiocb_to_siocb(kiocb);

struct sock *sk = sock->sk;

// ... cut (lots of declaration) ...

if (NULL == siocb->scm)

siocb->scm = &tmp_scm;

wait_for_unix_gc();

err = scm_send(sock, msg, siocb->scm, false); // <----- here

if (err < 0)

return err;

// ... cut ...

}

Мы уже прошли эту проверку во второй части, но сейчас появилось нечто другое:

static __inline__ int scm_send(struct socket *sock, struct msghdr *msg,

struct scm_cookie *scm, bool forcecreds)

{

memset(scm, 0, sizeof(*scm));

if (forcecreds)

scm_set_cred(scm, task_tgid(current), current_cred());

unix_get_peersec_dgram(sock, scm);

if (msg->msg_controllen <= 0) // <----- this is NOT true anymore

return 0;

return __scm_send(sock, msg, scm);

}

Поскольку сейчас мы используем буфер msg_control (то есть msg_controllen больше нуля), то не можем обойти вызов __scm_send(), а значит эта функция должна вернуть 0.

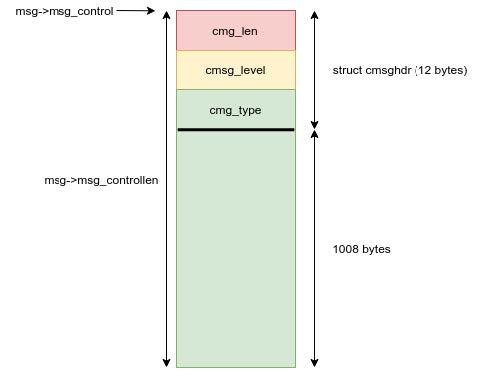

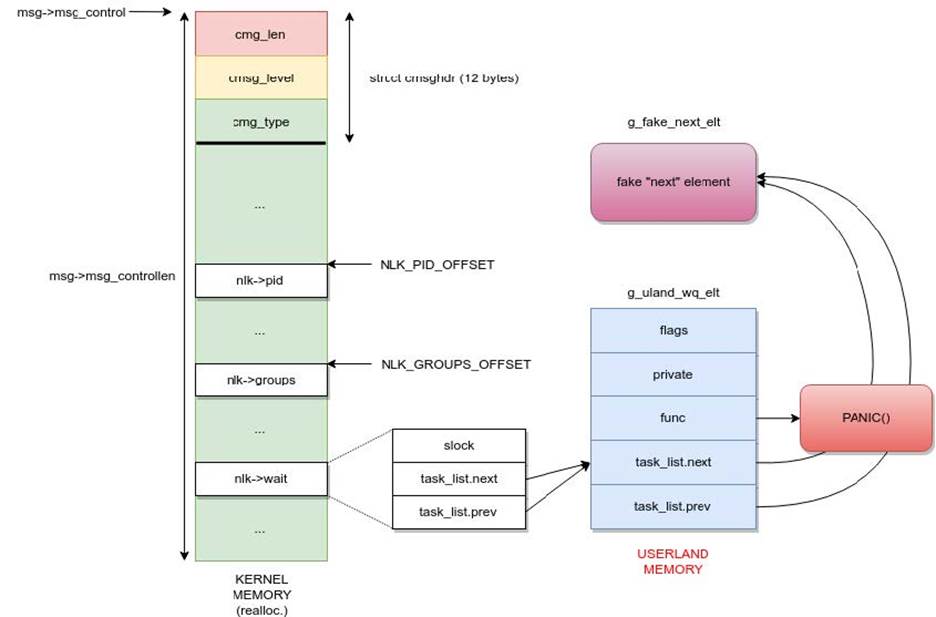

Переходим к рассмотрению структуры объекта, связанного со вспомогательными данными:

struct cmsghdr {

__kernel_size_t cmsg_len; /* data byte count, including hdr */

int cmsg_level; /* originating protocol */

int cmsg_type; /* protocol-specific type */

};

Эта структура данных размером 16 байт, которая должна быть расположена в самом начале буфера msg_control (куда мы помещаем произвольные данные). Назначение этой структуры зависит от типа сокета. Можно рассматривать эту структуру как инструмент, чтобы «сделать что-то особенное» с сокетом. Например, в случае с UNIX-сокетом можно передать «учетные данные» через сокет.

Буфер управляющих сообщений (msg_control) может хранить одно или более управляющих сообщений. Каждое управляющее сообщение содержит заголовок и данные.

Заголовок первого управляющего сообщения извлекается при помощи макроса CMSG_FIRSTHDR():

#define CMSG_FIRSTHDR(msg) __CMSG_FIRSTHDR((msg)->msg_control, (msg)->msg_controllen)

#define __CMSG_FIRSTHDR(ctl,len) ((len) >= sizeof(struct cmsghdr) ? \

(struct cmsghdr *)(ctl) : \

(struct cmsghdr *)NULL)

Таким образом, проверяется, больше ли значение msg_controllen, чем 16 байт. Если нет, тогда буфер управляющего сообщения даже не содержит заголовок сообщение! В этом случае возвращается NULL. Иначе возвращается начальный адрес первого управляющего сообщения (msg_control).

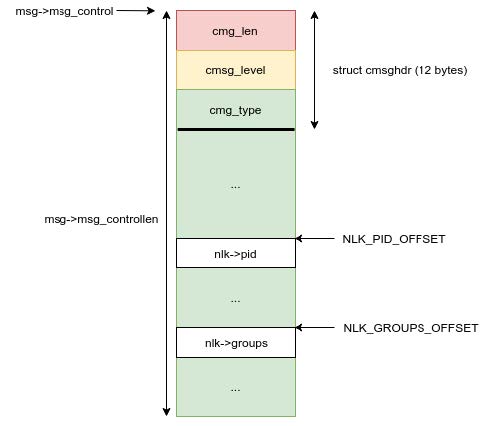

Чтобы найти следующее управляющее сообщение, нужно использовать макрос CMG_NXTHDR(), который предназначен для получения стартового адреса заголовка следующего управляющего сообщения:

#define CMSG_NXTHDR(mhdr, cmsg) cmsg_nxthdr((mhdr), (cmsg))

static inline struct cmsghdr * cmsg_nxthdr (struct msghdr *__msg, struct cmsghdr *__cmsg)

{

return __cmsg_nxthdr(__msg->msg_control, __msg->msg_controllen, __cmsg);

}

static inline struct cmsghdr * __cmsg_nxthdr(void *__ctl, __kernel_size_t __size,

struct cmsghdr *__cmsg)

{

struct cmsghdr * __ptr;